Le patron d’Instagram estime qu’il sera plus pratique d’identifier les humains que les IA

« Le vrai est un moment du faux » (La société du spectacle)

Les fulgurantes avancées en matière de contenus générés par IA, notamment (audio)visuels, rendront de plus en plus difficile le fait d’identifier ceux qui cherchent à imiter voire usurper des contenus humains. Le patron d’Instagram propose dès lors de renverser la charge de la preuve, en identifiant plus formellement les contenus créés par des humains.

« De plus en plus de personnes pensent qu’il sera plus pratique d’identifier les médias authentiques que les faux générés par IA », estime Adam Mosseri, l’ex-cadre supérieur de Facebook nommé patron d’Instagram depuis la démission de ses cofondateurs en 2018 : « Les fabricants d’appareils photo pourraient signer cryptographiquement les images au moment de la capture, créant ainsi une chaîne de contrôle ».

Dans un message partagé sur Insta et Threads, Adam Mosseri constate que « l’authenticité devient infiniment reproductible » du fait du perfectionnement des IA génératives. Ce pourquoi « le principal risque » auquel est confrontée une plateforme comme Instagram est qu’elle ne parvienne pas à suivre le rythme, et qu’elle finisse par être submergée de contenus générés par IA (GenAI) :

« Tout ce qui rendait les créateurs importants – leur capacité à être authentiques, à créer des liens, à avoir une voix qui ne pouvait être imitée – est désormais accessible à quiconque dispose des bons outils. Les deepfakes sont de plus en plus perfectionnés. L’IA génère des photos et des vidéos impossibles à distinguer des médias capturés [par des humains, ndlr]. Les flux commencent à se remplir de contenus synthétiques. »

Le pouvoir passe des institutions aux individus, et maintenant aux IA

Cherchant à anticiper ce qu’il pourrait faire pour ne pas être submergé, Adam Mosseri rappelle tout d’abord que « depuis des années, le pouvoir passe des institutions aux individus, car Internet permet à toute personne ayant une idée convaincante de trouver un public » :

« Le coût de la diffusion de l’information est pratiquement nul. Les gens peuvent donc désormais contourner les moyens traditionnels de diffusion de l’information (journaux distribués par camion, émissions produites pour la télévision) et s’adresser directement à leur public. On le constate dans tous les domaines, des athlètes qui sont plus importants que leurs équipes aux journalistes qui inspirent plus confiance que leurs publications. »

Alors que « la confiance dans les institutions (gouvernement, médias, entreprises) est en déclin depuis des décennies » et que nous sommes dans le même temps « submergés par le contenu produit à grande échelle par les institutions », « ce sont des individus, et non des éditeurs, des médias ou des marques », qui ont créé ce marché de créateurs de contenus autoproduits par des « personnes que nous admirons ».

L’authenticité devient une ressource rare

Évoquant les contenus synthétiques qui, d’ici quelques années, « seront bien plus nombreux que ceux capturés par des moyens traditionnels », le patron d’Instagram relève que, si l’on parle beaucoup de l’ « AI slop », « il existe heureusement beaucoup de contenus IA incroyables [et] de qualité ».

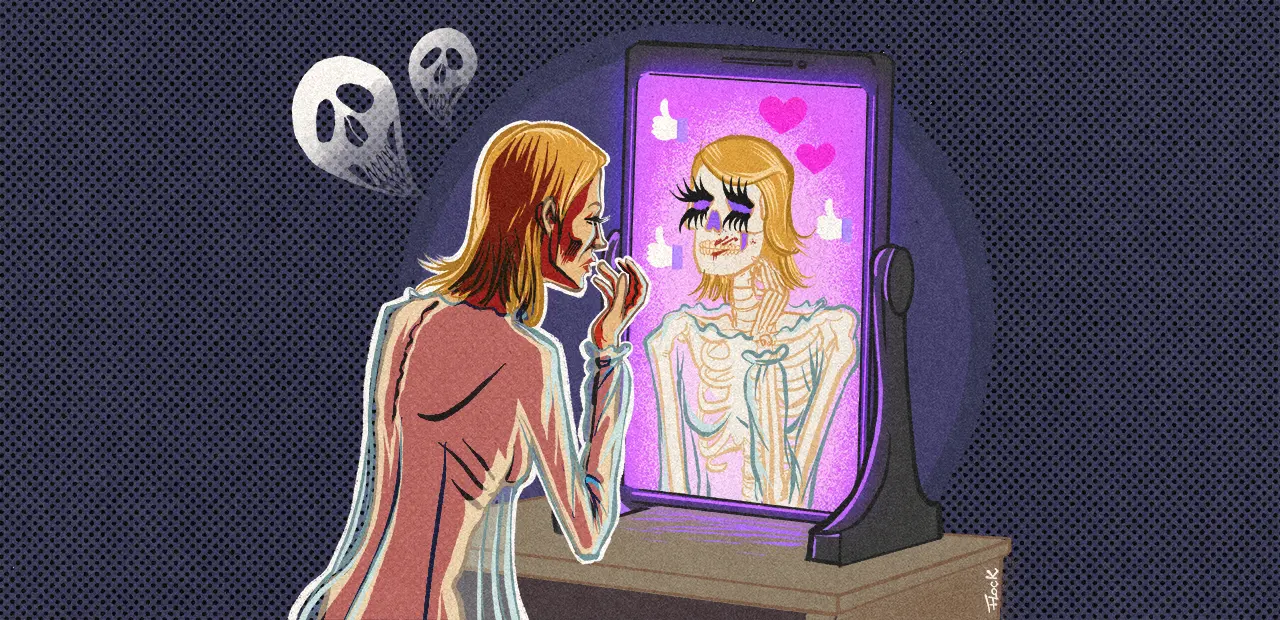

Il constate cela dit que les contenus générés par IA sont « de plus en plus réalistes » et que « l’authenticité devient une ressource rare », ce qui, d’après lui, va entraîner une augmentation de la demande de contenus créés par des humains. Il estime aussi que « les créateurs qui réussiront seront ceux qui trouveront le moyen de préserver leur authenticité, qu’ils adoptent ou non les nouvelles technologies » :

« Cela devient plus difficile (et non pas plus facile) aujourd’hui parce que tout le monde peut simuler l’authenticité. La question n’est plus de savoir si vous êtes capable de créer du contenu, mais de savoir si vous êtes le seul à pouvoir le faire. Et cela va devenir la nouvelle condition à remplir. »

Privilégier des images explicitement non retouchées et peu flatteuses

Adam Mosseri note aussi que, dans le même temps, les appareils photo des téléphones proposent de plus en plus de fonctionnalités et de filtres logiciels permettant à de simples amateurs de pouvoir partager des contenus de qualité quasi professionnelle.

Le patron d’Instagram estime à ce titre que leurs fabricants font de mauvais choix esthétiques et « romantisent le passé » : « Ils rivalisent pour donner à tout le monde l’air d’un photographe professionnel d’autrefois », permettant à tout un chacun de réaliser des photographies tendant vers la perfection, mais qui ne pourront pas longtemps rivaliser avec les IA.

Ces dernières parviennent en effet désormais à générer des images tellement « parfaites » qu’il devient impossible de les identifier comme synthétiques à l’œil nu. Dès lors, ce n’est plus la perfection qu’il faut chercher, mais l’imperfection, avance Adam Mosseri :

« On va assister à une nette accélération de la tendance vers une esthétique plus brute dans les prochaines années. Les créateurs avisés vont privilégier des images d’eux-mêmes explicitement non retouchées et peu flatteuses. Dans un monde où tout peut être parfait, l’imperfection devient un signal. Le caractère brut [« rawness », en VO] n’est plus seulement une préférence esthétique : c’est une preuve. C’est une forme de défense. Une façon de dire : c’est authentique parce que c’est imparfait. »

De la quête de perfection à celle de l’imperfection

Patron d’une entreprise dont le modèle économique repose sur le partage de selfies et de photos retouchées au moyen de filtres logiciels, cet abandon de la quête de perfection pour celle de l’imperfection ressemble à une révolution quasi-copernicienne :

« Pendant la majeure partie de ma vie, j’ai pu supposer sans risque que la grande majorité des photos ou des vidéos que je voyais étaient des captures fidèles de moments qui s’étaient réellement produits dans la vie réelle. Ce n’est clairement plus le cas aujourd’hui, et il nous faudra, en tant qu’êtres humains, des années pour nous y adapter. […] Cela va être extrêmement inconfortable pour nous tous, car nous sommes génétiquement prédisposés à croire ce que nous voyons. »

Ce changement de paradigme fera qu’ « au fil du temps, nous allons passer d’une attitude consistant à supposer que ce que nous voyons est réel par défaut à une attitude sceptique lorsque nous consultons les médias, et nous allons accorder beaucoup plus d’attention à ceux qui partagent quelque chose et aux raisons pour lesquelles ils le font ».

Les plateformes de réseaux sociaux vont dès lors subir une pression croissante pour identifier et signaler les contenus générés par l’IA. Le patron d’Instagram ne le précise pas, mais l’article 50 de l’AI Act rendra cette labellisation des contenus GenAI obligatoire à compter du mois d’août 2026.

« Toutes les grandes plateformes feront du bon travail pour identifier les contenus générés par l’IA, mais elles auront de plus en plus de mal à le faire à mesure que l’IA s’améliorera dans l’imitation de la réalité », relève toutefois Adam Mosseri :

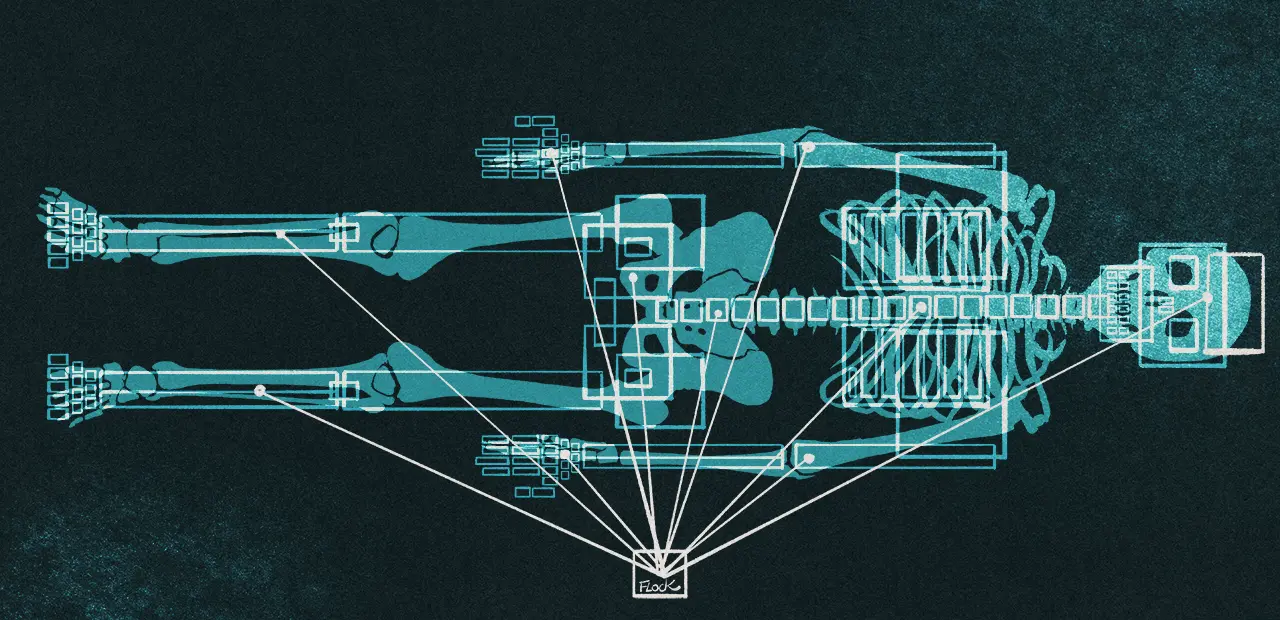

« De plus en plus de personnes pensent, comme moi, qu’il sera plus pratique d’identifier les médias authentiques que les faux. Les fabricants d’appareils photo pourraient signer cryptographiquement les images au moment de la capture, créant ainsi une chaîne de contrôle. »

Instagram devra « clairement identifier les contenus générés par l’IA »

Il souligne cependant que le fait d’ « indiquer si un contenu est authentique ou généré par l’IA n’est qu’une partie de la solution ». Les plateformes et acteurs du marché de l’économie de l’attention devront également « fournir beaucoup plus d’informations contextuelles », non seulement sur les médias mais aussi sur les comptes qui les partagent, « afin que les utilisateurs puissent prendre des décisions éclairées sur ce qu’ils doivent croire » :

« Où se trouve le compte ? Quand a-t-il été créé ? Quels autres contenus a-t-il publiés ? Dans un monde où l’abondance et le doute sont infinis, les créateurs qui parviennent à maintenir la confiance et à afficher leur authenticité, en étant sincères, transparents et cohérents, se démarqueront. »

Évoquant le cas particulier d’Instagram, Adam Mosseri explique que ses équipes vont devoir « évoluer de plusieurs façons, et rapidement ». À commencer par le fait de créer les meilleurs outils, « basés sur l’IA ou traditionnels », pour que les créateurs « puissent rivaliser avec les contenus entièrement créés par l’IA ».

Instagram devra aussi « clairement identifier les contenus générés par l’IA » et travailler avec les fabricants pour vérifier leur authenticité « dès leur capture, en identifiant les médias réels, et pas seulement en traquant les faux ». Ainsi que pour « mettre en avant les signaux de crédibilité » concernant les auteurs des publications afin que les utilisateurs puissent décider à qui faire confiance.

Il évoque enfin le fait de « devoir continuer à améliorer le classement en fonction de l’originalité », et propose de revenir sur la question de la transparence et du contrôle des algorithmes dans un autre article.