Doom, Mario, Civilization : les IA génératives peuvent-elles terminer des jeux des années 90 ?

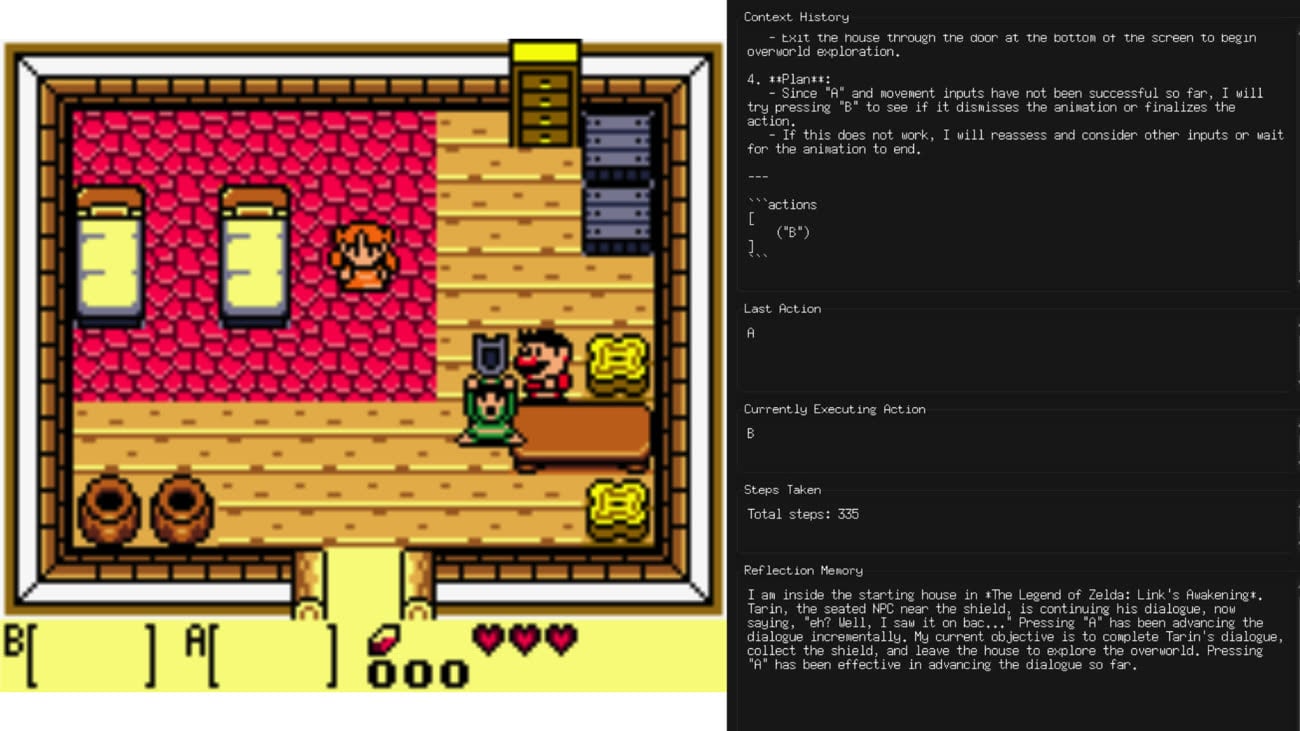

Cela fait plusieurs mois que des petits malins s’amusent à essayer de faire jouer les IA génératives à des jeux vidéo : la chaîne Twitch Claude Plays Pokemon montre par exemple le modèle d’Anthropic tentant de venir à bout de Pokémon Rouge grâce à ses capacités de vision par ordinateur. Le chercheur Alex Zhang va plus loin et a créé VideoGameBench, un benchmark qui cherche à voir si les modèles d’IA peuvent terminer une vingtaine de jeux vidéo tournant en temps réel. Le test repose sur des titres des années 90 aux genres variés.

Alex Zhang note que, si les LLM peuvent effectuer certaines actions complexes, ils sont bien en peine de venir à bout de jeux vidéo demandant de raisonner à court et à long terme, en plus de faire preuve d’intuition et de compréhension de l'espace. Son benchmark fournit l’essentiel à l’IA, à savoir l’image du jeu, une « manette » virtuelle et une indication claire si un jeu est terminé. Les titres présentés sont principalement des jeux Game Boy ou MS-DOS pour la bonne raison que les repères visuels sont plus simples que ceux des jeux plus récents, et car ils requièrent de faire appel à une manette comme à une souris, ce qui pose des défis variés.

Les genres sont multiples, avec de la plateforme (Super Mario Land) ou des titres plus calmes comme Pokémon Crystal ou Civilization 1. Certains jeux nerveux tels Doom ou Quake sont au programme, pour lesquels Alex Zhang a dû ruser : ceux-là se mettent automatiquement en pause lorsque le LLM « réfléchit », ce qui lui évite de se faire tuer directement par un ennemi lui tirant dessus.

Quelle observation tirer de tout cela ? Eh bien que les modèles d’IA doués de vision sont bien loin de pouvoir terminer un jeu complet, et qu’ils peinent globalement à arriver au bout du premier niveau de chaque titre. Les IA prennent entre 3 et 5 secondes pour effectuer une action, ce qui est bien trop lent pour certains jeux comme Mario où les premiers ennemis arrivent déjà plutôt lentement.

L’expérience met en lumière certaines difficultés des modèles, ayant parfois du mal à interpréter ce qu’ils « voient ». La vidéo ci-dessous montre Claude en train de gaspiller ses balles sur un ennemi… déjà à terre, ce qui l’empêche d’aller bien loin. L’IA a aussi du mal à être précise avec un combo clavier/souris, ce qui est capital dans des jeux comme Civilization ou Warcraft. Enfin, les modèles ne comprennent pas certaines mécaniques des jeux peu intuitives, qu’ils sont incapables de deviner sur le tas (par exemple les techniques pour battre un boss).

Alex Zhang n’indique pas quel modèle commercial est le plus efficace, mais explique que GPT-4o, Claude Sonnet 3.7, Gemini 2.5 Pro et Gemini 2.0 Flash sont incapables de venir à bout du premier niveau de Doom. Le projet est disponible gratuitement sur GitHub si vous voulez l’essayer en local.