Data Centers Are Driving a US Gas Boom

AlphaGenome can analyse up to 1m letters of DNA code at once and could pave way for new treatments

Researchers at Google DeepMind have unveiled their latest artificial intelligence tool and claimed it will help scientists identify the genetic drivers of disease and ultimately pave the way for new treatments.

AlphaGenome predicts how mutations interfere with the way genes are controlled, changing when they are switched on, in which cells of the body, and whether their biological volume controls are set to high or low.

Continue reading...

© Photograph: Vitaliy Smolygin/Alamy

© Photograph: Vitaliy Smolygin/Alamy

© Photograph: Vitaliy Smolygin/Alamy

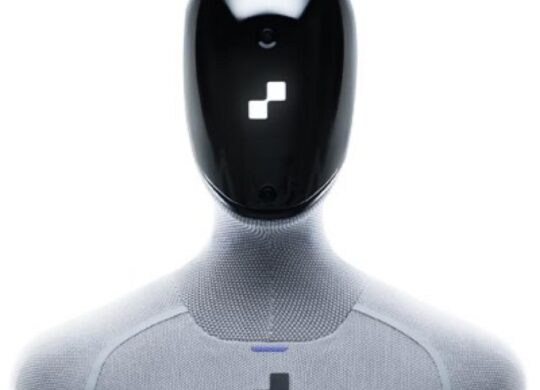

La startup américaine Figure AI vient de franchir une étape majeure dans l’histoire de la robotique humanoïde. Avec son nouveau modèle d’intelligence artificielle Helix 02, l’entreprise parvient à unifier locomotion, manipulation et équilibre au sein d’un même système neuronal, ouvrant ainsi la voie à des robots capables d’évoluer …

Aimez KultureGeek sur Facebook, et suivez-nous sur Twitter

N'oubliez pas de télécharger notre Application gratuite iAddict pour iPhone et iPad (lien App Store)

L’article Figure AI dévoile Helix 02, une IA qui rapproche le robot humanoïde de l’autonomie totale est apparu en premier sur KultureGeek.

La startup américaine Figure AI vient de franchir une étape majeure dans l’histoire de la robotique humanoïde. Avec son nouveau modèle d’intelligence artificielle Helix 02, l’entreprise parvient à unifier locomotion, manipulation et équilibre au sein d’un même système neuronal, ouvrant ainsi la voie à des robots capables d’évoluer …

Aimez KultureGeek sur Facebook, et suivez-nous sur Twitter

N'oubliez pas de télécharger notre Application gratuite iAddict pour iPhone et iPad (lien App Store)

L’article Figure AI dévoile Helix 02, une IA qui rapproche le robot humanoïde de l’autonomie totale est apparu en premier sur KultureGeek.

World’s richest person targeting symbolic date in June for flotation of rocket company

Elon Musk’s SpaceX is considering a flotation valuing the rocket company at $1.5tn (£1.1tn) that will reportedly be timed for early summer to coincide with a planetary alignment and the multibillionaire’s birthday.

The world’s richest person is targeting a symbolic date of mid-June for the initial public offering, according to the Financial Times. This would be around the same time as Jupiter and Venus appear in close proximity to each other and shortly before Musk turns 55 on 28 June.

Continue reading...

© Photograph: Kaylee Greenlee Beal/Reuters

© Photograph: Kaylee Greenlee Beal/Reuters

© Photograph: Kaylee Greenlee Beal/Reuters

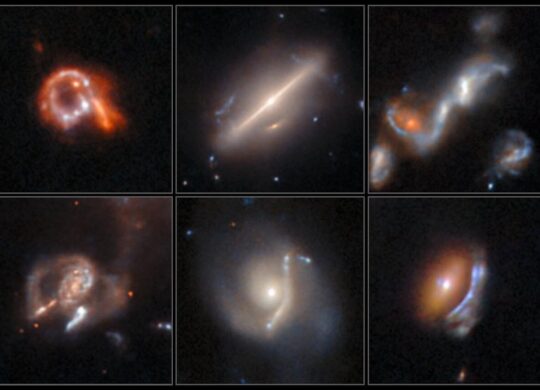

L’intelligence artificielle continue de transformer la recherche scientifique, et l’astronomie en offre une nouvelle démonstration spectaculaire. Deux chercheurs de l’Agence spatiale européenne (ESA) ont ainsi mis au point un outil basé sur un réseau neuronal capable d’explorer automatiquement des volumes massifs d’images spatiales. En moins de trois jours, …

Aimez KultureGeek sur Facebook, et suivez-nous sur Twitter

N'oubliez pas de télécharger notre Application gratuite iAddict pour iPhone et iPad (lien App Store)

L’article Une IA révèle plus de 800 anomalies cosmiques dans les archives de Hubble est apparu en premier sur KultureGeek.

Island’s mineral and resource wealth is result of mountain building, rifting and volcanic activity over 4bn years

As recent manoeuvres over Greenland have made plain, this mostly ice-covered island contains some of the greatest stores of natural resources in the world, with huge volumes of oil and gas, rich deposits of rare-earth elements and rocks bearing gems and gold. So why did all the planetary goodies end up here?

Writing in The Conversation, the geologist Dr Jonathan Paul from Royal Holloway, University of London, explains how this mineral and resource wealth is tied to the country’s geological history over the past 4bn years. Greenland is a bit of a geological anomaly, with land that has been pummelled in three different ways: mountain building, rifting and volcanism.

Continue reading...

© Photograph: Greenland Minerals Ltd/Reuters

© Photograph: Greenland Minerals Ltd/Reuters

© Photograph: Greenland Minerals Ltd/Reuters

Find suggests prehistoric humans showed complex planning and understanding of how to enhance tool performance

© Hulk Yuan