Judge Orders Release of 5-Year-Old Detained by Immigration Agents in Minnesota

© Agence France-Presse, via Columbia Heights Public Schools

© Agence France-Presse, via Columbia Heights Public Schools

Retrouvez un résumé du meilleur de l’actu tech tous les matins sur WhatsApp, c’est notre nouveau canal de discussion Frandroid que vous pouvez rejoindre dès maintenant !

Chaque matin, WhatsApp s’anime avec les dernières nouvelles tech. Rejoignez notre canal Frandroid pour ne rien manquer !

© Spencer Platt/Getty Images

Si vous n’arrivez plus à contrôler votre installation HomeKit depuis votre iPhone ou votre HomePod, le problème peut venir du concentrateur utilisé. Voici comment le changer.

Si vous n’arrivez plus à contrôler votre installation HomeKit depuis votre iPhone ou votre HomePod, le problème peut venir du concentrateur utilisé. Voici comment le changer.

Téléchargez notre application Android et iOS ! Vous pourrez y lire nos articles, dossiers, et regarder nos dernières vidéos YouTube.

Chaque matin, WhatsApp s’anime avec les dernières nouvelles tech. Rejoignez notre canal Frandroid pour ne rien manquer !

Chaque jour nous dénichons pour vous des promos sur les produits High-Tech pour vous faire économiser le plus d’argent possible. Voici la liste des bons plans du jour (valable au moment où nous écrivons ces lignes) : Les stocks des produits sont limités, les prix peuvent donc remonter …

Aimez KultureGeek sur Facebook, et suivez-nous sur Twitter

N'oubliez pas de télécharger notre Application gratuite iAddict pour iPhone et iPad (lien App Store)

L’article [#Soldes] Les promos High-Tech du 30 janvier est apparu en premier sur KultureGeek.

Même si The Midnight Walkers nous avait laissé de marbre depuis son annonce, cet extraction shooter coopératif où vous fracasserez du zombie et du survivant, est finalement sorti en accès anticipé ce 29 janvier. Sans surprise, sur Steam, les joueurs sont partagés et ont globalement donné une note moyenne au jeu. Les pros trouvent que le concept est intéressant et n’hésitent pas à l’encenser en citant des références telles qu’Arc Raiders, Dark and Darker, ou encore Dead Island. Les antis soulignent que les mouvements des personnages sont trop lents, la parade et le sprint sont aux abonnés absents, l’optimisation est aux fraises et le PvE (les zombies déboitent très facilement tout le monde) comme le PvP (certaines classes de survivants semblent trop avantagées) est mal équilibré.

Pour marquer le lancement du jeu, les devs ont publié une bande-annonce présentant du gameplay pour le moins dynamique. Mais, le plus intéressant et ironique reste l’espace des commentaires désactivé comme si des centaines de milliers de détracteurs allaient s’empresser de dégommer le studio, alors que soyons honnêtes, tout le monde s’en fout.

Enfin, pour les fans hardcores, il existe le fameux DLC Supporter Pack (cette nouvelle arnaque soutenue par une partie des devs, qui pullule depuis un moment) pour un contenu qui ne vaut pas absolument pas son prix. Ici, pour environ 15 €, soit plus de 80 % du prix de base de l’accès anticipé, vous profiterez de deux skins et d’une réserve supplémentaire (un espace de stockage probablement).

À la rédac, on est toujours pas emballé par The Midnight Walkers. Ne vous attendez donc pas à une preview sur ce dernier. Si vous y avez joué, n’hésitez pas à nous faire part de vos retours dans l’espace commentaire. Pour sa sortie en accès anticipé, The Midnight Walkers bénéficie d’une promotion de lancement de -20 % sur Steam, soit un peu moins de 15 €, si vous êtes intéressé.

Même si The Midnight Walkers nous avait laissé de marbre depuis son annonce, cet extraction shooter coopératif où vous fracasserez du zombie et du survivant, est finalement sorti en accès anticipé ce 29 janvier. Sans surprise, sur Steam, les joueurs sont partagés et ont globalement donné une note moyenne au jeu. Les pros trouvent que le concept est intéressant et n’hésitent pas à l’encenser en citant des références telles qu’Arc Raiders, Dark and Darker, ou encore Dead Island. Les antis soulignent que les mouvements des personnages sont trop lents, la parade et le sprint sont aux abonnés absents, l’optimisation est aux fraises et le PvE (les zombies déboitent très facilement tout le monde) comme le PvP (certaines classes de survivants semblent trop avantagées) est mal équilibré.

Pour marquer le lancement du jeu, les devs ont publié une bande-annonce présentant du gameplay pour le moins dynamique. Mais, le plus intéressant et ironique reste l’espace des commentaires désactivé comme si des centaines de milliers de détracteurs allaient s’empresser de dégommer le studio, alors que soyons honnêtes, tout le monde s’en fout.

Enfin, pour les fans hardcores, il existe le fameux DLC Supporter Pack (cette nouvelle arnaque soutenue par une partie des devs, qui pullule depuis un moment) pour un contenu qui ne vaut pas absolument pas son prix. Ici, pour environ 15 €, soit plus de 80 % du prix de base de l’accès anticipé, vous profiterez de deux skins et d’une réserve supplémentaire (un espace de stockage probablement).

À la rédac, on est toujours pas emballé par The Midnight Walkers. Ne vous attendez donc pas à une preview sur ce dernier. Si vous y avez joué, n’hésitez pas à nous faire part de vos retours dans l’espace commentaire. Pour sa sortie en accès anticipé, The Midnight Walkers bénéficie d’une promotion de lancement de -20 % sur Steam, soit un peu moins de 15 €, si vous êtes intéressé.

The first lady’s premiere was marked by conspicuous absences. It turns out chumminess with the president might just come at a cost

Who wasn’t on the red carpet at the official Melania documentary premiere in Washington DC was so much more intriguing than who was. No offence to defence secretary Pete Hegseth, but if I wanted to see formalwear struggling to contain Crusades tattoos, I’d hang around outside the Spartak Moscow Christmas party. Not that it was a red carpet, because the carpet at the “Trump-Kennedy” Center was black. No one bothers hiding the grift any more, with the movie’s own producer openly explaining that this aesthetic was “all about supporting this luxury brand that [Melania’s] creating”. They should have dressed the event like a colon, since Donald’s is effectively where it was being held.

Anyway: arrivals. There was Melania and Donald Trump – she finally got him out of hair and makeup – who were holding hands, a coincidentally convenient way to cover his skin if his glam squad didn’t truck in enough concealer. In recent months, Trump has had terrible bruises on the tops of his hands and even more terrible excuses for why they keep appearing. Aspirin, Swiss furniture, shaking lots of hands – the list of things that aren’t cannula sites grows longer every week.

Marina Hyde is a Guardian columnist

Continue reading...

© Photograph: Brendan Smialowski/AFP/Getty Images

© Photograph: Brendan Smialowski/AFP/Getty Images

© Photograph: Brendan Smialowski/AFP/Getty Images

Read the full article on GamingOnLinux.

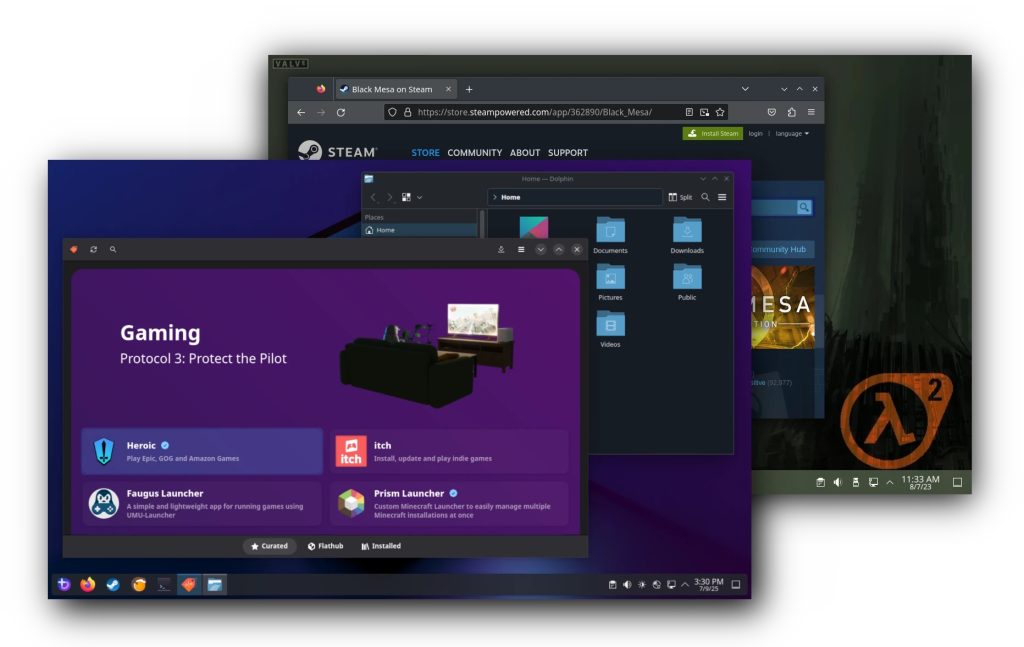

A number of major Linux gaming projects are joining forces to form the Open Gaming Collective. The goal here is to reduce duplicated work across several crucial projects and centralise development efforts for critical components like kernel patches, input frameworks and display compositors.

The OGC's technical strategy (via GamingOnLinux) centres on an “upstream-first approach”. Rather than maintaining permanent forks or bespoke patches, the group intends to submit all improvements and hardware fixes directly to the source projects (such as the mainline Linux kernel or Mesa). Early deliverables include a shared, gaming-optimised OGC Kernel and a specialised fork of gamescope designed to expand hardware support across a wider range of handhelds and desktop GPUs.

Bazzite, one of the founding members, has already outlined immediate changes resulting from joining the collective. The distribution will phase out its custom Handheld Daemon (HHD) in favour of InputPlumber, a unified input remapper already utilised by SteamOS, ChimeraOS, and Nobara. Additionally, Bazzite will integrate features like RGB and fan control directly into the Steam UI where possible, further bridging the gap between custom Linux distros and the native Steam Deck experience.

Besides Bazzite, other companies and partners include Nobara, ChimeraOS, Playtron, Fyra Labs, PikaOS, ShadowBlip, and Asus Linux.

KitGuru says: The formation of the OGC is an important step for the Linux gaming community. Standardising the kernel and input layers could finally bring the “it just works” stability of SteamOS to the broader Linux desktop world.

The post Open Gaming Collective (OGC) formed to unify Linux gaming first appeared on KitGuru.

En ce début d'année 2026, achetez une clé Windows 11 Pro pour 21 U+20AC.Et donc, pourquoi pas un nouvel OS pour cette nouvelle année 2026 ? En plus, vous le savez, Microsoft a officiellement mis fin au support de Windows 10. Il est donc plus que temps de passer à Windows 11. Bonne nouvelle : grâce à notre partenaire GVGMALL, pas besoin de vous ruiner pour obtenir une licence authentique, ni d'endurer le fameux message Windows non activé en bas de l'écran. Pourquoi ? Parce que GVGMALL.com propose des clés OEM authentiques à des tarifs ultra-avantageux : - Windows 11 dès 19 U+20AC - Licences Office dès 27 U+20AC Avec le code promo CCVIP, profitez en plus de -30 % de réduction sur vos achats. Et malin : pour économiser quelques euros supplémentaires, vous pouvez aussi acheter une licence Windows 10 puis faire l'upgrade gratuit vers Windows 11. Offres spéciales avec le code promo CCVIP Voici les meilleurs deals disponibles chez GVGMALL : - Windows 11 Pro OEM Lifetime - 23 U+20AC - Windows 10 Pro OEM Lifetime - 16 U+20AC - Windows 11 Home OEM Lifetime - 19 U+20AC - Windows 10 Home OEM Lifetime - 13 U+20AC - Microsoft Office 2016 Lifetime - 27 U+20AC - Microsoft Office 2019 Lifetime - 52 U+20AC - Windows 10 Enterprise LTSC 2021 - 11 U+20AC - Windows 10 Pro OEM + Office 2016 - 34 U+20AC - Windows 10 Pro OEM + Office 2019 - 52 U+20AC - Windows 11 Home + Office 2021 Pro Plus - 88 U+20AC - Windows 11 Pro OEM + Office 2021 Pro Plus - 87 U+20AC […]

Lire la suite