YouTube renforce la traque aux deepfakes avec un outil de détection pour les créateurs de contenu

YouTube n’est certes pas la plateforme la plus touchée par les deepfakes (même si elle n’est pas non plus immaculée), mais Alphabet rajoute à partir de ce mois-ci une couche de protection supplémentaire pour les aider les créateurs de contenu à protéger leurs identités.

C’est la seconde étape d’un plan commencé en décembre 2024, qui a commencé par un partenariat avec la CAA (Creative Artists Agency, qui regroupe nombre d’acteurs et d’artistes américains, comme Brad Pitt, George Clooney, etc), afin d’aider les artistes à protéger leur images face aux faux-comptes et autres vidéos détournées grâce à l’IA. Grâce à ce partenariat, YouTube a mis en place un outil qui permet aux célébrités de surveiller les vidéos qui pourraient avoir été générées par IA reproduisant leur personne, et peuvent ensuite les signaler à la plateforme qui les mettra hors ligne.

L’identification recoupe non seulement l’image, mais aussi le son : l’idée de cet algorithme de détection a en effet germé suite à un faux clip ayant associé Drake à The Weeknd l’année précédente, alors que les deux artistes n’avaient jamais fait de duo. Bien que la publication originale ait été faite sur un réseau concurrent (TikTok), elle a ensuite essaimé sur les autres plateformes et l’affaire avait fait assez de bruit pour réveiller Alphabet sur les risques potentiels.

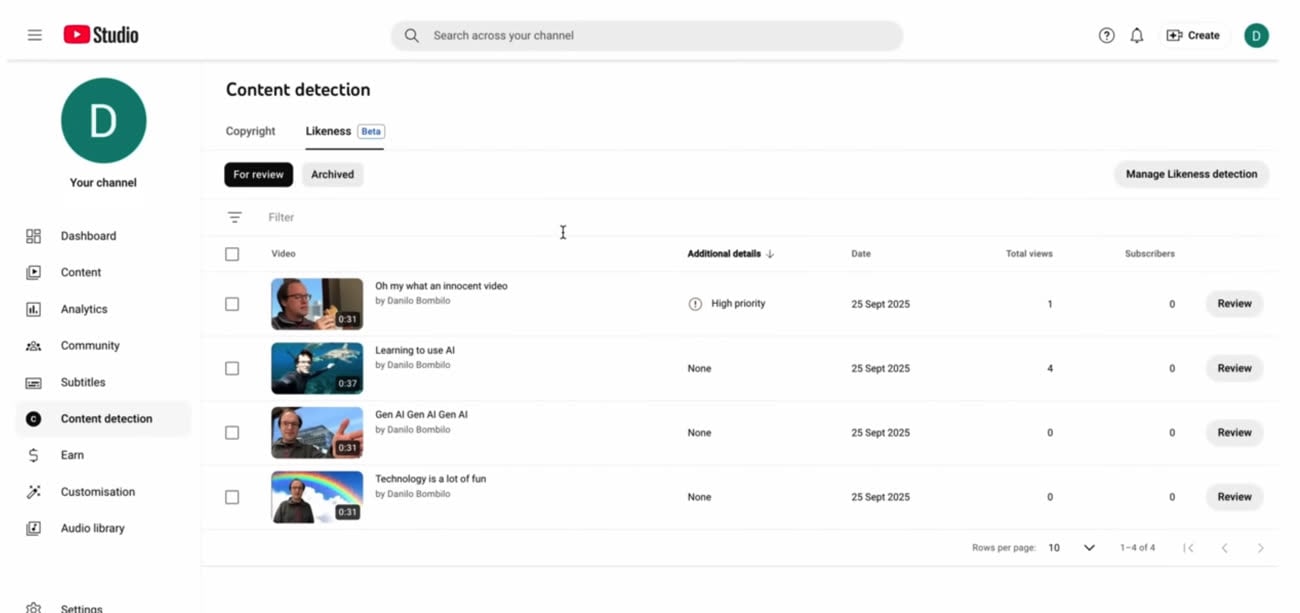

Après un an de tests avec la CAA, YouTube annonce donc l’extension de son programme de détection des deepfakes aux créateurs de contenu de la plateforme. Dans un premier temps 5 000 (sûrement parmi les plus en vue) content creators seront éligibles à la fonction, avant de la généraliser petit à petit à tous, comme l’indique Jack Malon, responsable relations médias de YouTube à TheWrap :

Essentiellement, les utilisateurs sélectionnés sont les créateurs pour lesquels nous pensons que cet outil sera le plus utile. [...] Cette extension nous permettra de continuer à développer notre outil : plus il est utilisé sur des cas pratiques, plus nous pourrons le tester, et plus il sera affûté.

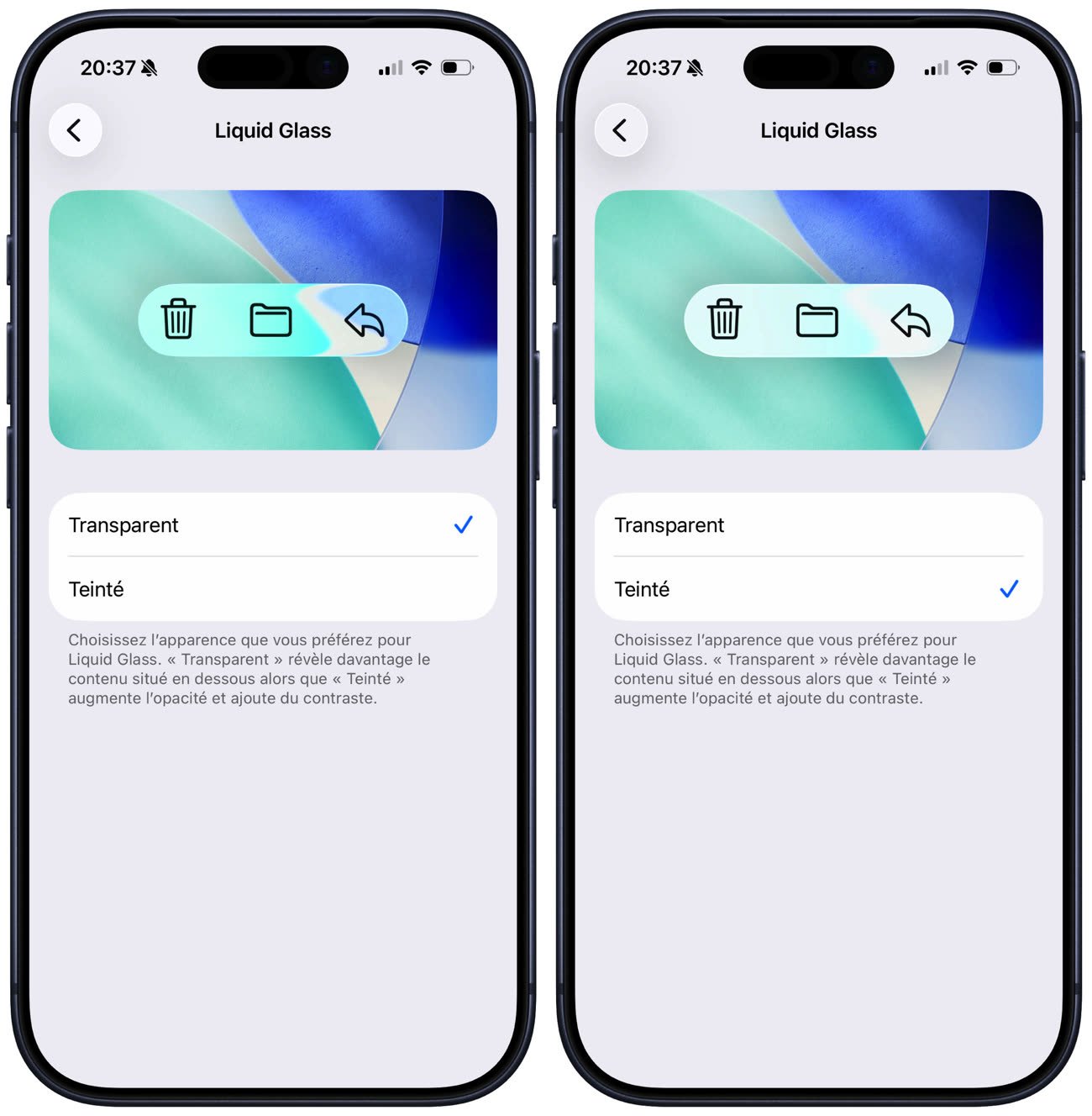

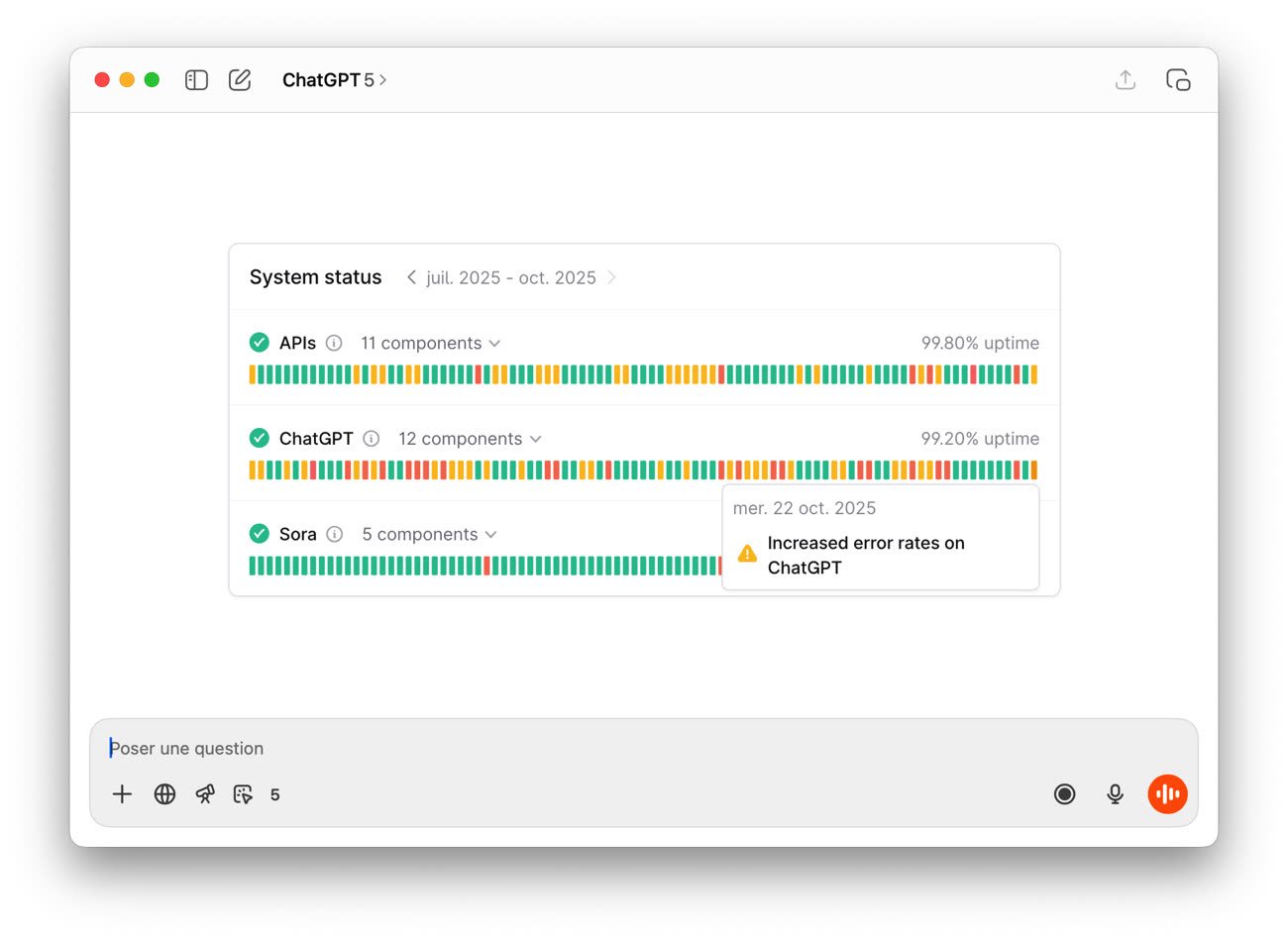

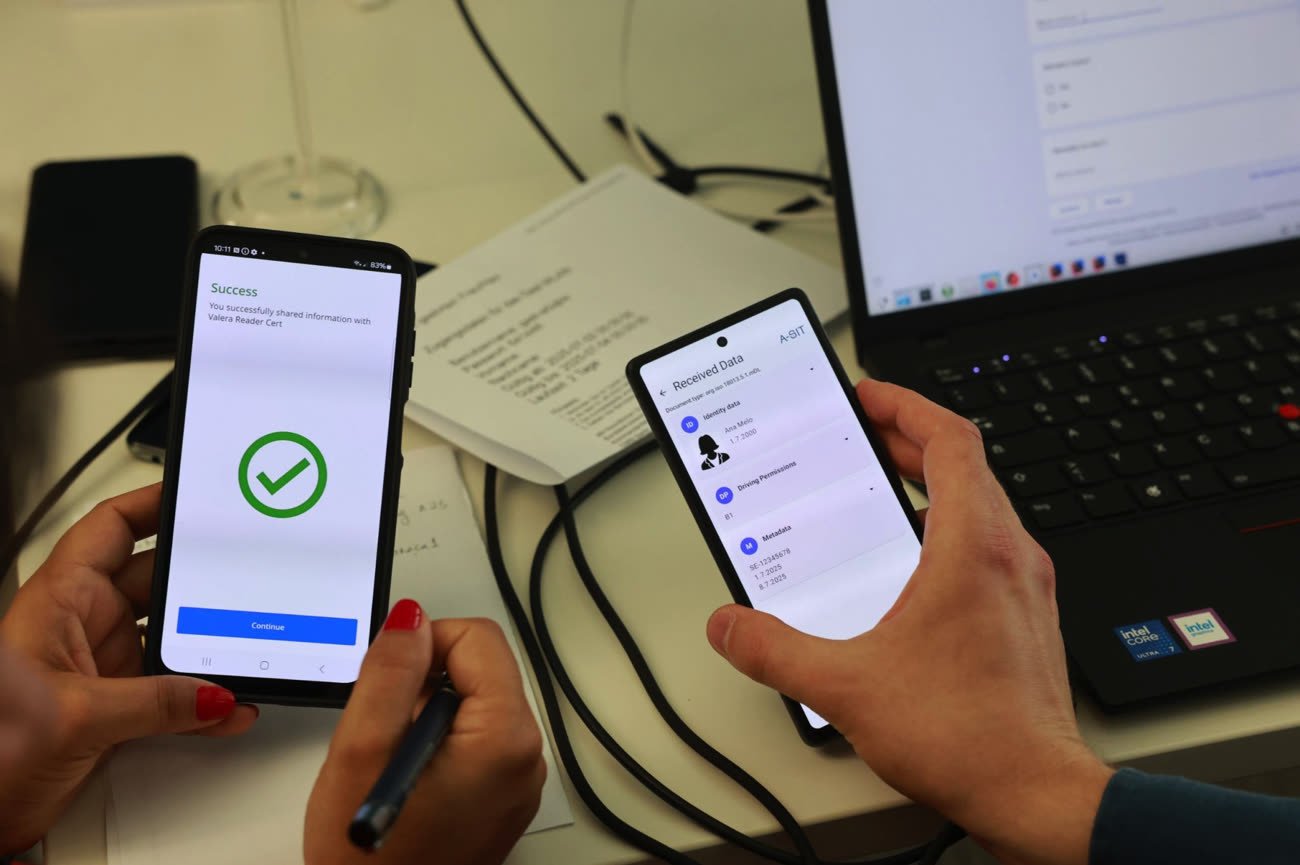

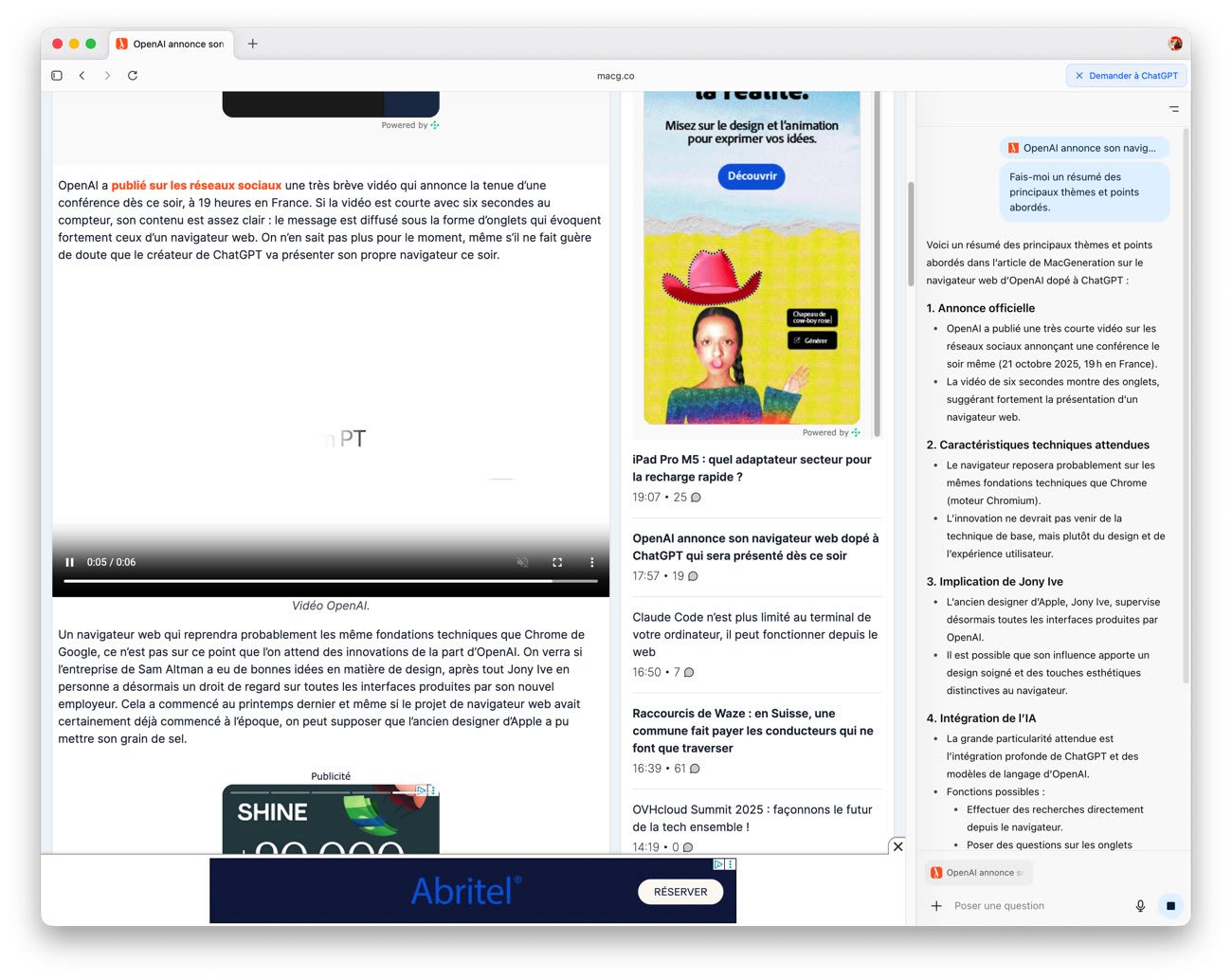

Techniquement, le créateur voulant utiliser l’outil devra utiliser son smartphone pour scanner sa pièce d’identité et faire un selfie vidéo, afin de donner des images de base à l’IA (la vidéo demandée ressemble à celle demandée par l’iPhone pour créer un profil Face ID). Une fois fait, l’interface « Content Detection » dans les réglages de créateur de YouTube affichera un onglet avec les vidéos contenant potentiellement un deepfake de l’utilisateur. À partir de là, le créateur pourra signaler la vidéo détectée, avec les motifs et les détails de la demande de suppression.

Si ce genre d’outil pourrait amener à des abus de signalement, YouTube est clair dans le formulaire d’alerte : toute fausse déclaration et abus de l’outil peut engendrer la fermeture du compte.

D’autres outils, internes à YouTube, sont déjà en place depuis quelques temps pour des personnes plus sensibles encore, comme les hommes et femmes politiques : si ces derniers peuvent faire remonter des vidéos utilisant leur image à l’entreprise, elle est généralement déjà très pro-active en temps normal, et encore plus en période d’élection, même si rien n’est parfait. Gageons que ce nouvel outil de détection automatique les aidera à être encore plus vigilants pour cette catégorie de « créateurs de contenu ».