DeepSeek-R1 arrive sur AWS, Azure et NVIDIA NIM

Business is business. Cet adage se vérifie parfaitement avec les LLM DeepSeek au coeur de l'actualité IA depuis quelques jours. Malgré les critiques et les soupçons d'une infrastructure bien plus performante que celle annoncée, la compatibilité de DeepSeek s'étend. Le LLM R1 comporte 671 milliards de paramètres. Azure annonce son support dans Azure AI Foundry et GitHub.

"DeepSeek R1 est accessible sur une plateforme fiable, évolutive et adaptée aux entreprises, permettant aux entreprises d’intégrer de manière transparente l’IA avancée tout en respectant les SLA, la sécurité et les engagements en matière d’IA responsable, le tout soutenu par la fiabilité et l’innovation de Microsoft." indique Azure. Pour l'utiliser, il faut disposer d'un compte Azure et de sélectionner DeepSeek R1 dans le catalogue de modèles.

Annonce : https://azure.microsoft.com/en-us/blog/deepseek-r1-is-now-available-on-azure-ai-foundry-and-github/

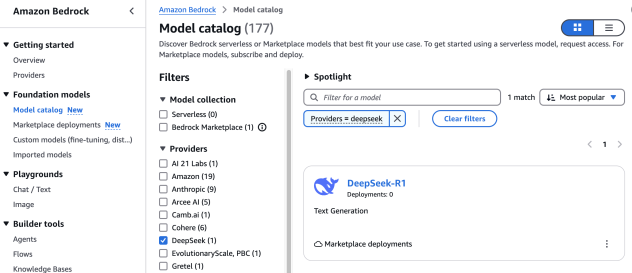

AWS annonce ce jour la disponibilité de DeepSeek-R1 sur la plateforme cloud AWS. Il est possible de l'utiliser dans Bedrock Marketplace, dans Bedrock Custom Model Import, SageMaker JumpStart, EC2 Trn1. Annonce : https://aws.amazon.com/fr/blogs/aws/deepseek-r1-models-now-available-on-aws/

NVIDIA, qui a été malmené par l'annonce de DeepSeek, rend disponible le LLM dans un microservice NVIDIA NIM (préversion). Il est accessible sur build.nvidia.com. Il peut délivrer 3 872 tokens par seconde sur un système HGX H200.