AMD Instinct MI350 : premiers scores MLPerf 5.1 et gros bond en entraînement IA

AMD franchit une nouvelle étape sur le terrain de l’IA avec ses premiers résultats MLPerf 5.1 Training pour la série Instinct MI350, et en profite pour afficher des gains générationnels spectaculaires face aux MI300X et MI325X tout en se mesurant directement aux plates-formes NVIDIA B200 et B300 en FP8.

Jusqu’à 2,8 fois plus rapide que MI300X en entraînement IA

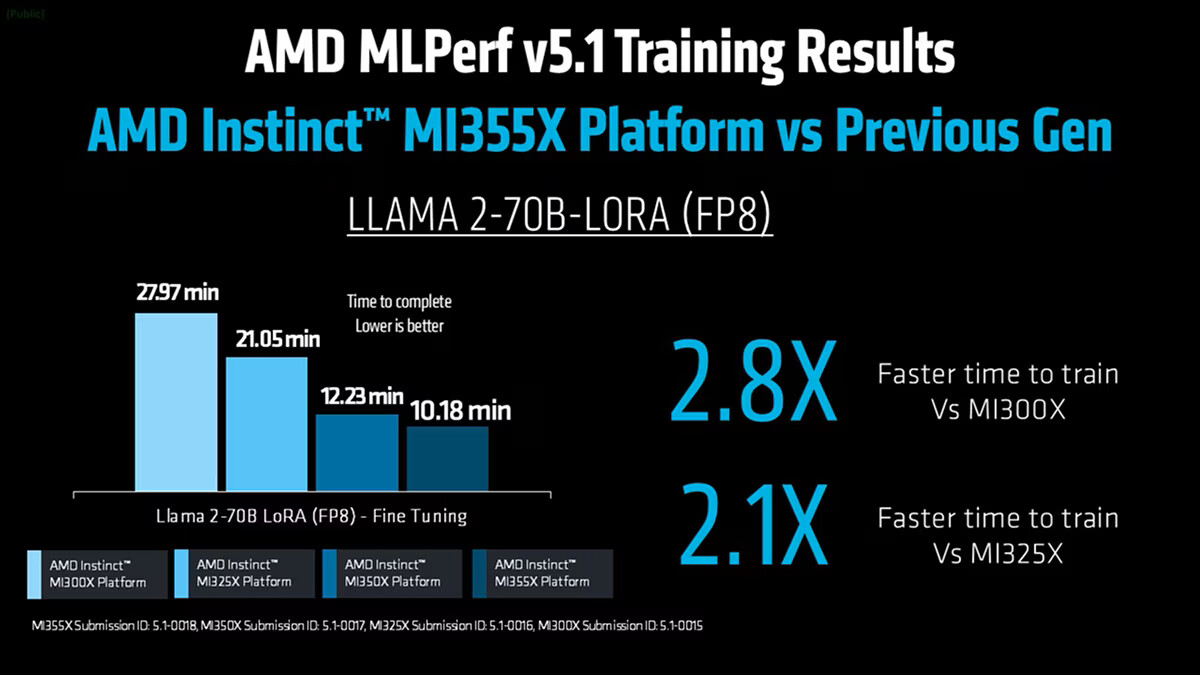

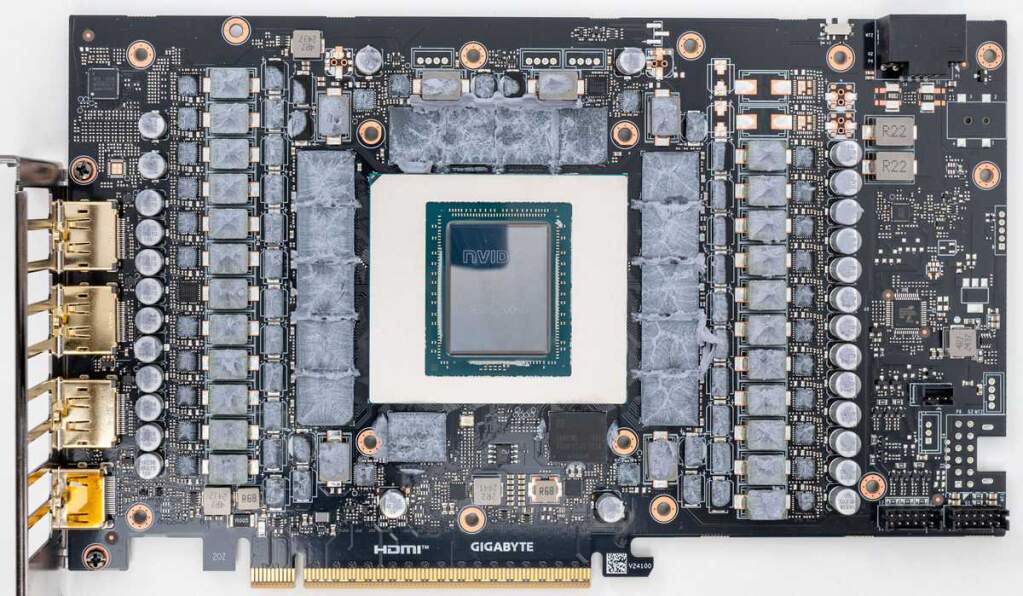

Ces résultats MLPerf 5.1 Training sont la première apparition publique des GPU AMD Instinct MI350 en entraînement IA, et concernent les MI350X ainsi que le MI355X. Selon AMD, la série MI350 offre jusqu’à 2,8 fois moins de temps d’entraînement par rapport aux Instinct MI300X, et encore 2,1 fois plus rapide que la plate-forme Instinct MI325X.

Le cas d’école mis en avant est le benchmark Llama 2-70B LoRA en FP8 dans MLPerf 5.1 Training. Sur cette charge, le GPU Instinct MI355X fait passer le temps d’entraînement d’environ 28 minutes sur MI300X à un peu plus de 10 minutes. Face au MI325X, la durée est quasiment divisée par deux.

D’après AMD, ce bond de performance repose sur plusieurs leviers : évolution de l’architecture CDNA, mémoire HBM3E avec un leadership en bande passante, et optimisations logicielles ROCm 7.1 ciblant les noyaux de calcul et la communication entre GPU. L’ensemble permet une convergence plus rapide des modèles, une meilleure efficacité énergétique et un passage à l’échelle plus propre sur les gros workloads d’IA générative.

Plus largement, la série Instinct MI350 s’inscrit dans un rythme annuel désormais bien installé chez AMD : MI300X en 2023, MI325X en 2024, MI350 en 2025, puis MI450 annoncé pour 2026 avec une nouvelle génération de CDNA. L’objectif affiché est de pousser chaque année la densité de calcul, la bande passante mémoire et la maturité logicielle.

Un MI355X au coude-à-coude avec les systèmes NVIDIA B200/B300 en FP8

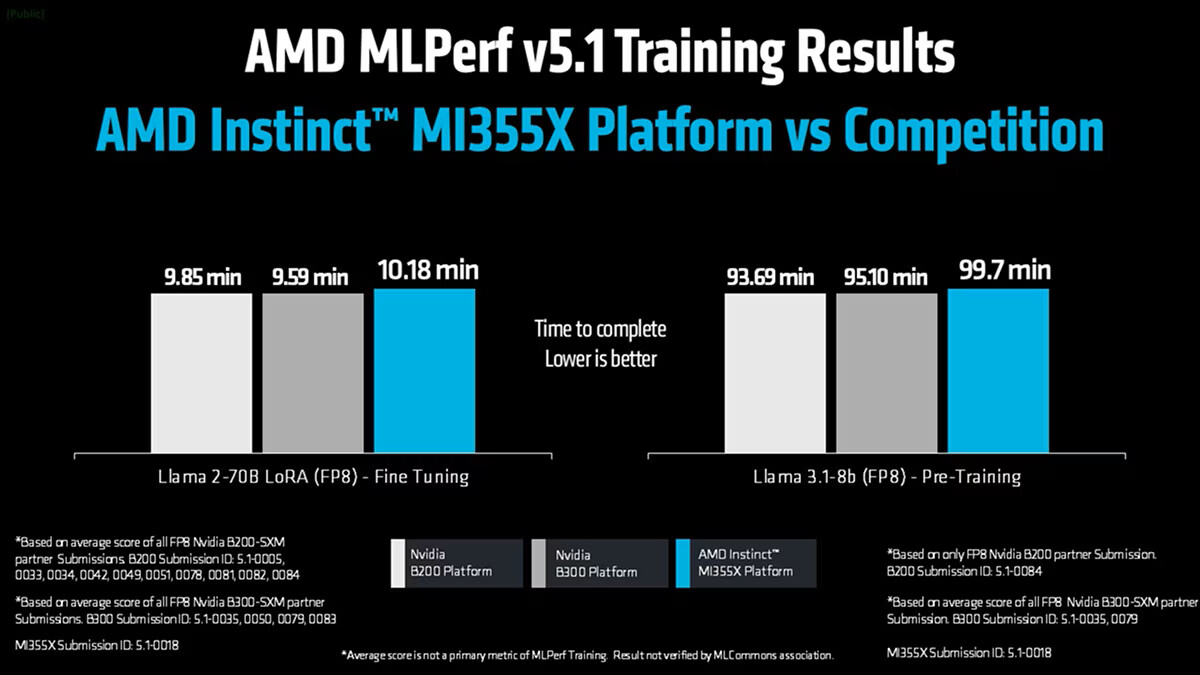

Au-delà de la progression interne, AMD met en avant la compétitivité du MI355X face aux systèmes NVIDIA récents. La comparaison s’appuie sur les soumissions MLPerf 5.1 Training utilisant le format FP8 sur des GPU NVIDIA B200-SXM et B300-SXM, agrégées et moyennées pour donner une vue d’ensemble à l’échelle des plates-formes partenaires.

Sur le benchmark Llama 2-70B LoRA en FP8, le MI355X boucle l’entraînement en 10,18 minutes. La moyenne des soumissions partenaires basées sur B200 et B300 affiche respectivement 9,85 et 9,59 minutes. En pré-entraînement Llama 3.1-8B FP8, le MI355X termine en 99,7 minutes, contre 93,69 et 95,10 minutes en moyenne pour les systèmes NVIDIA pris en compte.

Un point important : dans ce tour MLPerf Training 5.1, NVIDIA n’a soumis que des résultats en FP4, sans run FP8. AMD a choisi de ne pas entrer en FP4, estimant que ce format n’est « pas encore prêt pour la production » en entraînement. Selon l’entreprise, le FP4 impose aujourd’hui des compromis de précision numérique et oblige souvent à revenir en FP8 pour atteindre les objectifs de qualité d’entraînement.

AMD préfère donc concentrer les optimisations sur le FP8, présenté comme le format actuellement le plus adopté pour l’entraînement de modèles à grande échelle avec forte exigence de précision, tout en poursuivant le travail algorithmique pour rendre le FP4 exploitable « dans des scénarios réels dans un avenir proche ».

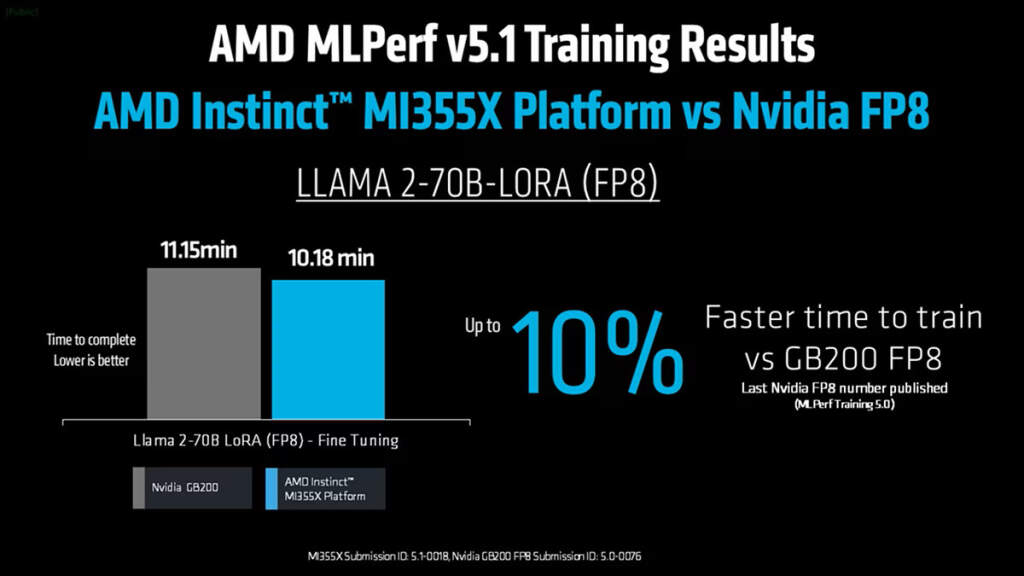

Pour replacer ces chiffres dans le temps, AMD rappelle que le dernier score FP8 public de NVIDIA en entraînement remonte au MLPerf Training 5.0 : 8 GPU GB200 y réalisaient Llama 2-70B LoRA en 11,15 minutes (soumission 5.0-0076). Sur le même benchmark en 5.1, la soumission MI355X (ID 5.1-0018) descend à 10,18 minutes, soit près de 10 % de mieux en FP8 selon AMD.

Neuf partenaires, des résultats alignés à moins de 1 %

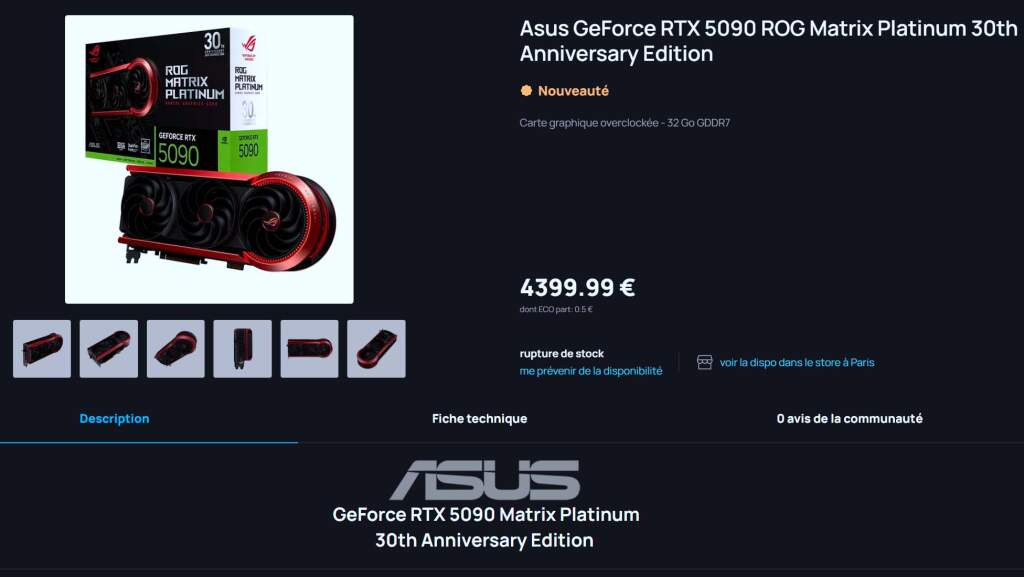

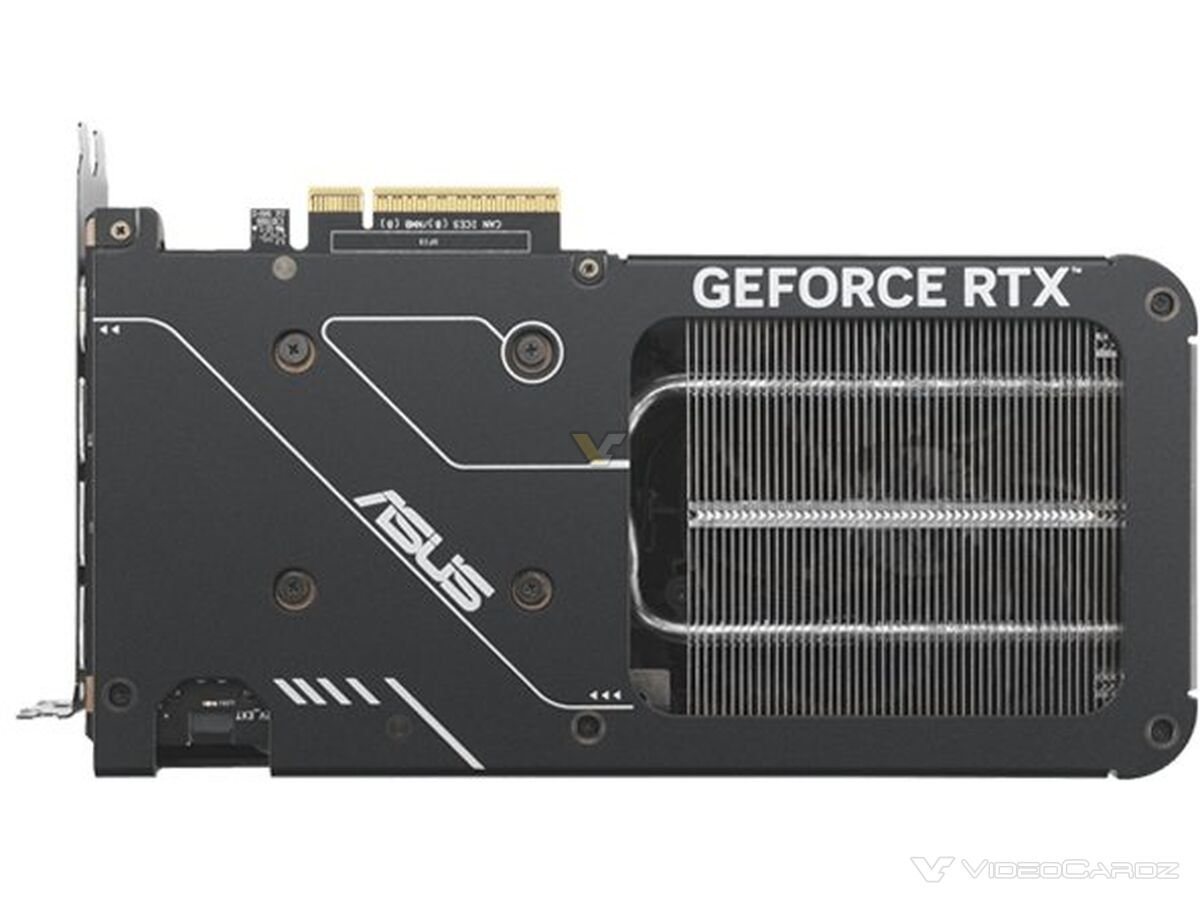

Un autre signal fort de cette campagne MLPerf 5.1 Training est l’ampleur de la participation autour des GPU Instinct. Neuf partenaires majeurs ont soumis des résultats sur du hardware AMD : ASUS, Cisco, Dell, Giga Computing, Krai, MangoBoost, MiTAC, QCT et Supermicro. Les configurations couvraient les MI300X, MI325X, MI350X et MI355X.

Selon AMD, il s’agit du niveau d’engagement le plus élevé à ce jour pour la marque sur MLPerf Training. Particularité intéressante, chaque partenaire soumettait pour la première fois des résultats sur la plate-forme MI355X. Malgré cela, toutes les mesures se situent à moins de 1 % des scores internes d’AMD sur les mêmes benchmarks.

Ce resserrement est présenté comme un indicateur de la maturité de la pile logicielle ROCm et du fait que les systèmes Instinct sont prêts pour un déploiement immédiat chez les OEM et intégrateurs, sans tuning extrême. Les workloads utilisés restent très représentatifs des usages actuels : fine-tuning Llama 2-70B LoRA et pré-entraînement Llama 3.1-8B, notamment dans la soumission multi-nœuds de MangoBoost qui détaille la montée en charge sur de gros jobs IA.

ROCm 7.1, le moteur commun derrière les scores MLPerf

Derrière tous les résultats Instinct de cette vague MLPerf 5.1 se trouve ROCm 7.1, la pile logicielle maison d’AMD. Cette version apporte des évolutions de bout en bout : optimisations de noyaux, mise à jour des compilateurs, amélioration de la communication et intégration plus poussée avec les frameworks IA.

ROCm 7.1 met l’accent sur le FP8 à haute efficacité pour accélérer la convergence des modèles tout en préservant la stabilité numérique. Les optimisations incluent notamment des opérations GEMM affinées, une attention fusionnée plus performante, et des stacks compilateurs actualisées comme XLA et TorchInductor pour un débit plus stable à travers différents workloads.

La gestion de la mémoire et de la communication a également été revue, avec, d’après AMD, une meilleure utilisation de la bande passante et un recouvrement plus efficace entre calcul et échanges de données. De quoi améliorer le scaling du simple GPU jusqu’aux configurations multi-nœuds.

ROCm revendique aussi un support « day-0 » pour plusieurs modèles et frameworks phares, dont Llama 3.1-8B, Mistral ou encore Stable Diffusion XL, afin que les développeurs puissent entraîner et affiner rapidement les workloads IA les plus récents sur Instinct MI355X et consorts.

AMD insiste par ailleurs sur la transparence autour de ces résultats MLPerf. Deux billets techniques détaillent les dessous des optimisations et la marche à suivre pour reproduire les benchmarks sur matériel Instinct, illustrant la volonté de l’entreprise de miser sur des mesures ouvertes et reproductibles.

Verdict

Au final, ce tour MLPerf 5.1 Training positionne la série Instinct MI350 comme une évolution marquante du côté d’AMD : gains générationnels jusqu’à 2,8 fois, performances FP8 au niveau ou au-dessus des derniers scores visibles de la concurrence, et un écosystème de partenaires qui semble monter en puissance rapidement autour du duo Instinct + ROCm.

Source : TechPowerUp

![[MAJ] Intel Nova Lake : AVX10, APX et AMX pourraient bien arriver sur les CPU grand public 81 Visuel promo Intel Nova Lake illustrant AVX10 avec unités 512-bit, confirmant le retour d’AVX-512 sur les prochains processeu](https://pausehardware.com/wp-content/uploads/2025/11/intel-nova-lake-avx10-retour-avx512-core-prochains-edited.jpg)

![[MAJ] Intel Nova Lake : AVX10, APX et AMX pourraient bien arriver sur les CPU grand public 82 intel core ultra 9 485k es nova lake](https://pausehardware.com/wp-content/uploads/2025/09/intel-core-ultra-9-485k-es-nova-lake-1024x617.jpg)

![[MAJ] Intel Nova Lake : AVX10, APX et AMX pourraient bien arriver sur les CPU grand public 83 nova lake avx](https://pausehardware.com/wp-content/uploads/2025/11/nova-lake-avx-1024x671.png)

![[MAJ] Intel Nova Lake : AVX10, APX et AMX pourraient bien arriver sur les CPU grand public 84 Intel Nova Lake CPU: prise en charge AVX10, APX, AMX pour processeurs grand public, performances IA et vectorielles](https://pausehardware.com/wp-content/uploads/2025/11/intel-nova-lake-avx10-apx-et-amx-sur-pc-grand-public-2.jpg)

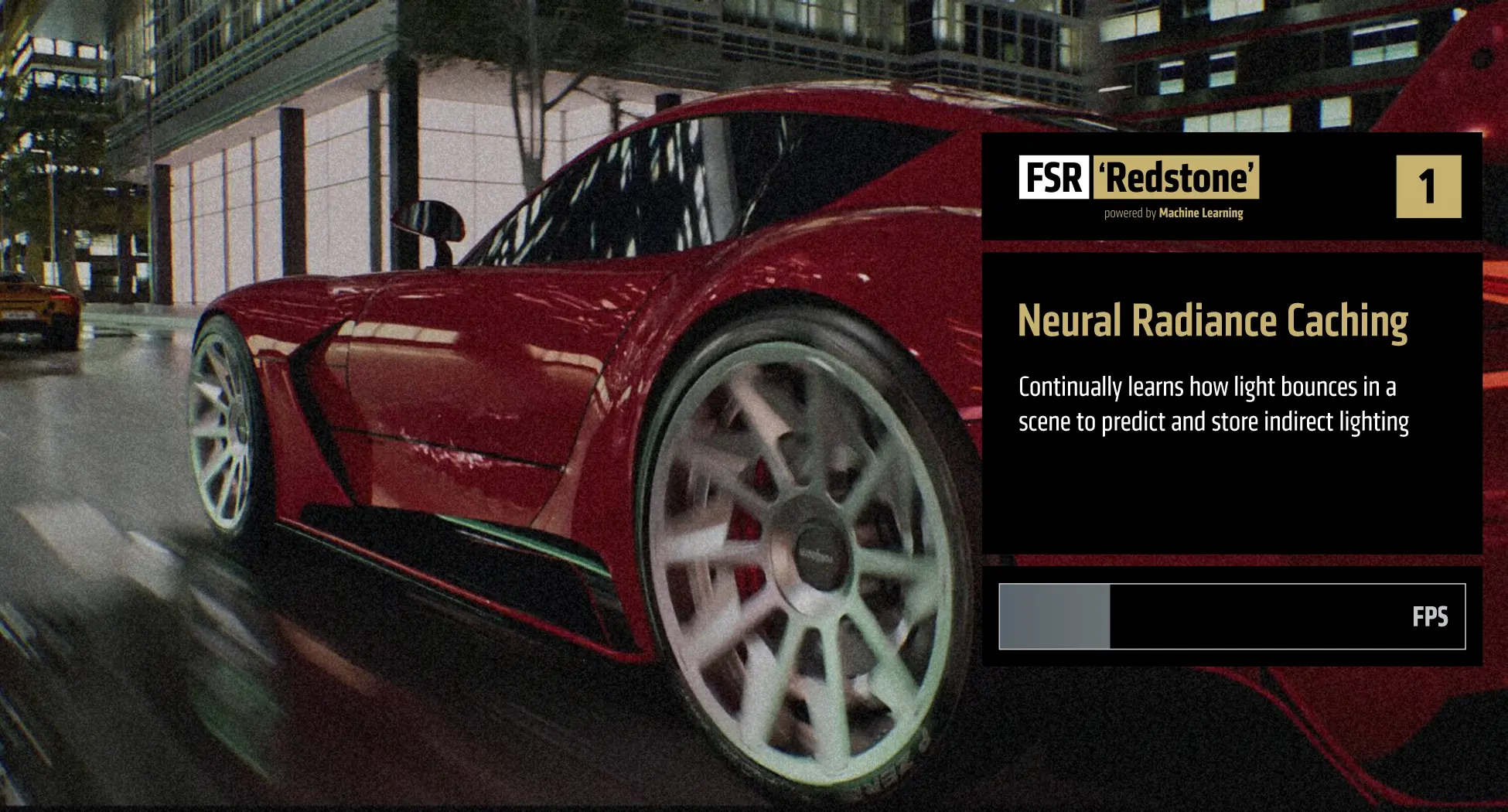

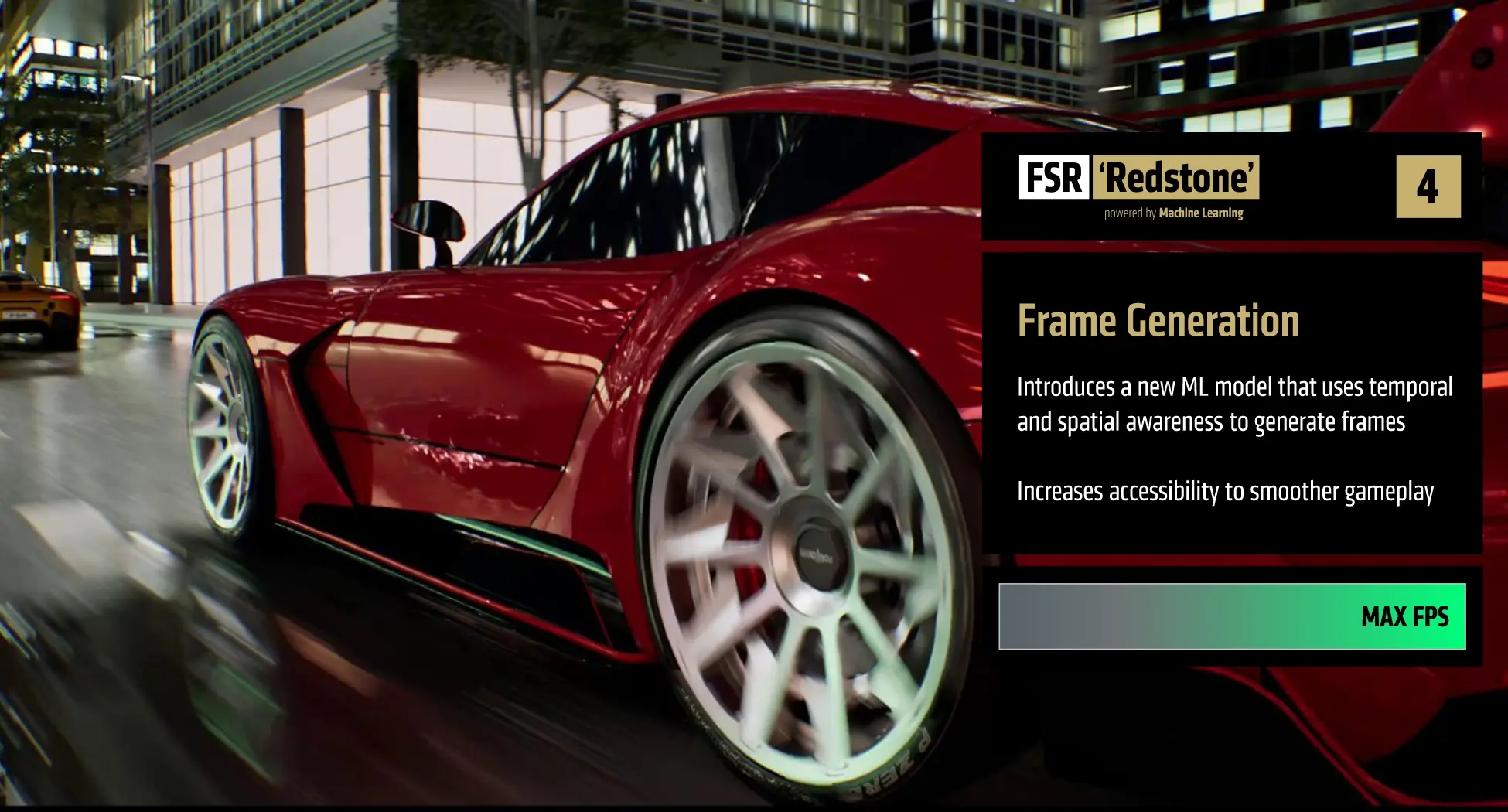

RX 9000 Series graphics cards, FSR ‘Redstone’ Ray Regeneration goes live tomorrow in Call of Duty: Black Ops 7.

RX 9000 Series graphics cards, FSR ‘Redstone’ Ray Regeneration goes live tomorrow in Call of Duty: Black Ops 7.