Pokémon sert de banc d’essai aux IA de Google, OpenAI et Anthropic

Pour éprouver leurs IA les plus avancées, Google, OpenAI et Anthropic les confrontent désormais à un test inattendu : jouer à Pokémon sur Game Boy. Un terrain où la planification long terme, la gestion du risque et la mémoire comptent bien plus que la simple puissance de calcul.

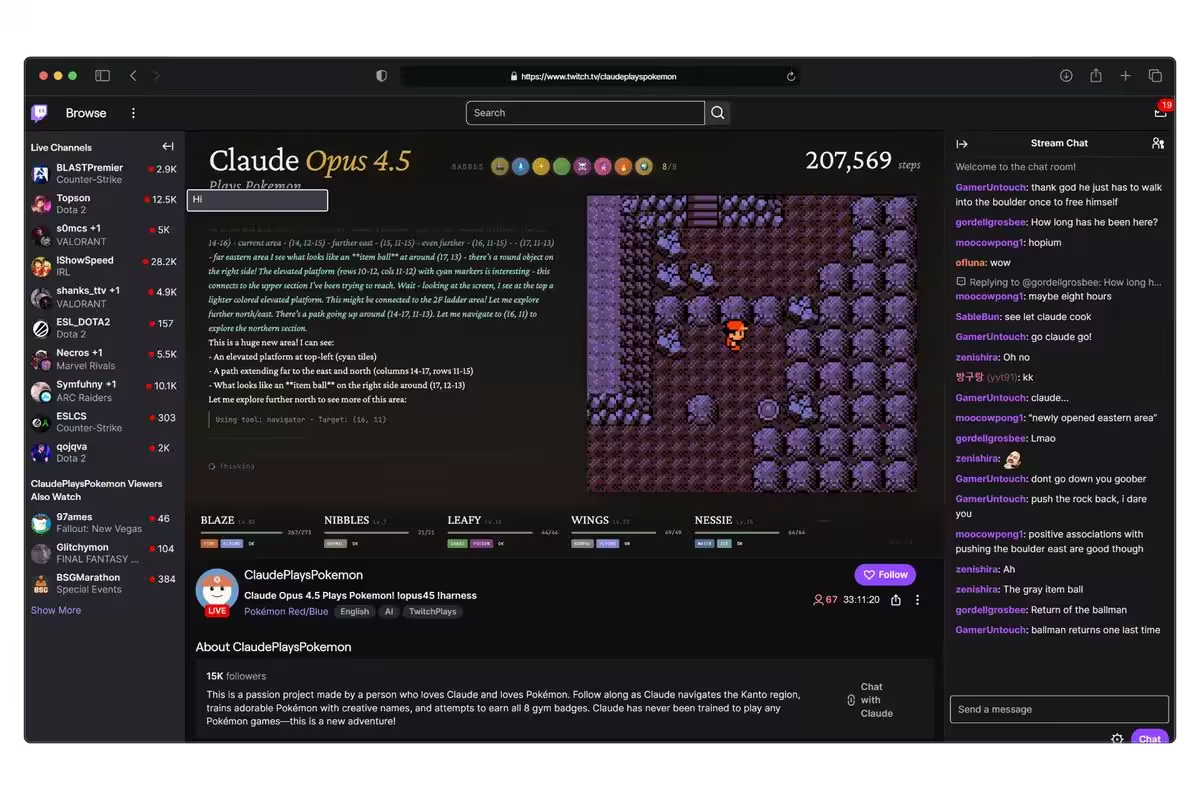

L’idée, remontée par Tom’s Hardware, a quitté le cercle des démos communautaires pour devenir un terrain d’évaluation suivi par les équipes produits. David Hershey, responsable AI chez Anthropic, diffuse depuis l’an dernier des sessions où Claude tente d’avancer dans la série, avec un objectif assumé : observer en temps réel les limites de planification, de prise de risque et de généralisation du modèle.

Le format séduit parce qu’il échappe aux cadres trop restreints de titres comme « Pong ». Dans Pokémon, la progression n’est pas linéaire : leveling, composition d’équipe, choix d’itinéraires, arbitrages entre farm sécurisé et combats risqués pour récupérer des créatures rares. C’est un mélange de raisonnement symbolique, de gestion de ressources et d’horizon long, difficile à publier sous forme de benchmark classique mais facile à juger à l’œil pour ce qui relève du comportement stratégique.

Des streams artisanaux aux validations maison

Les streams communautaires « Gemini joue à Pokémon » et « GPT joue à Pokémon » ont été suffisamment visibles pour attirer des ingénieurs de Google et d’OpenAI, qui sont venus ajuster les paramètres en direct. Résultat : Gemini et GPT ont déjà terminé « Pokémon Bleu » sur Game Boy et s’attaquent aux suites. Claude, lui, n’a pas encore signé de run complet. Selon Hershey, partager ces résultats avec des clients sert aussi à affiner les cadres de contrôle et d’orchestration, pour consommer moins de calcul à qualité égale.

Au-delà du spectacle, ce terrain permet de standardiser quelques métriques utiles : nombre de resets nécessaires, taux de réussite par segment critique (arènes, rival, ligue), stabilité des décisions sous budget de tokens contraint, et sensibilité aux variations de prompts ou de règles maison. Autant d’indicateurs qui complètent les scores de raisonnement ou d’agentic computing publiés ailleurs.

Si cette approche ne remplace ni les benchmarks synthétiques ni les tâches industrielles, elle force les modèles à composer avec l’imprévu et la dette informationnelle d’un monde partiellement observable. C’est précisément le type de pression qui fait émerger les défauts de mémoire de travail, les boucles d’actions inefficaces et les biais de court terme, et qui intéresse les équipes produit autant que les intégrateurs.

Source : ITHome