Apps gratuites, baisses de prix et promos du moment sur iPhone et iPad

Tianma a dévoilé le 8 janvier un écran gaming 27 pouces basé sur une dalle Oxide TFT-LCD en QHD (2560×1440) capable d’atteindre 610 Hz. Cette fréquence inédite en QHD vise les joueurs compétitifs en quête d’une fluidité extrême, sans sacrifier la définition.

Pour lever le plafond de verre des LCD classiques, Tianma exploite pleinement l’oxydesemiconductor (Oxide TFT) et combine trois optimisations clés : adoption d’un liquide cristallin « positif », affinage du procédé de couche d’alignement et ajustements structurels du TFT. Le gain de mobilité électronique ainsi obtenu permet de soutenir un débit de trames de 610 Hz tout en conservant la résolution QHD.

La dalle annonce un temps de réponse de 1 ms GTG, pour limiter le flou cinétique et les traînées en mouvement rapide. Elle intègre un traitement anti-reflet et anti-éblouissement, une luminance de 350 nits et un contraste de 1200:1 pour un confort visuel cohérent en usage compétitif.

Côté couleur, la couverture 100% DCI-P3 vise une restitution fidèle et saturée, utile autant pour les scènes de jeu très contrastées que pour les contenus créatifs exigeants. L’ensemble positionne cette dalle comme une vitrine technologique de l’Oxide TFT en gaming haute fréquence.

Reste à connaître les premiers moniteurs commerciaux qui adopteront ce panneau, ainsi que les détails de connectique, d’overdrive et de prise en charge VRR. Nous suivrons les annonces des partenaires pour confirmer la disponibilité et les tarifs.

Source : ITHome

CES 2026 no-shows : une poignée d’annonces pressenties n’ont jamais eu lieu, malgré des fuites insistantes et des keynotes chargées.

1) NVIDIA GeForce RTX 50 « Blackwell » en déclinaison SUPER. Attendu d’après les indiscrétions pour une fenêtre fin T1 à début T2 2026 avec une possible annonce au CES, ce refresh devait miser sur des modules GDDR7 plus denses de 3 Go par puce.

Objectif affiché : gonfler la mémoire des GeForce RTX 5070, RTX 5070 Ti et RTX 5080. Les rumeurs évoquaient une RTX 5070 SUPER à 18 Go, et des RTX 5070 Ti SUPER et RTX 5080 SUPER à 24 Go de GDDR7. Rien n’a été officialisé sur le salon.

2) NVIDIA N1X, le SoC Arm pour PC portables gaming. Ce processeur aurait dû croiser le fer avec le Snapdragon X2 Plus dévoilé sur place. D’après les informations disponibles, NVIDIA s’appuierait sur le GB10 Superchip comme base N1/N1X, dérivé du duo Grace Blackwell.

Le CPU regrouperait 20 cœurs Arm v9.2 en deux clusters de 10, chacun avec 16 Mo de L3 partagé (32 Mo au total) et un L2 privé par cœur. La mémoire passerait par un bus unifié LPDDR5X-9400 sur 256 bits, jusqu’à 128 Go pour environ 301 Go/s de bande passante brute, avec un TDP autour de 140 W et du PCIe 5.0 pour le stockage NVMe. Reste l’inconnue d’une telle capacité mémoire en machines grand public. Aucune annonce au CES.

3) AMD Ryzen 9 9950X3D2. Lisa Su a signé un keynote dense, sans mot sur ce CPU pressenti. Selon plusieurs rapports, il s’agirait d’un 16 cœurs, 32 threads, avec 3D V-Cache sur les deux chiplets, soit environ 192 Mo de L3. Fréquence de base estimée à 4,30 GHz, boost à 5,6 GHz.

Par rapport au prédécesseur, un déficit d’environ 100 MHz en pic pour davantage de cache et un ordonnancement plus flexible. Cible : charges sensibles au cache, jeux, et usages créatifs gourmands en mémoire. Le revers thermique serait marqué avec un TDP supposé à 200 W, le PPT pouvant frôler 250 W. À la place, AMD a officialisé un Ryzen 7 9850X3D, proche du 9800X3D, mais avec un boost relevé de 400 MHz à 5,6 GHz.

4) Intel Core Ultra « Arrow Lake Refresh ». Les listes de boutiques laissaient filtrer des références comme Core Ultra 9 290K Plus, Ultra 7 270K Plus et Ultra 5 250K Plus, avec environ +100 MHz en base et en boost sur P-cores et E-cores, et un contrôleur mémoire annoncé à 7 200 MT/s (contre 6 400 MT/s sur Arrow Lake). L’idée : lisser les aspérités du lancement initial et grappiller quelques FPS sur LGA-1851.

Les projecteurs étaient finalement braqués sur « Panther Lake ». « Nova Lake » arrivant dans quelques mois, il semblerait que ce refresh puisse ne jamais voir le jour.

5) Intel Arc « Battlemage » B770. Attendue avec un die BMG-G31, 32 cœurs Xe2, 16 Go de GDDR6 sur 256 bits, la carte multiplie les apparitions dans les bibliothèques logicielles, signe d’un lancement proche. Zéro mention toutefois dans le keynote, Intel privilégiant « Panther Lake ».

Le TDP pressenti de 300 W marquerait un record pour Arc côté grand public, au-dessus des 190 à 225 W des A770 et de plusieurs Battlemage B-series. Ce surplus énergétique devra se traduire en gains tangibles, ce que l’on n’a pas pu vérifier à Las Vegas.

Source : TechPowerUp

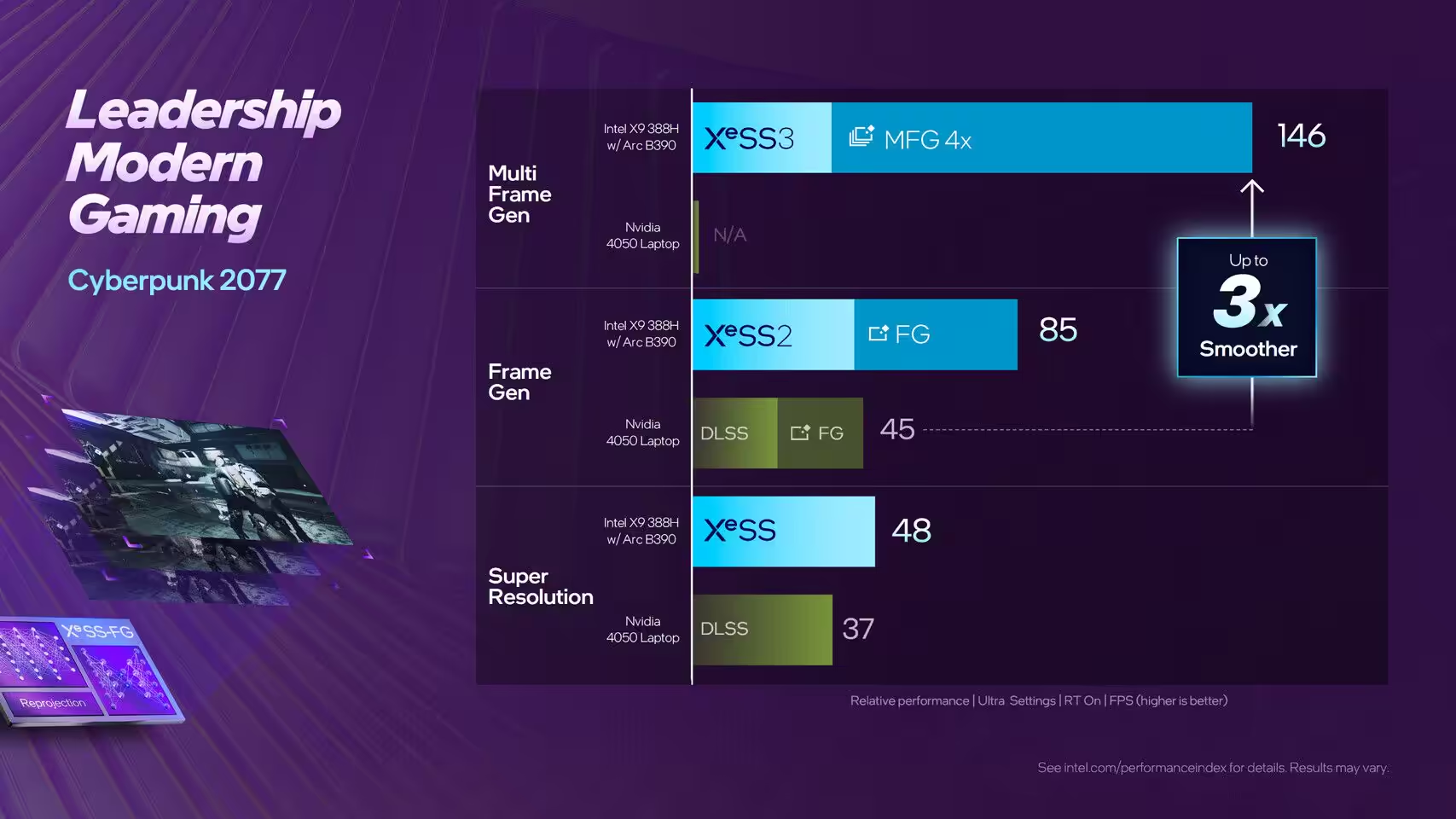

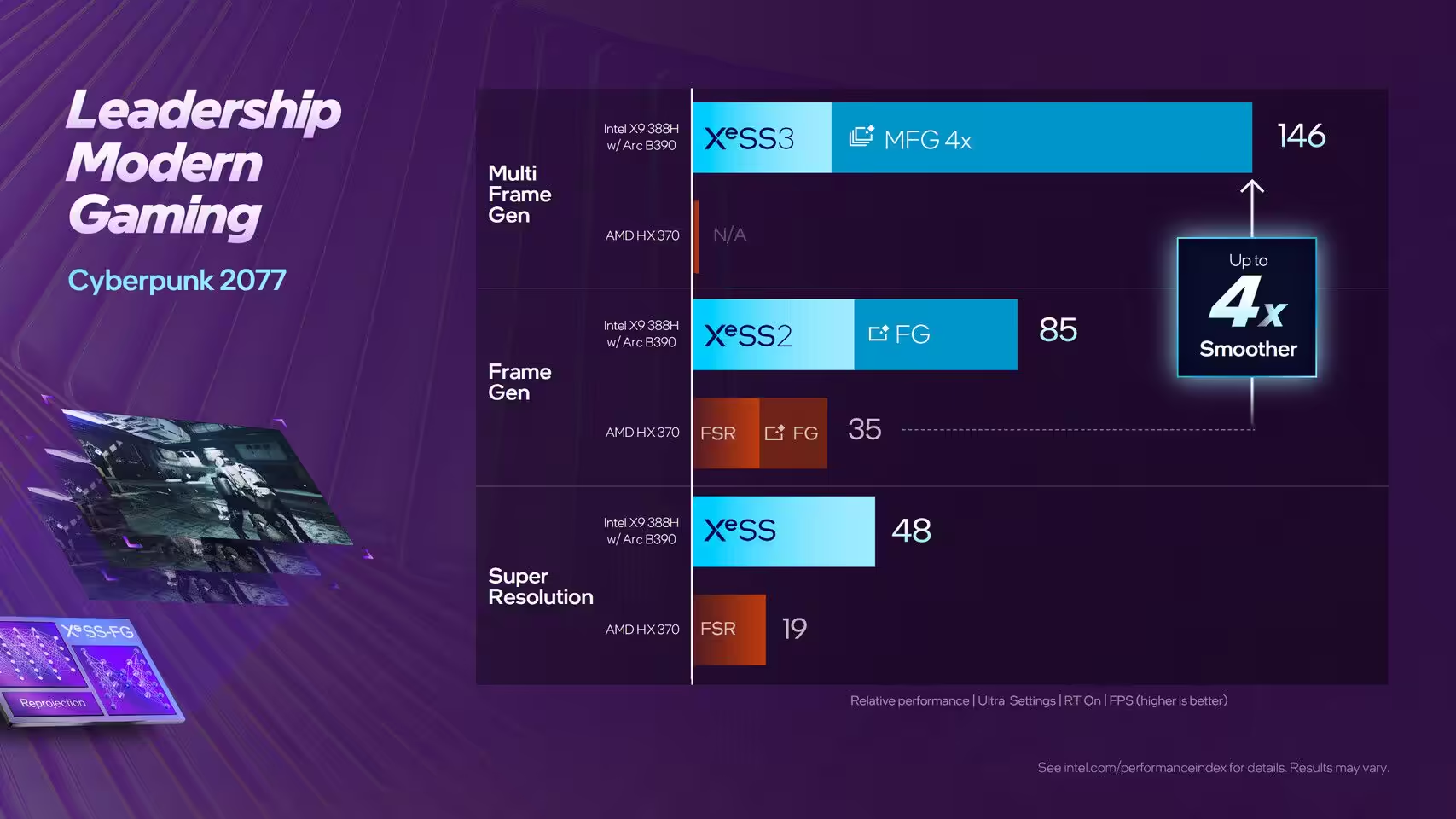

Intel Panther Lake prend l’avantage. À 1080p Ultra avec ombres et reflets ray tracing activés dans Cyberpunk 2077, le Core Ultra X9 388H pointe à 28 FPS, soit deux fois le score du Ryzen AI 9 HX 370 « Strix Point » et sa Radeon 890M à 14 FPS.

Dévoilés au CES 2026 et gravés en 18A, les puces Panther Lake embarquent l’iGPU Arc B390. D’après Digital Foundry, le X9 388H affiche 28 FPS dans Cyberpunk 2077 aux réglages Ultra en 1080p avec RT ombres et reflets, quand « Strix Point » plafonne à 14 FPS. Intel parle par ailleurs d’une avance moyenne de 73 % avec upscaling et 82 % en natif face au Radeon 890M, avec des cas où l’Arc B390 délivrerait 100 % d’images en plus.

Selon les mesures communiquées, la performance se rapproche d’une carte desktop Radeon RX 6600 qui atteint 27 FPS dans les mêmes conditions de test. Intel dit travailler avec les studios pour intégrer XeSS3, sa technologie de mise à l’échelle et génération multi-images, dès la sortie de nombreux jeux. Cyberpunk 2077 est pris en charge dès le premier jour, avec un gain « d’environ 3x » par rapport à XeSS2.

Intel affirme dépasser le DLSS sur un RTX 4050, notamment parce que XeSS3 gère la génération multi-images, ce que le RTX 4050 ne propose pas. À prendre avec prudence en attendant des tests indépendants à grande échelle, mais le signal est clair : Intel vise désormais le haut du panier en iGPU.

Source : TechPowerUp

Vu puis retiré en catimini : le Zephyrus G14 Arc B390 a brièvement existé au CES 2026, suffisamment pour semer le doute chez les visiteurs et, visiblement, chez Intel lui-même.

ASUS avait préparé un ROG Zephyrus G14 GU405AA animé par un Core Ultra 3 « Panther Lake » et une iGPU Arc B390, sans GPU dédié. Ce point tranchait avec l’ADN de la gamme G-Series. Le modèle avait déjà fuité en octobre via Geekbench, confirmant l’absence de GPU discret.

Selon Les Numériques, l’ordinateur n’était pas un prototype. La marque l’a montré en privé début décembre à des médias, laissant penser à un lancement proche. Pourtant, à l’ouverture du CES 2026, le Zephyrus G14 avait disparu du stand ASUS.

La même machine aurait été repérée dans l’espace démo d’Intel, à huis clos, utilisée pour mettre en avant l’iGPU Arc B390 basé sur Xe3. Avant que les questions ne fusent, l’unité aurait été retirée. D’après la source, ASUS a ensuite confirmé un « changement de stratégie », actant l’annulation du produit. Des représentants d’Intel auraient été pris de court, incapables d’expliquer sa présence dans leur showcase.

Le Zephyrus G14 vise un segment premium où l’on retrouve habituellement au minimum une GeForce RTX 4050 90 W. Or, l’Arc B390, malgré des progrès notables, atteindrait seulement le niveau d’une RTX 4050 60 W, insuffisant pour un PC portable clairement orienté gaming.

Les Numériques avance que ce concept pourrait réapparaître sous la bannière TUF Gaming A14, plus abordable, où une iGPU performante aurait davantage de sens. Pour l’heure, le G14 motorisé par Arc reste le « laptop fantôme » du CES 2026.

Source : VideoCardz

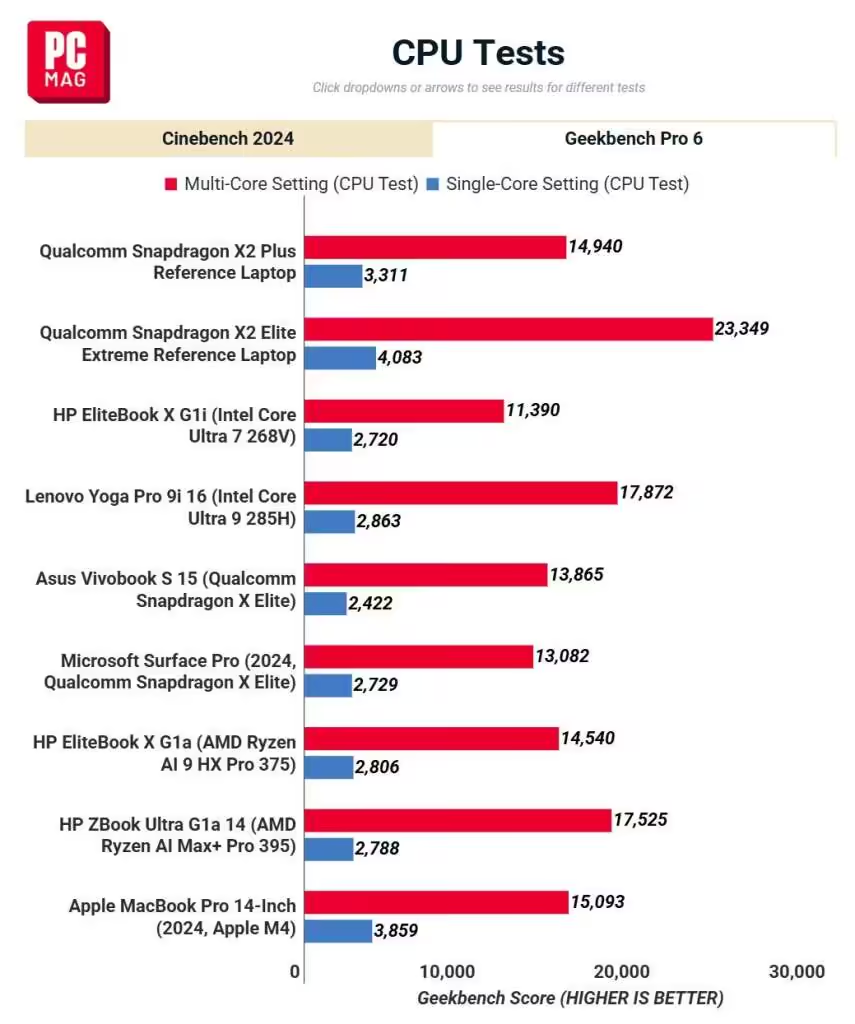

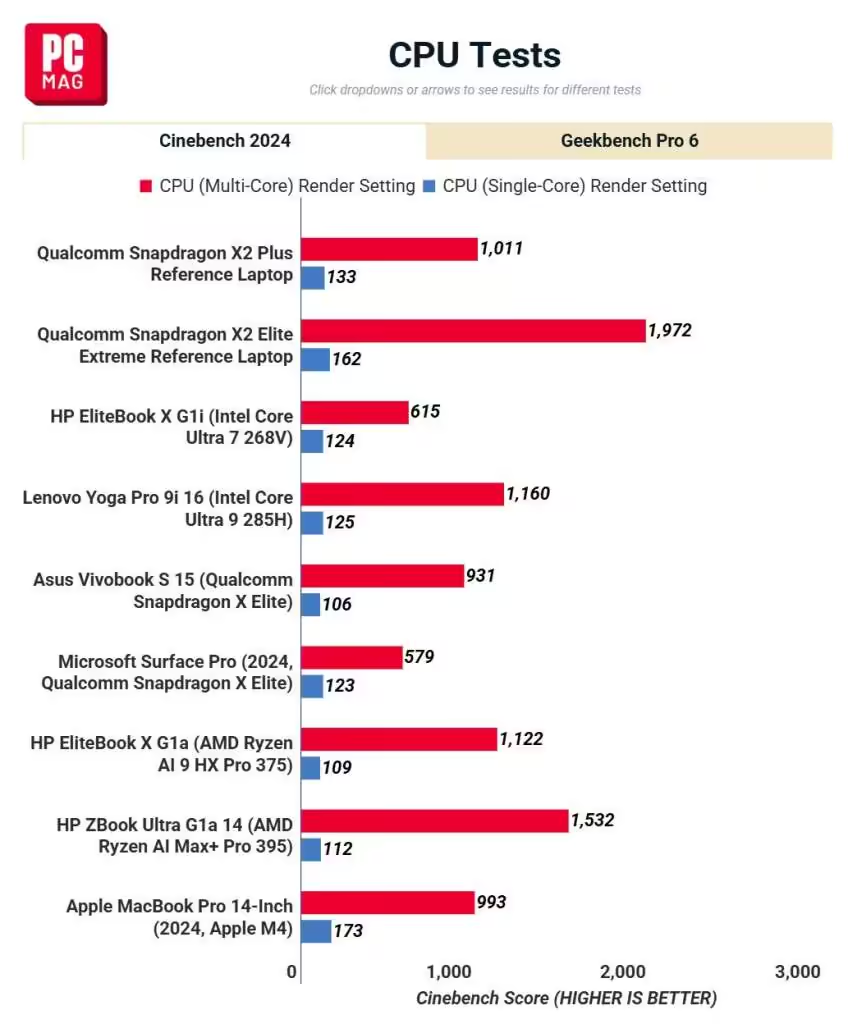

Qualcomm vient de présenter au CES 2026 son Snapdragon X2 Plus, équipé d’un CPU Oryon de troisième génération. Le fondeur annonce jusqu’à 35% de mieux en mono-cœur et environ 43% de baisse de consommation face à la génération précédente. Des premiers scores Cinebench 2024 permettent de situer ce Snapdragon X2 Plus face à l’Apple M4, avec des résultats contrastés selon les charges.

Les tests portent sur une plateforme de référence en dix cœurs (les versions commerciales sont attendues en 10 cœurs et 6 cœurs). En charge mono-cœur, l’Apple M4 garde l’avantage: 173 points contre 133, soit environ +30% pour le M4. En multi-cœur, les écarts varient selon les scènes: on relève par exemple 3311 pour le X2 Plus contre 3859 pour le M4 (M4 +16,6%), ou encore 3067 contre 3949 (M4 +28,8%).

Le Snapdragon X2 Plus parvient toutefois à devancer légèrement l’Apple M4 sur certaines passes: 1011 contre 993 (environ +1,8% pour le X2 Plus) et 14940 contre 15093 (M4 +1,0%, écart marginal). Globalement, le nouveau SoC de Qualcomm progresse nettement face au Snapdragon X Plus, sans détrôner l’Apple M4 sur la majorité des mesures Cinebench 2024.

Ces scores donnent un premier aperçu des performances du Snapdragon X2 Plus, mais restent liés à une machine de référence et à un seul outil de bench. Il faudra juger sur des appareils commerciaux et des charges applicatives variées pour confirmer ces tendances.

Source : ITHome

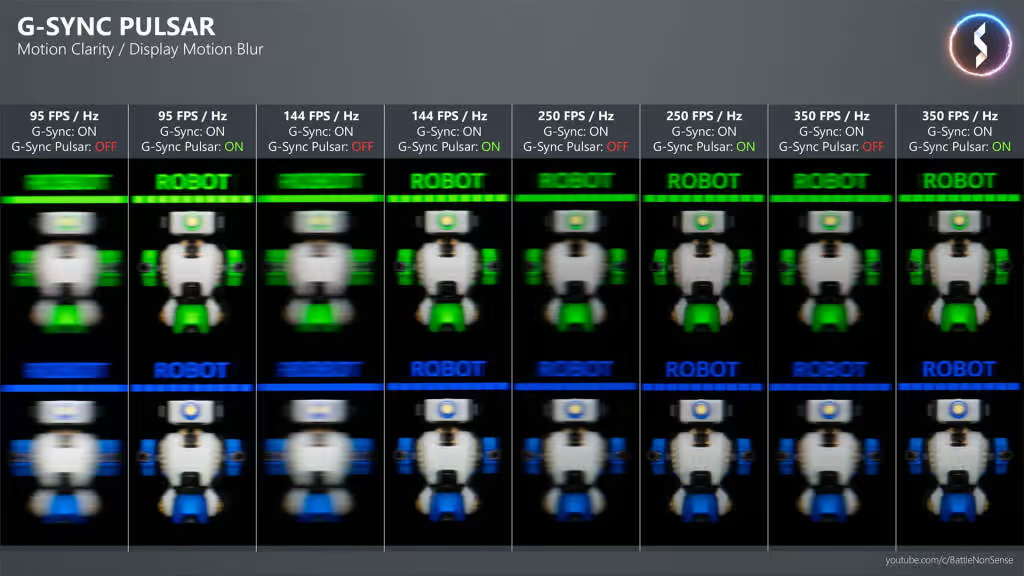

Après avoir décortiqué le fonctionnement technique de G-SYNC Pulsar et expliqué pourquoi cette technologie change la donne sur la netteté en mouvement, il est temps de passer à la pratique.

Expreview a publié un test approfondi du ROG Strix XG27AQNGV, l’un des premiers écrans G-SYNC Pulsar disponibles. Leur protocole repose sur une configuration très haut de gamme, associant une GeForce RTX 5090 et un Ryzen 7 9800X3D, ainsi que sur des captures vidéo en 4K à 120 images par seconde afin d’évaluer la clarté en mouvement en conditions réelles.

Reconnu pour la rigueur de ses analyses matérielles, Expreview va au-delà du discours marketing. Mesures, séquences filmées en suivi de mouvement et observations factuelles viennent confirmer, nuancer et préciser les apports concrets de Pulsar en jeu. Ce regard extérieur complète notre article pilier en confrontant la promesse technologique aux contraintes physiques et aux usages réels, là où la netteté ne se proclame pas, mais se mesure et se perçoit.

Afin d’évaluer G-SYNC Pulsar dans des conditions représentatives d’un usage réel, nous avons volontairement isolé cette partie sous la forme d’un article dédié. L’objectif n’est pas de produire un benchmark chiffré classique, mais d’observer, décrire et comparer la perception du mouvement dans différents scénarios de jeu, avec un matériel capable d’exploiter pleinement la technologie.

Cette configuration permet de maintenir des fréquences d’images élevées et stables, condition indispensable pour exploiter correctement G-SYNC Pulsar et éviter toute confusion entre limites GPU et comportement de l’affichage.

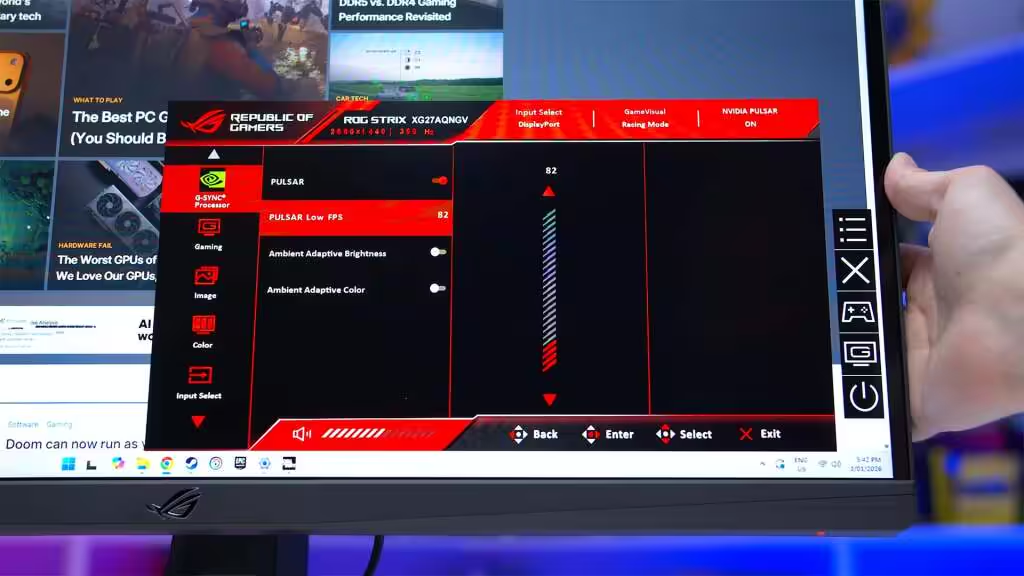

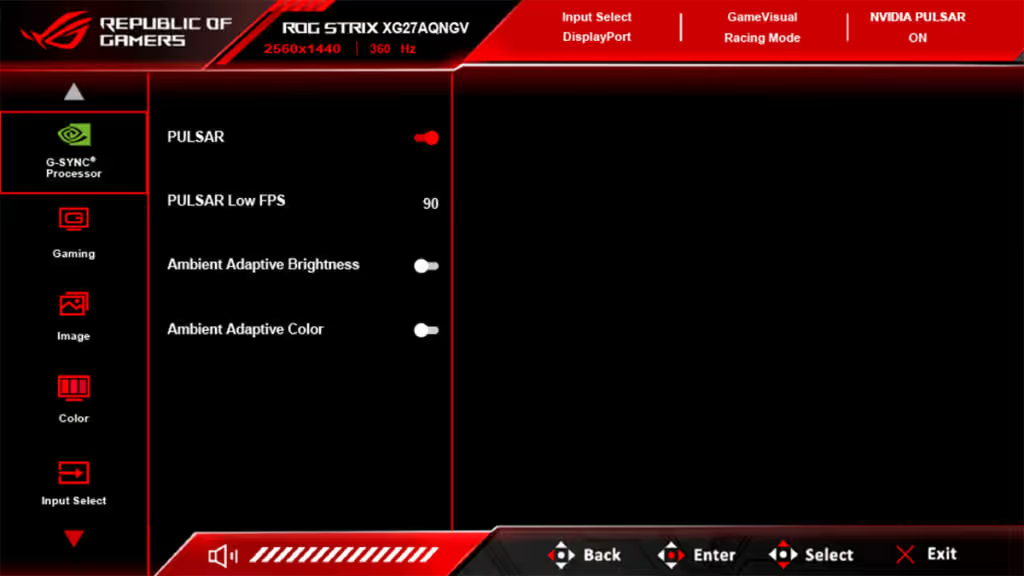

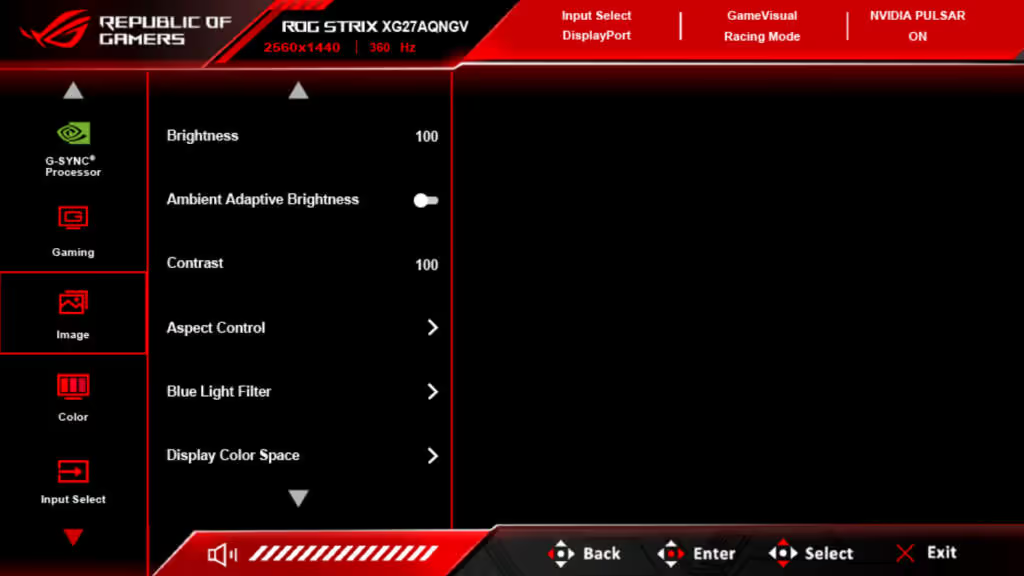

L’activation de G-SYNC Pulsar nécessite d’abord la mise à jour du pilote graphique, puis l’activation du G-SYNC via l’application NVIDIA. Ce n’est qu’après cette étape que l’option G-SYNC Pulsar apparaît dans l’OSD du moniteur. Sans activation préalable côté pilote, l’écran ne propose que le mode ULMB 2.

Un paramètre mérite une attention particulière : Pulsar Low FPS. Il définit le seuil minimal de fréquence d’images à partir duquel Pulsar reste actif. Par défaut, ce seuil est fixé à 90 FPS, avec une plage de réglage comprise entre 75 et 120 FPS.

Dès que le framerate passe sous cette valeur, Pulsar se désactive automatiquement. Ce comportement n’est pas anodin et joue un rôle central dans l’expérience perçue, comme le montrent les observations suivantes.

Les captures utilisées pour cette analyse proviennent d’enregistrements réalisés avec une caméra Sony ZV-E1 en 4K à 120 images par seconde, en mode caméra de suivi. Cette méthode permet de visualiser la persistance rétinienne et la stabilité des contours en mouvement, là où les captures écran classiques sont inadaptées.

G-SYNC Pulsar combinant VRR et stroboscopage, certaines séquences ont volontairement été limitées à des fréquences situées dans la plage VRR afin de mettre en évidence les gains de netteté en mouvement. La définition d’affichage est restée constante en 2560 × 1440.

Il est important de rappeler qu’à la différence d’un test de carte graphique, l’évaluation d’une technologie d’affichage reste fondamentalement subjective. Le ressenti peut varier selon la sensibilité de chaque joueur. L’objectif ici est donc de décrire avec précision ce qui est observé à l’écran, sans chercher à forcer une conclusion universelle.

À l’aide de l’outil LDAT fourni par NVIDIA, la différence devient immédiatement perceptible à 360 FPS constants. Avec G-SYNC Pulsar activé, la lisibilité du texte progresse nettement et les contours des éléments, notamment ceux du personnage de test, apparaissent plus nets et mieux définis.

Autre point notable : lorsque la fréquence d’images est ajustée à l’intérieur d’une plage donnée, la clarté de l’image reste remarquablement stable. Ce test demeure toutefois théorique. Les jeux, avec leurs mouvements complexes et leurs variations de contraste, sont bien plus révélateurs du comportement réel de Pulsar.

Counter-Strike 2 fait partie des titres utilisés par NVIDIA lors de la première démonstration de Pulsar au CES 2024. Même avec des réglages graphiques élevés et sans optimisation spécifique, le jeu atteint des fréquences d’images très élevées.

Dans ce scénario, G-SYNC Pulsar agit comme un raffinement supplémentaire. Les identifiants des joueurs, les insignes sur les bras et les jambes, et surtout le canon des armes affichent une stabilité et une netteté remarquables. Le bénéfice est particulièrement visible sur les éléments fins et fortement contrastés, cruciaux pour la lecture instantanée de l’action.

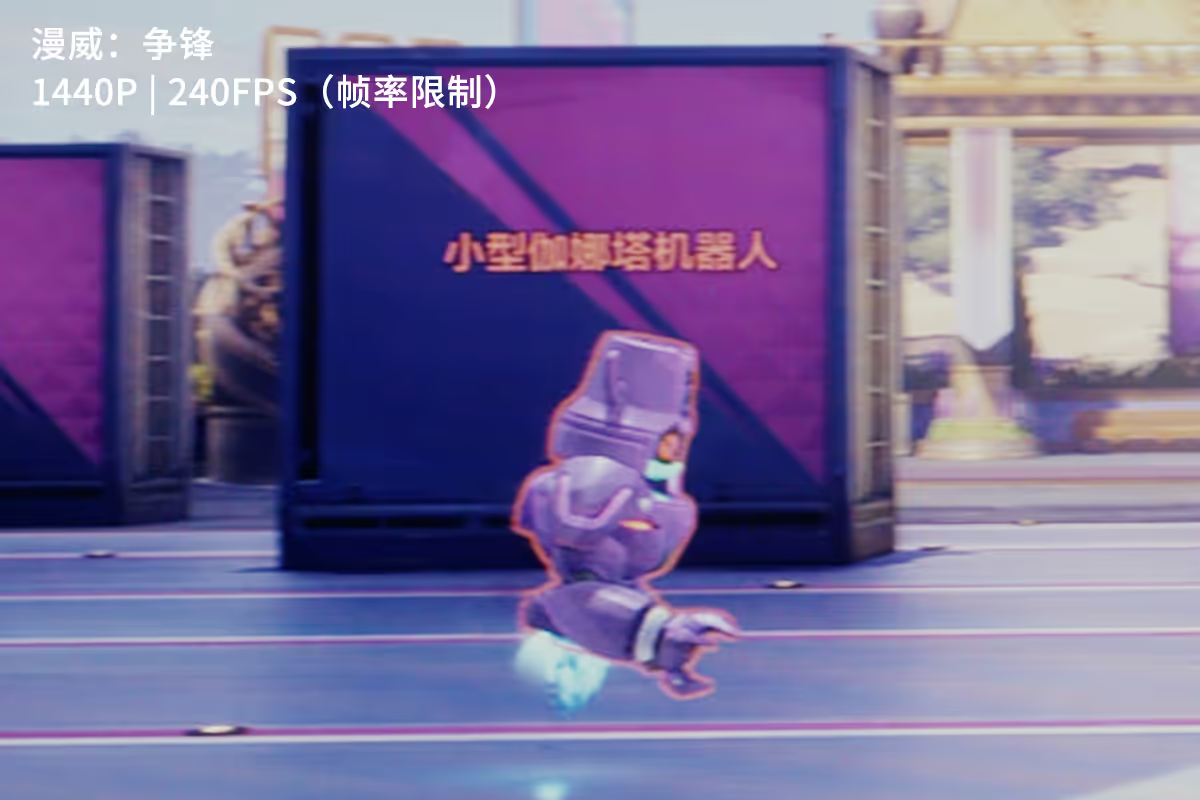

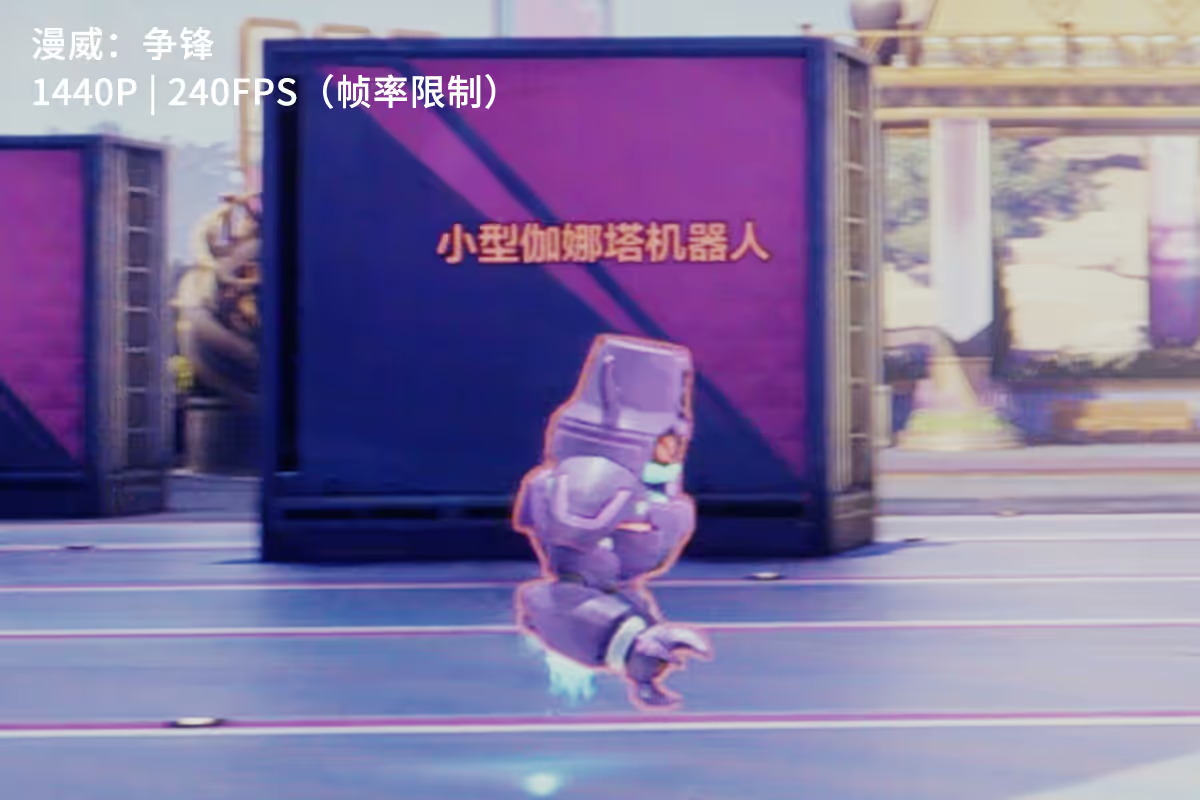

Dans Marvel Rivals, avec une moyenne d’environ 240 FPS, G-SYNC Pulsar améliore sensiblement la lisibilité des textes affichés au-dessus des robots du champ de tir. L’effet est particulièrement visible lorsque ces éléments se déplacent devant un fond fortement contrasté, comme le mur violet de la zone d’entraînement.

Les épaulières, et notamment le composant en forme de U, constituent un excellent point de comparaison. Avec Pulsar activé, leurs contours restent plus définis et plus stables lors des déplacements rapides, là où un affichage classique tend à lisser les détails.

Sur Overwatch 2, la fréquence d’images avoisine les 360 FPS. Dans ces conditions, l’amélioration sur les identifiants des robots reste relativement discrète. En revanche, le gain devient nettement plus perceptible sur les parties du corps en mouvement, comme les bras armés ou les propulseurs inférieurs.

Avec G-SYNC Pulsar activé, ces zones apparaissent plus stables et moins sujettes au flou. La tête du robot gagne également en netteté, donnant un rendu global plus propre, notamment lors des déplacements latéraux rapides.

Dans Anno 117 : Pax Romana, le contexte est très différent. Le jeu évolue autour d’une centaine d’images par seconde, avec des variations plus marquées. C’est précisément dans ce type de scénario que G-SYNC Pulsar révèle tout son intérêt.

Les spectateurs dans l’arène et les colonnes orange situées à proximité conservent une bien meilleure définition en mouvement. Lors des captures, la vitesse de déplacement de la caméra a même été volontairement réduite afin de permettre un suivi précis. En conditions de jeu normales, avec des mouvements plus rapides, le gain de lisibilité devient encore plus évident.

Le réglage Pulsar Low FPS rappelle une réalité technique essentielle : G-SYNC Pulsar n’est pas conçu pour fonctionner à basse fréquence d’images. En conservant le seuil par défaut à 90 FPS et en limitant Counter-Strike 2 à 120 FPS, un comportement spécifique apparaît.

Les textes restent parfaitement lisibles, chaque lettre est nette, mais l’ensemble présente un léger tremblement. Le même phénomène s’observe sur les personnages : très clairs visuellement, mais légèrement instables. En abaissant davantage la fréquence d’images, cet effet devient plus prononcé.

À l’inverse, désactiver Pulsar à 120 FPS rend les déplacements plus fluides, mais au prix d’un flou de mouvement nettement plus marqué. Le choix repose alors sur une préférence personnelle : une image extrêmement nette mais légèrement instable, ou une animation plus lisse mais visuellement plus floue. Pour la lisibilité et le ciblage, Pulsar conserve néanmoins un avantage clair.

Pour comprendre le fonctionnement de G-SYNC Pulsar et les mécanismes techniques derrière la réduction du flou de mouvement, nous renvoyons vers notre analyse complète de la technologie G-SYNC Pulsar.

Évaluer G-SYNC Pulsar et la gestion intelligente de l’éclairage ambiant ne se prête pas à un simple descriptif écrit. Décrire précisément la netteté des contours en mouvement ou l’adaptation dynamique de la luminosité reste délicat sans support visuel. Un écran demeure avant tout un périphérique perçu directement par l’œil, et aucune description ne remplace une observation personnelle.

Là où le texte devient essentiel, c’est pour expliquer ce qui se joue en coulisses. Une expérience dite e-sport repose sur un écosystème complet. G-SYNC Pulsar nécessite un framerate élevé et stable pour fonctionner de manière optimale, et les cartes GeForce RTX 50, associées au DLSS 4, fournissent précisément ce surplus de performances.

De la réduction de la latence avec Reflex, à l’augmentation du framerate via DLSS 4.5, jusqu’au rendu final avec G-SYNC Pulsar, NVIDIA agit sur l’ensemble de la chaîne logicielle et matérielle. Une approche globale, bien plus complexe que le simple lancement d’un écran, et qui explique pourquoi l’écosystème GeForce continue de séduire les joueurs les plus exigeants.

G-SYNC Pulsar n’est pas qu’une nouvelle case marketing ajoutée à la longue liste des technologies NVIDIA. C’est la première tentative crédible de combiner deux approches jusqu’ici incompatibles : le rafraîchissement variable pour la fluidité, et le rétroéclairage stroboscopique pour la netteté en mouvement.

Sur le papier, la promesse est spectaculaire. En pratique, elle est plus subtile, conditionnelle, et dépend fortement du framerate réel. Pour comprendre ce que G-SYNC Pulsar apporte vraiment, et surtout quand il devient pertinent ou non, il faut aller bien au-delà des démonstrations CES et des chiffres mis en avant par NVIDIA.

PS : G-SYNC Pulsar est une technologie propriétaire de NVIDIA qui requiert une carte graphique GeForce RTX, à partir de la série 20, ainsi qu’un moniteur certifié Pulsar. Elle n’est donc pas compatible avec les cartes AMD Radeon ni Intel Arc.

Augmenter la fréquence de rafraîchissement ne suffit pas à supprimer le flou de mouvement. Même à 360 Hz, un écran LCD se heurte à deux limites physiques : le mode d’affichage “sample-and-hold” et la persistance rétinienne.

Sur une dalle classique, chaque image reste affichée en continu jusqu’à la suivante. Lorsqu’un objet se déplace, l’œil humain suit naturellement ce mouvement, mais l’image, elle, reste figée pendant toute la durée de la frame. Cette discordance génère un flou perçu, quel que soit le temps de réponse des pixels.

Même avec des transitions gris à gris (GtG) instantanées, le problème demeure : c’est le temps d’exposition qui compte. À 360 Hz, une image est affichée pendant environ 2,78 ms, ce qui laisse amplement le temps à la persistance rétinienne de flouter les contours lors d’un mouvement rapide.

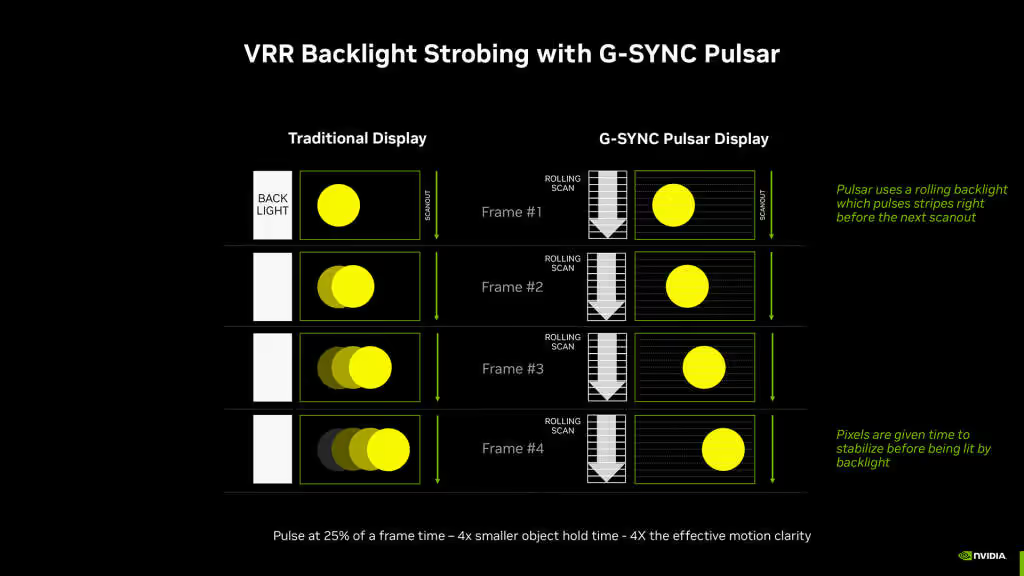

C’est pour briser ce plafond que les technologies ULMB et ULMB 2 ont été développées. Leur objectif n’est plus d’accélérer les pixels, mais de réduire la durée d’affichage effective de chaque image en faisant clignoter le rétroéclairage.

Avant G-SYNC Pulsar, NVIDIA utilisait le rétroéclairage stroboscopique avec l’ULMB (Ultra Low Motion Blur). Le principe : éteindre le rétroéclairage pendant la transition des pixels pour ne l’allumer qu’une fois l’image stabilisée. En réduisant le temps de visibilité de la frame, on limite la persistance rétinienne.

L’ULMB de première génération souffrait toutefois de dalles LCD trop lentes. Pour laisser aux pixels le temps d’atteindre leur cible, il fallait brider la fréquence (ex: 120 Hz sur un écran 144 Hz). S’y ajoutaient une chute de luminosité et de la diaphonie (crosstalk), ces traînées visibles en haut et en bas de l’écran dues au balayage ligne par ligne.

ULMB 2 a corrigé ces défauts grâce à des dalles plus rapides et un pilotage fin de l’overdrive. La technologie a pu atteindre les 360 Hz, tout en réduisant la diaphonie grâce à un overdrive dépendant de la position verticale de l’image.

Malgré ces progrès, une contrainte structurelle persistait : ULMB et ULMB 2 exigent une fréquence de rafraîchissement fixe. Le stroboscopage repose sur un rythme régulier ; dès que la fréquence varie (VRR), la synchronisation se brise, provoquant scintillements et inconfort visuel. Jusqu’à Pulsar, le joueur devait donc choisir : la fluidité sans tearing du VRR, ou la netteté chirurgicale de l’ULMB.

G-SYNC Pulsar n’invente pas une nouvelle dalle, mais résout un casse-tête : maintenir un stroboscopage efficace alors que la fréquence d’affichage varie. Pulsar n’est plus dépendant d’un module FPGA coûteux. NVIDIA s’est associé à MediaTek pour intégrer l’intelligence du système directement dans le scaler MT9810.

Pour synchroniser le rétroéclairage avec le VRR, NVIDIA articule trois piliers techniques :

La synergie de ces mécanismes permet enfin d’allier stroboscopage et rafraîchissement variable. En pratique, Pulsar réduit le temps d’exposition à environ un quart de la durée d’une frame.

C’est ici qu’il faut dissiper une confusion : Pulsar n’augmente pas la fluidité (la régularité de l’animation), il réduit la durée de visibilité des images. Le gain est massif sur la netteté, mais il ne change pas la nature du mouvement lui-même.

L’un des principaux malentendus autour de G-SYNC Pulsar réside dans la confusion entre ces deux concepts. Bien qu’ils soient liés, ils ne désignent pas le même phénomène physique :

C’est précisément là que G-SYNC Pulsar intervient. En limitant l’illumination du rétroéclairage à une fraction de la durée d’une frame, la technologie réduit la durée de visibilité de chaque image. Le mouvement devient plus lisible : les contours sont définis et les détails identifiables lors de déplacements rapides de caméra.

Cette clarté peut donner l’illusion d’une fluidité accrue, mais c’est un abus de langage. À l’inverse, un framerate extrême sans réduction du flou produit une animation fluide mais visuellement imprécise, où les détails se diluent dès que l’action s’accélère.

En résumé : Pulsar ne remplace ni le framerate ni le VRR. Il les complète en s’attaquant à un problème sous-estimé mais critique dans le jeu compétitif : la capacité à discerner clairement une cible en mouvement.

L’idée semble contre-intuitive, mais elle s’explique par la Netteté Dynamique Effective. La formule est simple :

Efficacité = Fréquence \times (1 / Ratio d'allumage)Pulsar utilise un cycle d’allumage de seulement 25 %.

À 250 FPS, une frame dure 4 ms, mais l’image n’est visible que pendant 1 ms. Résultat : chaque image est perçue de façon beaucoup plus brève, les contours sont définis et les objets semblent mieux “ancrés” dans l’espace. Dans un FPS comme CS2 ou Overwatch 2, cette identification instantanée d’une cible est plus déterminante qu’un framerate brut mais flou.

Le réglage Pulsar Low FPS n’est pas qu’une option de confort : c’est l’aveu implicite des contraintes de la technologie. NVIDIA impose ici un seuil minimal de framerate sous lequel Pulsar se désactive pour éviter des effets visuels indésirables.

Lorsque le framerate chute, l’intervalle entre deux images s’allonge. Dans ces conditions, la réduction du temps d’exposition peut provoquer une dissociation entre la position de l’objet et son mouvement perçu. Concrètement, l’image reste nette, mais le mouvement devient instable : les objets semblent “vibrer” ou manquer de continuité. Ce micro-jitter est le prix à payer pour maintenir la netteté sur une animation trop lente.

C’est pourquoi NVIDIA permet d’ajuster ce seuil (généralement entre 75 et 120 FPS) :

Ce garde-fou rappelle une vérité fondamentale : G-SYNC Pulsar ne masque pas un framerate insuffisant. La technologie amplifie la clarté d’un flux déjà performant, mais ne transformera jamais un jeu à 60 FPS en expérience « haute fréquence ». Dans les titres gourmands ou mal optimisés, désactiver Pulsar au profit d’un VRR classique peut paradoxalement s’avérer plus confortable.

Les écrans G-SYNC Pulsar de nouvelle génération intègrent également une technologie d’adaptation intelligente à la lumière ambiante. Le principe est simple : transposer sur un moniteur des fonctions bien connues sur les appareils mobiles, comme l’ajustement automatique de la luminosité et de la température de couleur. Sur le modèle testé, un capteur placé sur la partie supérieure de l’écran analyse en temps réel l’éclairage de la pièce afin d’adapter l’affichage et d’offrir un confort visuel plus constant.

Cette fonction reste entièrement optionnelle et s’active manuellement. Elle n’interfère donc pas avec une utilisation compétitive. Elle fonctionne de manière autonome, sans dépendre du pilote graphique ni du système, et ne nécessite qu’une activation directe via l’OSD du moniteur.

À l’usage, le principal atout de cette technologie réside dans sa discrétion. Les transitions de luminosité, qu’elles aillent vers le plus clair ou le plus sombre, se font de façon progressive, sans variation brutale lorsque l’environnement change.

Il en va de même pour la température de couleur, qui évolue en douceur, sans que l’utilisateur ne perçoive immédiatement un écran plus chaud ou plus froid. Cette adaptation quasi imperceptible se révèle même plus naturelle que celle proposée par certains ordinateurs portables, ce qui contribue à un confort visuel durable, notamment lors de longues sessions.

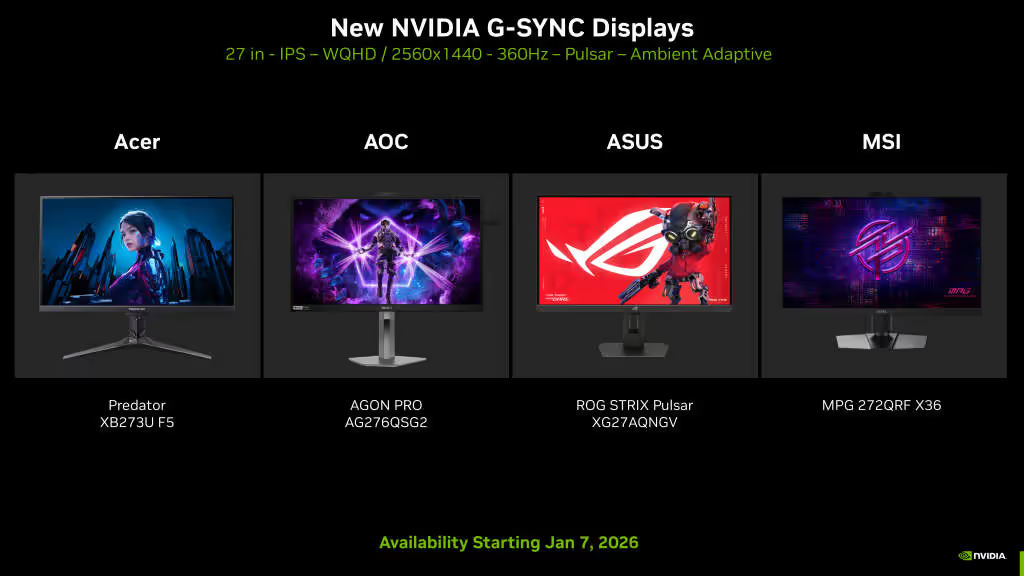

Les premiers modèles confirmés compatibles G-SYNC Pulsar sont tous des écrans 27 pouces, dalle IPS, WQHD à 360 Hz avec adaptive lighting :

Ces modèles sont annoncés comme disponibles à partir du 7 janvier 2026.

Pulsar a un terrain de jeu naturel : l’esport, les shooters rapides, les jeux où la lecture instantanée d’une cible en mouvement est plus importante que le rendu cinématographique. Dès que tu tiens un framerate élevé et stable, le gain de lisibilité devient un avantage concret.

À l’inverse, sur un jeu lourd avec de grosses variations de framerate autour du seuil, il peut être plus agréable de repasser en VRR classique. Une image un peu plus floue mais stable est parfois plus confortable qu’une image ultra nette qui révèle une instabilité du mouvement.

Face à ULMB 2, G-SYNC Pulsar représente une évolution logique plutôt qu’une rupture. ULMB 2 reste extrêmement efficace à fréquence fixe, avec une netteté remarquable lorsque les conditions sont idéales. Pulsar ajoute la flexibilité du rafraîchissement variable, au prix d’une complexité accrue et de contraintes plus marquées sur le framerate.

Comparé aux écrans OLED, le positionnement est différent. Les dalles OLED offrent des temps de réponse quasi instantanés et un contraste supérieur, mais elles n’éliminent pas la persistance rétinienne liée au mode sample-and-hold. En l’absence de rétroéclairage stroboscopique compatible VRR, la netteté en mouvement reste limitée dans certaines situations, malgré la rapidité des pixels.

G-SYNC Pulsar ne concurrence donc pas directement l’OLED sur le terrain du contraste ou de la réactivité brute. Il propose une réponse spécifique à un problème précis : la lisibilité des mouvements rapides sur des écrans LCD à très haute fréquence, dans un contexte compétitif.

Aller plus loin : test terrain de G-SYNC Pulsar avec RTX 5090

G-SYNC Pulsar n’est ni une technologie miracle, ni une simple étiquette marketing. C’est une solution chirurgicale, conçue pour des joueurs équipés d’un matériel capable de maintenir un framerate élevé et stable, et pour qui la netteté en mouvement est la priorité absolue.

Dans les bonnes conditions, le gain est immédiat : une lisibilité accrue des scènes rapides sans sacrifier les bénéfices du rafraîchissement variable. Mais dès que l’on s’éloigne de ce cadre idéal, l’intérêt de la technologie diminue et ses contraintes (jitter, gestion des réglages) deviennent plus visibles.

Comprendre ces limites est essentiel. Plus qu’un argument universel, G-SYNC Pulsar doit être envisagé comme un outil spécialisé, à activer de manière réfléchie en fonction du jeu, du matériel et de vos propres attentes en tant que joueur. En 2026, il reste l’atout maître de ceux qui refusent de choisir entre la fluidité du G-SYNC et la clarté de l’ULMB.

Une technologie NVIDIA qui combine rafraîchissement variable (VRR) et rétroéclairage stroboscopique pour améliorer la netteté en mouvement, sans imposer une fréquence fixe comme les modes ULMB classiques.

Parce que la majorité des écrans LCD restent en affichage “sample-and-hold” : l’image reste visible pendant toute la frame. L’œil suit l’objet, l’image reste figée, le flou apparaît.

Non. Même avec des pixels très rapides, le facteur déterminant reste le temps d’exposition de l’image. Tant qu’une frame reste affichée plusieurs millisecondes, la persistance rétinienne crée du flou.

À réduire le flou en clignotant le rétroéclairage, donc en raccourcissant la durée de visibilité de chaque image. Le but n’est pas d’accélérer les pixels, mais de limiter l’exposition.

Les dalles LCD étaient trop lentes : il fallait du temps pour stabiliser l’image avant l’éclair. Résultat, fréquence réduite, luminosité en baisse et risque de diaphonie (crosstalk) sur les mouvements.

Des dalles plus rapides et un overdrive mieux piloté, avec correction selon la position verticale de l’image. Cela réduit la diaphonie et permet d’atteindre des hautes fréquences dans de meilleures conditions.

Le stroboscopage exige un rythme régulier. Quand la fréquence varie, la synchronisation se dérègle, ce qui peut provoquer scintillements et inconfort. Avant Pulsar, il fallait choisir entre VRR et strobing.

Pulsar vise une intégration plus accessible en s’appuyant sur un scaler compatible plutôt qu’un module FPGA dédié. L’objectif est de gérer la synchronisation strobing + VRR au niveau du traitement d’affichage.

L’écran est éclairé par bandes, de haut en bas, avec un timing contrôlé. Chaque zone s’illumine quand ses pixels sont prêts, ce qui limite la diaphonie et améliore la précision des objets en mouvement.

En VRR, l’intervalle entre deux images change, ce qui ferait varier la luminosité. Pulsar ajoute des impulsions correctives pour stabiliser la luminosité perçue et réduire les effets de scintillement.

L’overdrive s’ajuste en temps réel selon le délai avant la prochaine image. À haut FPS, il peut pousser plus fort pour accélérer. À bas FPS, il se calme pour éviter overshoot et artefacts.

À définir un seuil minimal de FPS. En dessous, Pulsar se désactive pour éviter une sensation de mouvement instable. Plus le seuil est haut, plus c’est stable, mais moins Pulsar reste actif.

Sur des jeux compétitifs rapides, quand tu tiens un framerate élevé et stable. Le gain est surtout la lisibilité en mouvement : suivi de cible, micro-ajustements, lecture instantanée pendant les rotations rapides.

Si le framerate fluctue fortement autour du seuil ou descend trop bas. Une image très nette peut rendre les irrégularités plus visibles. Dans ces cas, un VRR classique peut être plus confortable.

Ce n’est pas le même objectif. L’OLED excelle en temps de réponse et contraste, mais reste souvent en “sample-and-hold”. Pulsar vise la netteté en mouvement sur LCD haute fréquence via strobing compatible VRR.

Un capteur ajuste automatiquement luminosité et température de couleur selon la lumière ambiante. C’est optionnel, activable via l’OSD, et indépendant du pilote graphique, pour un confort visuel plus constant.

Un écran Pulsar compatible, une configuration capable de maintenir un FPS élevé, et des réglages cohérents (seuil Low FPS, mode VRR). Sans stabilité de framerate, l’intérêt baisse rapidement.

Le 7 août 2019, dans le Mississippi, des centaines d'enfants rentrent de leur premier jour d'école. Cartables sur le dos, ils s'attendent à retrouver leurs parents pour raconter leur journée.

Mais à la place, ils découvrent des maisons vides ou des usines encerclées par des agents fédéraux. Ce jour-là, l'ICE (les services d'immigration américains) mène la plus grande opération de l'histoire du pays en un seul État : 680 personnes sont arrêtées, menottées et embarquées dans des camionnettes blanches.

L'enquête qui a mené à ces rafles n'a pas été montée "à l’ancienne" sur un tableau en liège avec des punaises et de la ficelle rouge. Dans des affidavits et les documents obtenus via des demandes FOIA, on voit apparaître un nom de module qui revient comme un sortilège : FALCON Tipline. Un outil Palantir vendu à la branche Homeland Security Investigations (HSI) et utilisé pour centraliser, recouper et exploiter des signalements, des identités, des liens, des infos de terrain… jusqu’à planifier des actions coordonnées comme celle du Mississippi.

Le plus "magique" (façon Mordor), c'est que tout ça s'appuie sur un contrat très concret, très administratif, qui décrit FALCON comme une plateforme de recherche fédérée et d’analyse, capable de faire parler ensemble des bases de données qui n'étaient pas censées se rencontrer. Voilà. Rien de secret... Juste le genre de PDF qui sent la paperasse… mais qui peut briser des vies.

Mais si cette logistique monstrueuse a pu être déployée avec une telle précision chirurgicale, c'est grâce à une technologie dont vous n'avez peut-être jamais entendu parler, mais qui sait déjà probablement tout de vous.

Son nom ? Palantir.

Pour comprendre comment une startup de la Silicon Valley est devenue l'œil de Sauron qui surveille le monde, il faut remonter au début des années 2000. On est juste après le 11 septembre. L'Amérique est en état de choc et ses agences de renseignement cherchent désespérément un moyen de "connecter les points" (connect the dots comme ils disent...) pour prévenir la prochaine attaque.

Le Pentagone essaie bien de lancer un programme de surveillance totale appelé Total Information Awareness, mais le projet est jugé trop orwellien et se fait descendre par l'opinion publique en 2003. C'est exactement à ce moment-là que Peter Thiel décide de fonder Palantir Technologies avec Stephen Cohen, Joe Lonsdale, Nathan Gettings et Alex Karp.

Ce qui est "marrant", c’est qu’on a enterré le programme (trop visible, trop caricatural), mais pas l’idée. Palantir arrive pile au bon moment : la même promesse, mais emballée dans un joli paquet cadeau d'outil d’analyse, vendue par une boîte privée, et surtout, développée directement avec les gens qui allaient s’en servir.

La surveillance version startup, avec des NDA, des badges et des salles sans fenêtre était née...

Peter Thiel, c'est un personnage à part dans la tech. Co-fondateur de PayPal, premier investisseur de Facebook, libertarien pur jus et fan absolu de J.R.R. Tolkien. Le nom "Palantir" vient d'ailleurs du Seigneur des Anneaux puisque ce sont ces pierres de vision qui permettent de voir à travers le temps et l'espace.

Le truc, c'est que chez PayPal, Thiel et son équipe avaient déjà développé des algorithmes de détection de fraude super performants baptisés "Igor". C'est pour cela que Thiel s'est dit "Hé, et si on appliquait ces mêmes méthodes de traque financière à la lutte antiterroriste ?"

Peter Thiel ( source )

Le problème, c'est qu'en 2004, personne à la Silicon Valley ne veut toucher à la défense. Les investisseurs flippent, du coup, Thiel et son fonds d'investissement posent environ 30 millions de dollars pour couvrir les premiers coûts et vont chercher un allié improbable : In-Q-Tel, le fonds de capital-risque à but non lucratif soutenu par la CIA.

In-Q-Tel injecte environ 2 millions de dollars et au delà de l'argent, c'est une surtout une validation capitale pour la société. Et c'est ainsi que durant trois ans, les ingénieurs de Palantir vont bosser main dans la main avec les analystes du renseignement pour construire leur premier logiciel : Gotham.

Et quand je dis "bosser main dans la main", c’est pas une image. Leur délire, c’était d’envoyer des ingénieurs directement chez les clients, dans les agences, parfois sur site sensible, pour modeler l’outil à la demande. Pas une ESN, hein… plutôt une greffe. Tu poses le logiciel, tu poses les devs, et tu laisses la créature grandir dans l’ombre.

Pour diriger cette boîte de surveillance, Thiel choisit Alex Karp. Un mec encore plus atypique que lui. Karp est un philosophe, titulaire d'un doctorat en théorie sociale de l'université de Francfort, dyslexique, qui ne sait pas conduire et qui passe cinq heures par jour à faire du ski de fond ou du Qigong. Il vit dans une baraque perdue dans le New Hampshire et se décrit comme un "gauchiste fou", alors que Thiel est un "dingue de droite". Ce duo improbable va pourtant créer l'entreprise la plus puissante et la plus secrète de la planète.

Alex Karp ( source )

Le fonctionnement de Gotham est simple sur le papier, mais terrifiant en pratique. Pensez à un aspirateur géant capable d'ingérer n'importe quel type de donnée : Imagerie satellite, rapports d'interrogatoires, conversations sur les réseaux sociaux, fichiers fiscaux, plaques d'immatriculation, relevés bancaires. Le logiciel fusionne tout ça pour créer un "jumeau numérique" du monde réel. Si vous avez un compte chez Ladar Levison (le fondateur de Lavabit qui a hébergé Snowden) ou que vous avez été mentionné dans une écoute de la NSA, Palantir peut recréer tout votre réseau social en quelques clics.

C'est d'ailleurs avec les révélations d'Edward Snowden que le monde a commencé à entrevoir l'ampleur du truc. En 2017, des documents montrent que Palantir proposait des outils comme "XKEYSCORE Helper" pour faciliter l'analyse des données capturées par la NSA. Le logiciel permettait aux agents de naviguer dans des masses de données privées avec une fluidité déconcertante. Même si Alex Karp jure sur tous les tons qu'il protège les libertés civiles, la réalité des contrats raconte une autre histoire.

Et ce n’est pas qu’un délire "NSA / USA". Dans la même veine, des docs évoquent aussi Kite, un système custom pour le GCHQ (les espions britanniques), avec des champs et des imports extensibles pour avaler des formats de données bien tordus. Palantir, évidemment, a tenté de calmer le jeu ensuite en expliquant que "XKEYSCORE helper" n’était qu’un module périphérique et limité, pas un accès à la matrice complète…

Mais l’histoire "secrète" de Palantir a aussi un épisode qui sent la naphtaline et le scandale. En effet, en 2010-2011, des emails fuités (merci Anonymous) ont montré qu'une dream team HBGary / Berico / Palantir avait participé à la préparation d’un plan de riposte contre WikiLeaks et ses soutiens. Dans le package, on parlait de méthodes sales, de pression, et même d’idées de désinformation. Résultat, Palantir a publiquement présenté ses excuses et a coupé les ponts avec HBGary.

Je vous parle quand même d'une boîte qui a récupéré le contrat Maven Smart System (le fameux Project Maven) quand Google l'a lâché suite à la révolte de ses employés. Maven utilise l'IA pour aider les analystes militaires à identifier des cibles au milieu d'un déluge de données de surveillance.

Et aujourd'hui, Palantir est partout.

En Ukraine, Alex Karp a été le premier PDG occidental à rencontrer Zelensky après l'invasion russe de 2022. Leurs logiciels servent à faire de la fusion de données à grande vitesse (drones, satellites, sources ouvertes) pour accélérer la décision militaire. Et ça ne s'arrête pas là puisqu'en juillet 2025, l'armée américaine a signé un accord-cadre monumental jusqu'à 10 milliards de dollars sur 10 ans pour consolider et simplifier l'achat des logiciels Palantir.

Mais Palantir ne s'arrête pas aux zones de guerre. L'entreprise s'infiltre dans nos services publics. Au Royaume-Uni, un consortium mené par Palantir a décroché un contrat de 330 millions de livres pour gérer la Federated Data Platform du NHS (le système de santé national). En septembre 2025, ils ont même remis ça avec un partenariat défense annoncé par le gouvernement britannique, censé débloquer jusqu'à 1,5 milliard de livres d'investissements et faire du Royaume-Uni leur QG européen défense. En France, la DGSI a longtemps utilisé Palantir avant d'essayer de construire sa propre alternative pour retrouver sa souveraineté numérique… sauf que fin 2025, le contrat a encore été prolongé "temporairement", en attendant que l’outil souverain arrive vraiment.

Et ce qui est vraiment inquiétant avec Palantir, c'est ce qu'ils proposent en matière de "police prédictive". Par exemple, à Los Angeles ou à la Nouvelle-Orléans, leurs algorithmes ont été utilisés pour tenter d'identifier des zones ou des individus à risque. En gros, le logiciel décide si vous avez le profil d'un futur délinquant en analysant vos liens sociaux et vos antécédents. À la Nouvelle-Orléans, le programme a même tourné pendant des années dans une discrétion quasi totale, sans que le conseil municipal ne soit vraiment au courant, jusqu'à ce que la presse sorte l'affaire. Des audits ont d'ailleurs montré que ces systèmes pouvaient renforcer les préjugés et cibler injustement certaines communautés. Tu m'étonnes...

Exemple de dashboard de police prédictive ( source )

Aujourd'hui, Palantir est cotée en bourse et sa valorisation explose littéralement (on parle d'environ 430 milliards de dollars début 2026). Alex Karp a réussi son pari à savoir rendre la surveillance de masse extrêmement rentable. L'entreprise vise d'ailleurs un chiffre d'affaires annuel autour de 4,4 milliards de dollars sur 2025, porté par sa nouvelle plateforme d'IA (AIP) et ses "agents" autonomes capables de structurer n'importe quelle base de données en un clin d'œil. Mais comme dans Tolkien, les palantír sont des outils dangereux. Celui qui les utilise peut être lui-même observé et corrompu.

Alors, faut-il avoir peur de Palantir ? Clairement oui !

Quand on voit comment Snowden explique la surveillance aujourd'hui, on comprend que Palantir est l'outil qui rend l'espionnage d'État accessible à n'importe quel analyste, sans qu'il ait besoin d'être un génie du code. C'est la démocratisation d'Orwell à grande échelle.

Bref, la prochaine fois que vous entendrez parler d'une startup qui veut "aider les gouvernements à mieux gérer leurs données", rappelez-vous de l'histoire du Mississippi en 2019 et de Palantir car derrière les beaux discours sur la sécurité, il y a souvent des algorithmes invisibles et des pierres de vision qui ne dorment jamais.

Sources :

Vous connaissez probablement les prouesses de Claude Code pour décompiler du code , ou encore son utilisation pour automatiser la création d'outils , mais là, on a passé un cap.

Bernard Lambeau, un développeur belge avec plus de 25 ans d'expérience et un doctorat en informatique, a décidé de pousser le concept jusqu'au bout à savoir utiliser Claude Code non pas pour écrire quelques scripts, mais pour générer un langage de programmation complet.

Carrément ! Il est chaud Bernard, car quand je dis complet, je parle d'un compilateur entier avec analyseur lexical, un parseur, un système de typage, des backends multiples...etc. Voilà, comme ça, en full pair-programming avec une IA.

Ça s'appelle Elo et l'idée, c'est de proposer un langage tellement sécurisé by design qu'on peut le confier à des non-développeurs… ou à des IA. Pas de variables mutables, pas d'effets de bord, pas de références qui traînent dans tous les sens. Bref, un langage où il est quasi impossible de faire une bêtise, même en essayant très fort.

Alors pourquoi créer un énième langage alors qu'on en a déjà des centaines ?

Hé bien le truc, c'est que la plupart des langages existants partent du principe que vous savez ce que vous faites. JavaScript, Python, Ruby… Ils vous font confiance. Trop, parfois.

Elo, lui, adopte l'approche inverse... le "zero-trust". Le langage ne fait confiance à personne, ni au développeur, ni à l'IA qui pourrait l'utiliser. Ainsi, chaque expression est pure, chaque fonction est déterministe, et le compilateur vérifie tout avant d'exécuter quoi que ce soit.

Et surtout Elo est un langage d'expressions portables, ce qui veut dire que vous écrivez votre logique une fois, et vous pouvez la compiler vers JavaScript, Ruby ou même du SQL PostgreSQL natif. Oui, oui, le même code peut tourner dans votre navigateur, sur votre serveur Ruby, ou directement dans votre base de données. Et là, y'a de quoi faire des trucs sympas pour peu qu'on ait besoin de partager de la logique métier entre différents environnements.

Le typage est volontairement minimaliste mais costaud et se compose de 10 types de base : Int, Float, Bool, String, DateTime, Duration, Tuple, List, Null et Function. Pas de classes, pas d'héritage, pas d'objets au sens classique mais juste des valeurs et des fonctions, ce qui peut paraître limité dit comme ça, mais c'est justement cette contrainte qui rend le langage sûr.

Moins de features, c'est moins de façons de se planter !

L'opérateur pipe |> est le cœur du langage car au lieu d'imbriquer des appels de fonctions comme des poupées russes, vous chaînez les transformations de gauche à droite. Par exemple, pour récupérer tous les clients actifs et compter combien il y en a, vous écrivez quelque chose comme customers |> filter(active: true) |> size. C'est lisible, c'est fluide, et même quelqu'un qui n'a jamais codé comprend ce qui se passe.

Et il y a aussi l'opérateur alternative |. Comme ça, si une expression peut retourner null, vous pouvez prévoir un fallback avec ce simple pipe. Genre user.nickname | user.firstname | "Anonymous". Ça essaie dans l'ordre et ça prend la première valeur non-nulle.

Comme ça, fini les cascades de if/else pour gérer les cas où une donnée manque ! Youpi !

Voilà pour le langage...

Maintenant parlons un peu du bonhomme car Bernard Lambeau n'est pas un inconnu dans le monde du développement. Il est derrière Bmg (une implémentation de l'algèbre relationnelle), Finitio (un langage de schémas de données), Webspicy (pour tester des APIs), et Klaro Cards (une app no-code). Tout cet écosystème partageait déjà une certaine philosophie, et Elo vient unifier le tout. Son langage est d'ailleurs utilisé en production dans Klaro Cards pour exprimer des règles métier que les utilisateurs non-techniques peuvent modifier.

Ce qui m'a intéressé dans toute cette histoire, c'est surtout la méthode de développement de Bernard qui a travaillé en pair-programming avec Claude Code pendant des semaines, voire des mois. L'IA générait du code, et lui relisait, corrigeait, guidait, et l'IA apprenait de ces corrections pour les itérations suivantes. Sur l'ensemble du projet, chaque ligne de code, chaque test, chaque doc a été écrit par Claude et croyez le ou non, le code est clean car Bernard est un pro !

D'ailleurs, il a enregistré une démo de 30 minutes où il montre le processus en live .

En regardant cette démo, on découvre une vraie méthodologie de travail avec l'IA car il n'a pas juste balancé des prompts au hasard en espérant que ça marche. Au contraire, il a mis en place tout un système pour que la collaboration soit efficace et sécurisée.

Premier truc : le "safe setup". Bernard a configuré un environnement Docker sandboxé dans un dossier .claude/safe-setup afin de laisser Claude Code exécuter du code dans un conteneur Alpine isolé, sans risquer de faire des bêtises sur la machine hôte. En entreprise, c'est exactement le genre de garde-fou qu'on veut quand on laisse une IA bidouiller du code. Le conteneur a ainsi accès aux fichiers du projet, mais pas au reste du système.

Ensuite, il y a la documentation projet via un fichier CLAUDE.md à la racine. Ce fichier décrit l'architecture du langage avec le parser, l'AST, le système de typage, les différents backends, comme ça, quand Claude démarre une session, il lit ce fichier et comprend la structure du projet.

La gestion des tâches est aussi bien pensée puisqu'il utilise un système de dossiers façon Kanban : to-do, hold-on, done, et analyze. Chaque tâche est un fichier Markdown qui ressemble à une user story.

Ainsi, quand il veut ajouter une feature, il crée un fichier dans to-do avec la description de ce qu'il veut. Claude lit le fichier, implémente, et Bernard déplace le fichier dans done une fois que c'est validé. Le dossier analyze sert pour les trucs à creuser plus tard, et hold-on pour ce qui attend des décisions.

Ce qui est bien trouvé aussi, c'est qu'il utilise trois modes d'interaction selon les situations. Le mode "accept-it" pour les trucs simples où Claude propose et Bernard dispose. Le "plan mode" quand la tâche est complexe avec Claude qui pose des questions de design avant d'écrire du code. Et le mode autonome avec --dangerously-skip-permissions quand il a parfaitement confiance pour une série de modifications.

Bernard a aussi créé plusieurs personas spécialisés (des agents) que Claude peut invoquer. Un agent "security" qui analyse le code du point de vue sécurité. Un agent "DDD" (Domain-Driven Design) qui vérifie la cohérence du vocabulaire métier. Un agent "skeptic" qui cherche les cas limites et les bugs potentiels. Et un agent "Einstein" qui détecte quand le code devient trop complexe et suggère des simplifications.

En gros, 4 cerveaux virtuels qui relisent chaque modification.

Et là où ça devient vraiment ouf, c'est que Elo se teste lui-même. Les tests d'acceptance sont écrits en Elo, avec une syntaxe d'assertions qui se compile vers JavaScript, Ruby et SQL. Comme ça quand Bernard ajoute une feature, il écrit d'abord le test en Elo, puis Claude implémente jusqu'à ce que le test passe. Le langage valide sa propre implémentation.

Comme je vous l'avais dit, c'est propre !

Bernard n'a fait que valider et refuser et ne retouche jamais le code lui-même. C'est Claude qui fait tout le reste et ça c'est un sacré changement dans la façon de développer.

Il évoque aussi l'idée que quand on délègue une compétence à quelqu'un (ou quelque chose) qui la maîtrise, on peut se concentrer sur le reste. Comme ça, Bernard ne s'occupe donc plus d'écrire du code mais s'occupe plutôt de définir ce que le code doit faire, de valider les résultats, et de guider l'architecture.

C'est vraiment le métier de développeur nouvelle génération et c'est très inspirant si vous cherchez votre place de dev dans ce nouveau monde.

En tout cas, même si ce n'est pas la première fois qu'on voit Claude Code produire des résultats impressionnants là c'est carrément autre chose.

Maintenant si vous voulez tester, l'installation est simple. Un petit

`npm install -g @enspirit/elo`

Et vous aurez ensuite accès à deux outils :

elo pour évaluer des expressions à la volée, eteloc pour compiler vers la cible de votre choix.Et si vous voulez du JavaScript ?

eloc -t js votre_fichier.elo.

Du Ruby ?

eloc -t ruby.

Du SQL ?

eloc -t sql.

Le site officiel propose également un tutoriel interactif plutôt bien fichu pour découvrir la syntaxe. On commence par les bases (les types, les opérateurs), on passe aux fonctions, aux gardes, et on finit par les trucs plus avancés comme les closures et les comparaisons structurelles. En une heure ou deux, vous avez fait le tour.

Alors bien sûr, Elo n'est pas fait pour remplacer votre langage préféré car ce n'est pas un langage généraliste. Vous n'allez pas écrire une app mobile ou un jeu vidéo avec... Par contre, pour exprimer des règles métier, des validations, des transformations de données… C'est pile poil ce qu'il faut.

Peut-être qu'un jour on verra une équipe où les product managers écrivent directement les règles de pricing ou d'éligibilité en Elo , (j'ai le droit de rêver) et où ce code est automatiquement validé par le compilateur avant d'être déployé.

Plus de traduction approximative entre le métier et les devs, plus de bugs parce que quelqu'un a mal interprété une spec.

Le dépôt GitHub est ouvert , la documentation est dispo, et le langage est sous licence MIT donc vous avez de quoi explorer, tester, et pourquoi pas contribuer si le cœur vous en dit.

Voilà, avec Claude Code (ou d'autres comme Gemini CLI, Codex CLI...etc) on n'est clairement plus sur des outils qui complètent du code ou qui génèrent des snippets. On est carrément sur un système IA capable de créer des outils complets et des langages entiers, avec son humain préféré qui joue le rôle de chef d'orchestre.

Steve Klabnik a d'ailleurs fait quelque chose de similaire avec son langage Rue, lui aussi développé avec Claude, si vous voulez jeter un œil !

Voilà les amis ! La tendance est claire j'crois... les développeurs expérimentés commencent à utiliser l'IA comme un multiplicateur de force, et pas comme un remplaçant et je pense vraiment que vous devriez vous y mettre aussi pour ne pas vous retrouver à la ramasse dans quelque années...

Amusez-vous bien et un grand merci à Marc d'avoir attiré mon attention là dessus !

Avec près de 90 % de parts de marché, NVIDIA continue d’imposer son rythme à l’industrie des cartes graphiques. Si AMD progresse avec ses Radeon RX 9000, la force des GeForce RTX reste étroitement liée à l’écosystème logiciel, et notamment au DLSS. Mais la dernière évolution, DLSS 4.5, introduite au CES 2026, n’est pas sans […]

L’article DLSS 4.5 face à DLSS 4 : les RTX récentes encaissent bien, les anciennes beaucoup moins est apparu en premier sur HardwareCooking.

La vague rétro continue de déferler sur le marché du Mini-PC. Après un premier modèle inspiré de la Nintendo NES, ACEMAGIC pousse plus loin son concept en présentant au CES 2026 une nouvelle machine reprenant les lignes emblématiques de la première PlayStation. Un hommage assumé au design des années 90, combiné à une plateforme matérielle […]

L’article ACEMAGIC dévoile un Mini-PC au look de PlayStation 1, entre nostalgie et puissance moderne est apparu en premier sur HardwareCooking.