Les 23 meilleures applications iPhone pour gérer ses réseaux sociaux en 2026

En tête du marché des moniteurs OLED avec 21,9 % de parts, ASUS ne compte pas ralentir la cadence. Le constructeur multiplie les teasers et vient de dévoiler sur X une nouvelle vidéo préparant le terrain pour un futur écran ROG OLED en 2026.

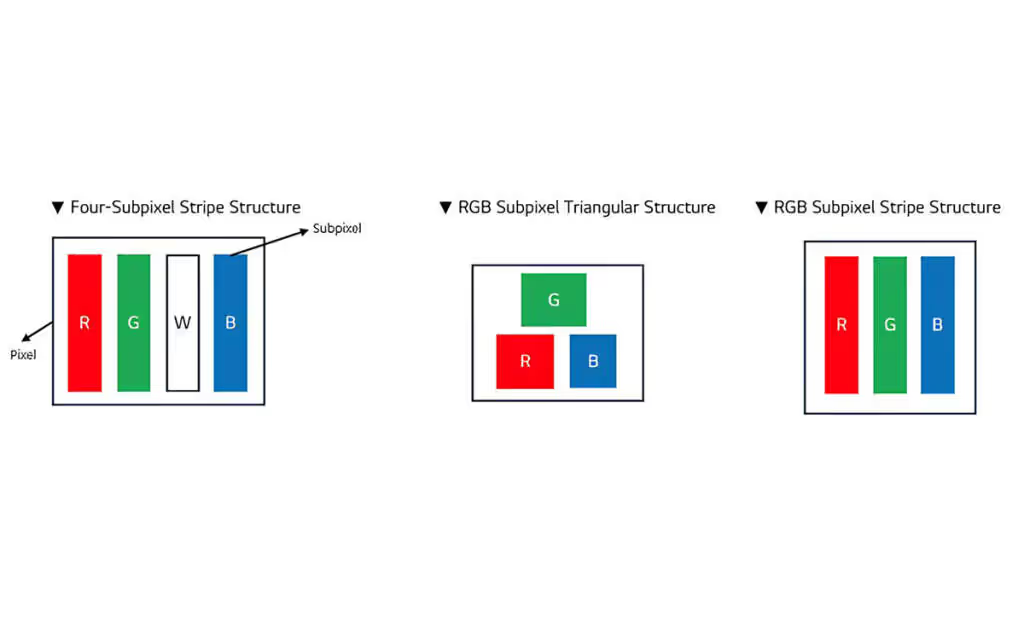

L’accent est mis sur une promesse claire : un affichage « zero fringing ». ASUS évoque explicitement l’adoption d’une structure de sous-pixels RGB stripe, dite linéaire, en opposition aux matrices Pentile encore largement utilisées sur les dalles OLED actuelles.

Le message diffusé par ASUS est sans ambiguïté sur l’intention : réduire les phénomènes de color fringing, ces franges colorées visibles autour des caractères et des éléments fins, particulièrement perceptibles en usage bureautique sur des écrans OLED Pentile. Cette communication s’inscrit dans le sillage des annonces récentes de LG Display, qui met en avant des dalles OLED PC reposant sur une véritable structure RGB stripe, réputée pour une meilleure restitution du texte.

A new era is loading…

— ROG Global (@ASUS_ROG) December 26, 2025

Perfect blacks. Zero fringing. No compromises.

See it first at #CES2026. Tag the friend who’s been waiting for the right #OLED#RGBOLED #ROGOLEDmonitor #PCmonitor #display pic.twitter.com/5HTv5whgou

LG Display a notamment évoqué une dalle 27 pouces 4K (3840 × 2160) à 240 Hz, conservant une organisation RGB linéaire des sous-pixels, tout en intégrant une fonction de Dynamic Frequency and Resolution (DFR). Ce mode permettrait de basculer entre un affichage UHD à 240 Hz et un mode FHD à 480 Hz, afin de privilégier soit la finesse d’image, soit la fréquence de rafraîchissement. Sur ce format, la densité annoncée atteint environ 160 pixels par pouce, un seuil élevé pour un écran OLED destiné à un usage PC rapproché.

À ce stade, ASUS ne communique ni référence produit, ni diagonale exacte, ni fiche technique détaillée. Toutefois, la proximité des éléments de langage laisse supposer que le constructeur pourrait s’appuyer sur un panneau aux caractéristiques proches de celles présentées par LG Display lors du prochain CES.

Selon LG Display, la structure RGB stripe améliore la netteté perçue du texte et limite les artefacts colorés, notamment dans les environnements Windows et les usages bureautiques prolongés. ASUS ROG reprend cette promesse avec l’expression « zero fringing », qu’il conviendra néanmoins de vérifier en conditions réelles, en l’absence de données techniques officielles et de mesures indépendantes.

La convergence des discours entre fabricant de dalles et marque gaming suggère toutefois une orientation claire du marché : proposer des écrans OLED PC plus polyvalents, capables de concilier haute définition, fréquences de rafraîchissement extrêmes et confort visuel sur le long terme.

Le CES 2026 se tiendra du 6 au 9 janvier à Las Vegas, et ASUS ROG a déjà confirmé une présence axée sur l’affichage, avec un espace presse dédié. C’est à cette occasion que ce moniteur OLED RGB stripe devrait, sauf surprise, être officiellement dévoilé.

Lire aussi ASUS ROG G1000 : un boîtier avec affichage LED « AniMe Holo » rotatif attendu au CES 2026

La nouvelle mise à jour 1.61 de HWMonitor passe presque inaperçue au premier regard. Pourtant, derrière cette révision logicielle se cache un indice particulièrement intéressant sur les prochaines générations de processeurs.

En élargissant sa prise en charge matérielle, l’outil de CPUID offre un aperçu très concret de ce que préparent AMD et Intel pour les mois à venir, notamment à l’approche de la période charnière 2025–2026. Comme souvent, ce type de mise à jour agit comme un révélateur discret, mais fiable, des architectures encore à venir.

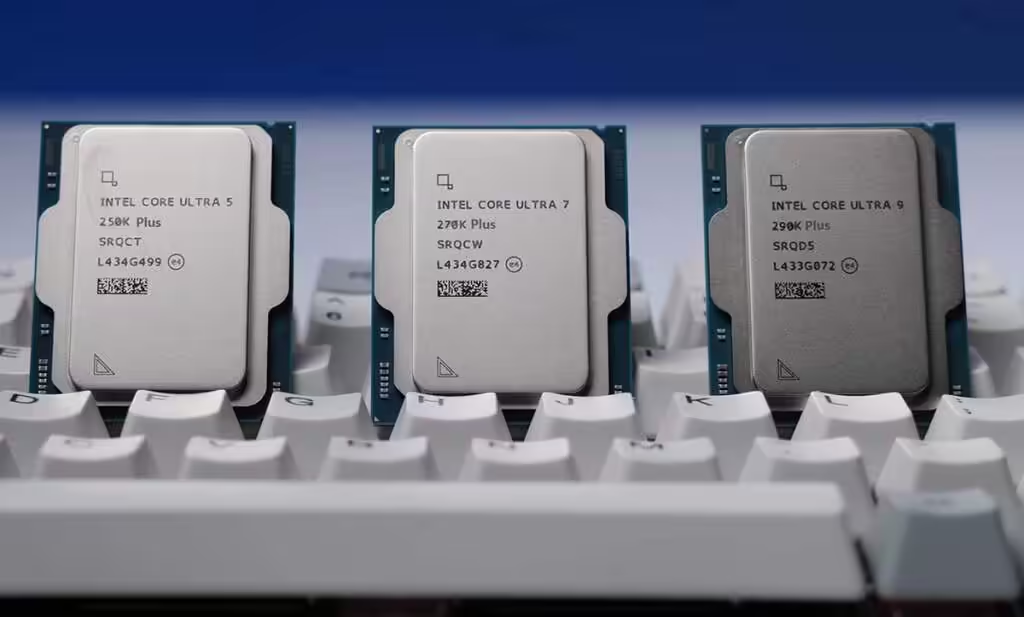

Avec cette version 1.61, HWMonitor prend désormais en charge plusieurs processeurs encore absents du marché. Côté Intel, on retrouve les futurs Arrow Lake Refresh »Core Ultra 200K Plus’‘, avec la prise en charge des Core Ultra 9 290K Plus, Core Ultra 7 270K Plus et Core Ultra 5 250K Plus. Une confirmation implicite qu’Intel prépare bien une itération intermédiaire de sa gamme Arrow Lake, probablement destinée à corriger certaines limites observées sur la première génération, notamment en matière de performances gaming et de latence interne.

Cette intégration anticipée n’est pas anodine. CPUID a pour habitude d’ajouter le support matériel plusieurs mois avant les annonces officielles, ce qui laisse entendre que ces processeurs sont déjà bien avancés sur le plan du microcode et des identifiants matériels.

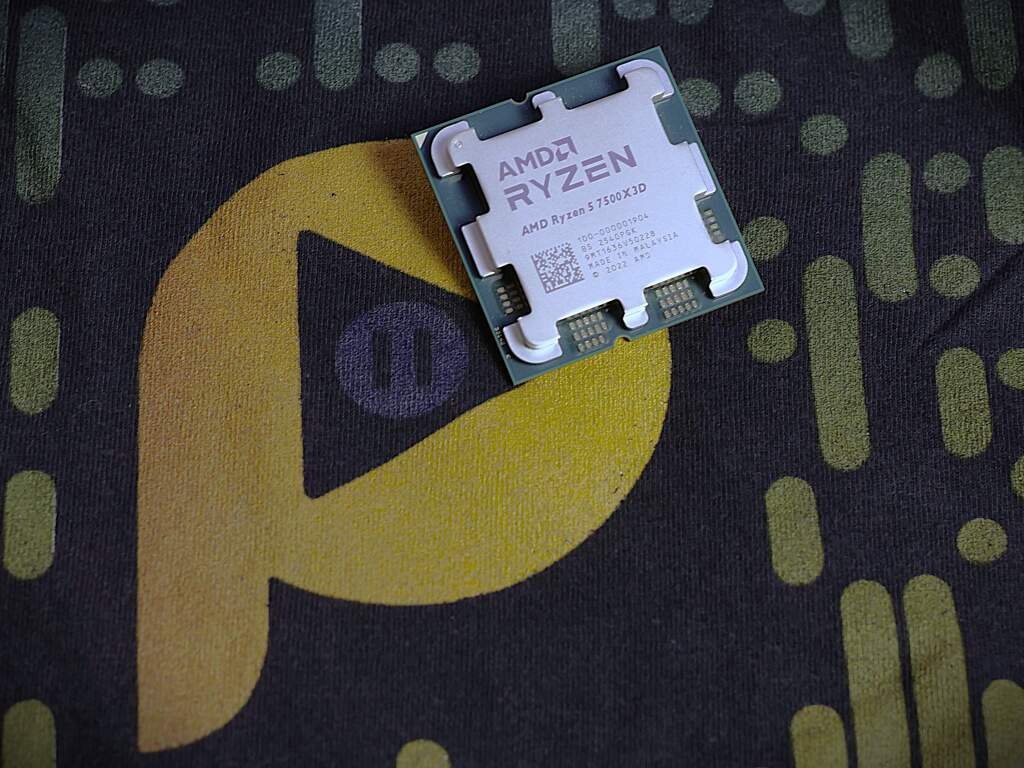

Du côté d’AMD, la mise à jour est tout aussi révélatrice. HWMonitor prend désormais en charge le Ryzen 5 7500X3D, un modèle Zen 4 à cache 3D pensé pour démocratiser la technologie X3D à un tarif plus accessible que nous avons déjà analysé à sa sortie le mois dernier. Une stratégie claire pour prolonger la durée de vie de l’AM5 tout en maintenant l’attrait du gaming chez AMD.

Mais l’information la plus intéressante concerne l’apparition du Ryzen 7 9850X3D, basé cette fois sur Zen 5. Celui-ci afficherait une fréquence boost supérieure de 400 MHz par rapport au 9800X3D, et sa sortie serait programmée pour le CES 2026. Une évolution qui confirme la volonté d’AMD de conserver une longueur d’avance sur les performances en jeu, là où le cache 3D reste un avantage décisif.

À noter toutefois l’absence du Ryzen 9 9950X3D dans la liste actuelle, suggérant soit un calendrier encore évolutif, soit une intégration progressive au fil des mises à jour.

Autre point notable : la présence du support préliminaire des processeurs mobiles Medusa Point, basés sur l’architecture Zen 6. Bien que leur lancement soit encore lointain, attendu courant 2026, leur apparition dans HWMonitor montre que les bases logicielles sont déjà en place.

Ces puces mobiles devraient inaugurer une nouvelle étape dans l’efficacité énergétique d’AMD, avec une architecture pensée dès le départ pour les usages hybrides, l’IA locale et les plateformes mobiles hautes performances. Leur ajout précoce dans les outils de monitoring va de pair avec leur intégration récente dans GCC 16, signe que l’écosystème logiciel se prépare activement.

Après les récentes fuites sur la microarchitecture Zen 6 et l’élargissement du cœur de calcul, cette prise en charge logicielle vient ajouter une pièce supplémentaire au puzzle. Sans annonce officielle, l’écosystème commence clairement à se préparer à l’arrivée de la prochaine génération de processeurs.

En apparence anodine, la mise à jour 1.61 de HWMonitor agit comme un véritable révélateur de feuille de route. En intégrant à l’avance Arrow Lake Refresh chez Intel, les Ryzen X3D récents et surtout les premières références Zen 6 mobiles, CPUID confirme que les fondations logicielles des CPU de 2025–2026 sont déjà solidement en place.

Entre le rafraîchissement d’Arrow Lake côté Intel, la montée en puissance continue des Ryzen X3D et l’arrivée progressive de Zen 6 chez AMD, le marché des processeurs entre dans une phase charnière. Desktop, mobile, gaming et IA locale convergent vers des architectures plus larges, mieux instrumentées et pensées pour durer. Sans communication officielle, l’écosystème logiciel parle déjà. Et il laisse peu de doute sur une chose : 2026 ne sera pas une année de transition, mais un vrai point d’inflexion pour les CPU x86.

L’ANTGAMER ANT275PQ MAX en ligne de mire : un écran capable de grimper à 1080 Hz, mais seulement en 720p. HKC détaille désormais un double mode qui oppose 1440p à 540 Hz et 720p à 1080 Hz.

D’après HKC, le ANTGAMER ANT275PQ MAX sera présenté au CES 2026 sous la marque ANTGAMER. Dans les documents de presse, il est décrit comme un écran LCD esports QHD intégrant une fonction double mode. La fiche signale un 27 pouces IPS en 2560 x 1440 avec technologie HMO (High Mobility Oxide), et prise en charge DisplayPort 2.1 UHBR20 pour viser des fréquences très élevées en QHD sans compression lourde.

Ce modèle avait émergé en août comme un 540 Hz en QHD. La nouveauté, c’est cette bascule : choisir le 1080 Hz abaisse la définition à 720p. HKC parle du « double-mode » qui permet cette option. Le tarif en Chine était affiché autour de 980 dollars, soit environ 895 euros au taux du jour.

Techniquement, l’ensemble intrigue et interroge les usages. Comme le rappelle la source, « vous pouvez vous vanter d’avoir le panneau le plus rapide », mais il semblerait que la compétition en 720p reste marginale. Reste un argument clair : à 540 Hz en 1440p via DP 2.1 UHBR20, l’écran vise les joueurs qui privilégient le taux de rafraîchissement sans sacrifier la définition QHD.

HKC prévoit une démonstration au CES 2026.

Source : VideoCardz

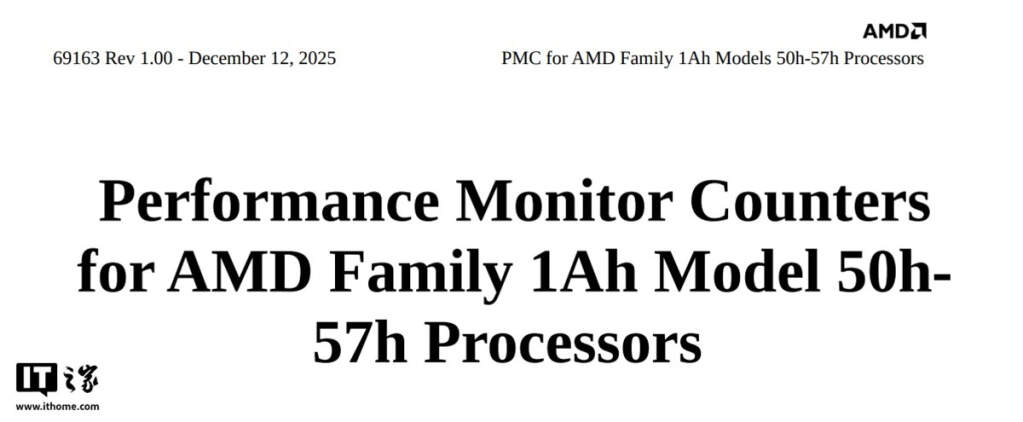

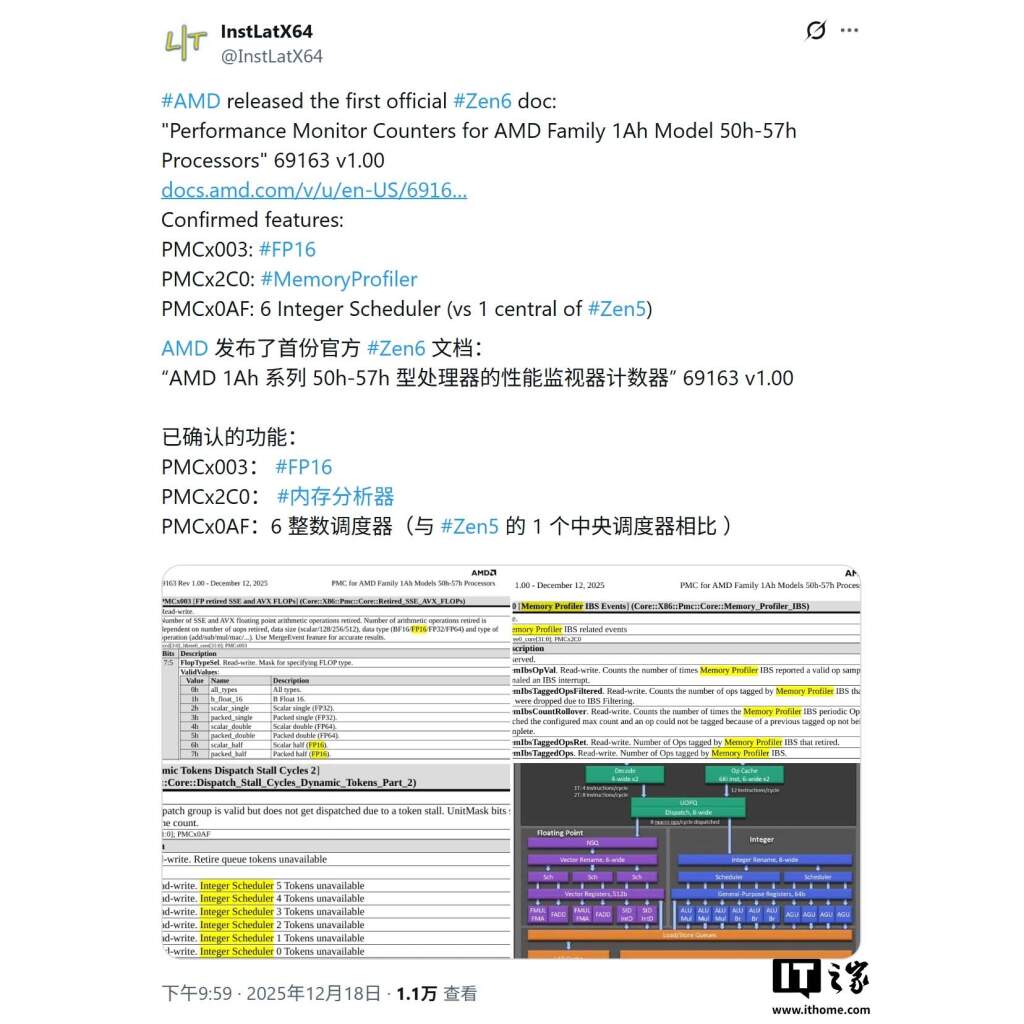

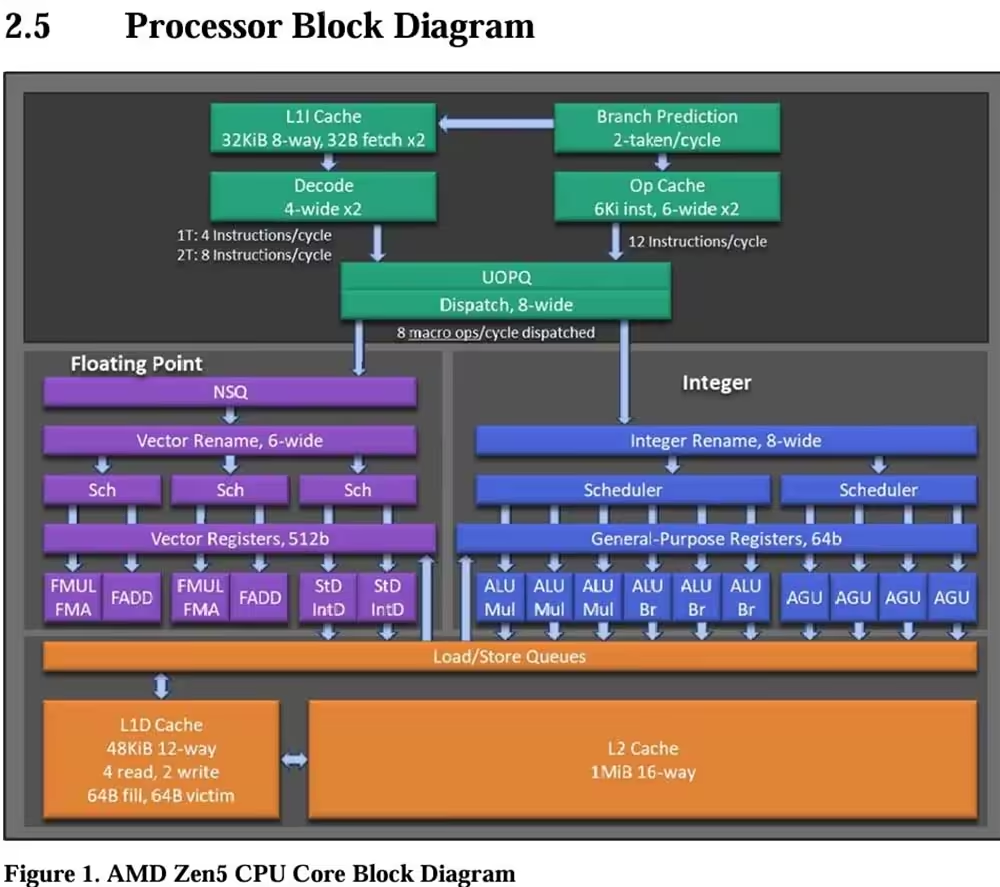

Alors que nous commençons à peine à apprivoiser Zen 5, une fuite d’ampleur vient déjà lever le voile sur la suite. Un document technique officiel d’AMD, destiné aux développeurs, détaille l’architecture Zen 6 et esquisse une évolution majeure : un moteur de calcul élargi à 8 slots, capable de redistribuer beaucoup plus d’instructions par cycle. De quoi redéfinir le niveau de performance attendu sur PC dans les années à venir, possiblement dès 2026.

Cette révélation s’inscrit dans un contexte plus large, alors qu’AMD a déjà confirmé Zen 6 en 2 nm tout en préparant Zen 7, laissant entrevoir une accélération nette de sa feuille de route CPU.

Une documentation technique officielle destinée aux développeurs, récemment repérée, offre un premier aperçu détaillé de la future microarchitecture. Derrière un titre austère et sans la moindre mention commerciale se cache pourtant un changement profond dans la façon dont les cœurs Zen traiteront les instructions.

Le document, référencé comme AMD Family 1Ah Model 50h–57h Processor Performance Monitoring Counters, décrit de nouveaux compteurs de performance internes. Leur existence permet, en creux, de reconstituer l’organisation du cœur Zen 6 et d’identifier plusieurs évolutions majeures, à commencer par un élargissement significatif du front-end.

La révélation la plus marquante concerne l’étage de dispatch. Zen 6 adopte une unité de distribution à 8 slots, contre 6 sur les générations Zen actuelles. Concrètement, cela signifie que le processeur pourra envoyer davantage d’instructions par cycle vers les unités d’exécution. Ce type d’évolution n’est jamais anodin : il implique une refonte en profondeur du pipeline, des buffers internes et de la gestion des dépendances.

Un dispatch plus large permet d’augmenter le débit d’instructions en conditions idéales, mais surtout de mieux exploiter les ressources lorsque le code présente suffisamment de parallélisme. Cette évolution fait écho à la refonte de l’interconnexion interne Sea-of-Wires, pensée pour réduire la latence et améliorer l’efficacité globale.

Avec 8 slots, Zen 6 se rapproche d’architectures historiquement plus agressives sur le plan du front-end. L’objectif n’est pas uniquement d’augmenter les performances maximales, mais aussi de réduire les phases de sous-utilisation des unités d’exécution. Moins de bulles dans le pipeline, c’est un meilleur rendement énergétique et un gain de performances plus régulier, y compris hors benchmarks synthétiques.

La documentation confirme également que Zen 6 conserve le SMT. AMD continue donc de faire confiance à cette approche pour améliorer l’occupation des ressources et les performances en multitâche. Rien d’étonnant à cela, mais le point intéressant se situe ailleurs : dans la finesse de l’observation.

Les nouveaux compteurs exposés permettent de suivre avec précision la manière dont les threads se partagent les ressources internes. Attentes dans le pipeline, conflits d’accès, saturation de certaines unités : tout devient mesurable. Cela donne aux développeurs des outils précieux pour comprendre où se situent les véritables goulots d’étranglement et adapter leurs optimisations à une architecture plus large et plus complexe.

Autre élément clé du document : la prise en charge d’instructions 512 bits. AMD renforce clairement les capacités vectorielles et en calcul flottant de Zen 6. Cette évolution aligne davantage l’architecture sur les besoins modernes en calcul scientifique, traitement multimédia et charges professionnelles intensives.

La présence d’instructions comme VNNI pour l’IA, ainsi que les extensions AES et SHA pour le chiffrement et le hashing, montre une orientation très nette. Zen 6 n’est pas seulement pensé pour le desktop grand public, mais pour des usages où le CPU reste central malgré la montée en puissance des accélérateurs dédiés.

À ce stade, aucun nom commercial, aucun calendrier et aucun benchmark ne figurent dans la documentation. Impossible donc de savoir quand Zen 6 arrivera sur le marché ou comment il sera décliné entre desktop, mobile et serveur. En revanche, les premières indications côté plateforme AM5 se veulent rassurantes.

Avec Zen 6, AMD semble préparer un véritable changement de rythme. Front-end élargi, calcul vectoriel renforcé, instrumentation plus fine du SMT : tout indique une architecture pensée pour durer et pour encaisser les charges de travail des prochaines années, notamment dans l’IA et le calcul intensif.

Ce premier aperçu ne dit pas tout, mais il suffit déjà à comprendre une chose : Zen 6 ne sera pas une simple itération. C’est une montée en gamme structurelle, et probablement l’une des évolutions les plus ambitieuses de l’architecture Zen depuis ses débuts.

DDR5 RDIMM en très haute capacité, mais à prix qui fait grimacer : NEMIX liste un kit 4 To à 70 800 dollars, soit environ 65 000 € au cours actuel. Un tarif de l’ordre de 17,3 dollars par Go, bien au-dessus des quelque 10 dollars/Go de la DRAM grand public.

Le kit réunit 16 barrettes de 256 Go au format ECC RDIMM, cadencées à 6400 MT/s avec une latence CAS de 52. NEMIX, fournisseur américain travaillant avec de grands groupes et des agences gouvernementales, cible sans détour les hyperscalers et stations de travail au budget musclé. Contexte aggravant : la pénurie de DRAM gonfle les prix, et ces modules embarquent des technologies que l’on ne trouve pas sur de la DDR5 standard.

Au-delà de l’ECC sur puce propre à la DDR5, ces RDIMM intègrent des circuits d’erreur dédiés hors-die, nécessaires pour une correction complète en environnement critique. La configuration 4Rx4 vise la régularité des performances, l’ensemble fonctionne à 1,1 V et profite du buffering enregistré avec ECC intégré. D’après la fiche, c’est précisément ce surcoût de silicium et de fonctions qui justifie un prix quasi doublé par rapport aux DIMM classiques. Comme le résume la source : « ces modules montrent pourquoi leur prix est bien plus élevé que les DIMM traditionnels », souligne TechPowerUp.

Le positionnement ne laisse guère de doute : IA à grande échelle, bases de données in-memory en téraoctets, clusters de virtualisation hébergeant des centaines de conteneurs. Selon NEMIX, ce type de kit s’adresse aux environnements « mission-critical » où densité mémoire et intégrité des données priment. Les hyperscalers obtiendront probablement des remises volumes, et dans un déploiement massif, 70 800 dollars ne représentent qu’une fraction du coût d’infrastructure.

Source : TechPowerUp

Lire aussi : Pénurie de DRAM : des retards de lancement se profilent chez les grands fabricants

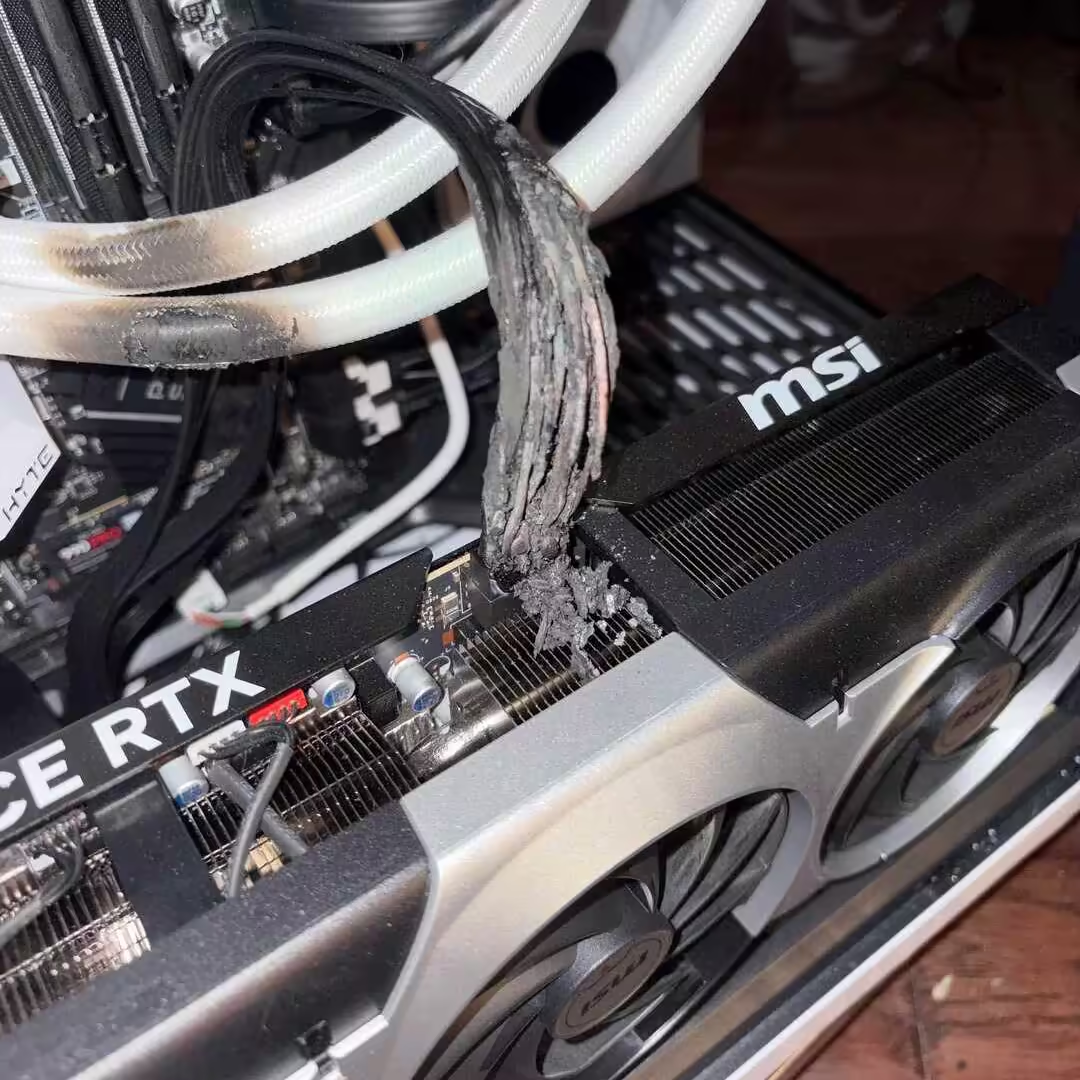

Comme si fondre n’était déjà pas assez problématique, le 12VHPWR semble désormais vouloir passer à l’étape supérieure. Odeur suspecte, puis flammes au connecteur : un propriétaire de RTX 5090 affirme que son câble 12VHPWR ne s’est pas contenté de chauffer, mais a littéralement pris feu. Le témoignage, publié sur Reddit, évoque une utilisation d’environ neuf mois avant l’incident, ajoutant une nouvelle couche d’inquiétude à un connecteur déjà largement surveillé par la communauté hardware.

Spoiler : l’alimentation en cause n’est ni un modèle haut de gamme ni une référence bien identifiée du marché. Il s’agirait d’une alimentation ATX 3.0 de marque inconnue, autrement dit une noname. Un détail loin d’être anodin lorsqu’on parle d’une RTX 5090 et d’un connecteur 12VHPWR déjà réputé pour ne pas pardonner la moindre approximation.

Le témoignage souligne un point de bascule par rapport aux cas classiques de surchauffe et de connecteurs ramollis : il s’agirait cette fois d’un départ de feu « dans la zone du connecteur », d’après l’auteur. Selon le post, le câble incriminé est un 12VHPWR fourni avec l’alimentation, utilisé exclusivement avec cette carte.

L’alimentation serait une Alimentation ATX PowerSpec 1050 W, certifiée 80 Plus Gold et entièrement modulaire et porte la mention ATX 3.0 et non ATX 3.1 avec le nouveau câble 12V-2×6. celle-ci est référencée chez Micro Center, avec l’ensemble des informations détaillées.

Le problème des câbles 12VHPWR a déjà été observé sur plusieurs générations, entre soucis d’ajustement et chaleur excessive. Ce signalement se démarque car il décrit un feu actif, et non un simple écran noir ou la découverte tardive d’un connecteur déformé. L’auteur dit avoir d’abord perçu une odeur étrange, puis aperçu des flammes au niveau de la prise.

De notre point de vue, la meilleure option reste l’utilisation d’une alimentation ATX 3.1 de qualité, issue d’un fabricant reconnu, plutôt que d’un modèle générique sans pedigree, a fortiori avec une GeForce RTX 5090. Le standard 12V-2×6 apporte en outre des améliorations concrètes sur la conception et la fiabilité des connecteurs, ce qui renforce la sécurité dans ce type de configuration très exigeante.

Lire aussi : Meilleures alimentations ATX 3.1 pour la RTX 5090 : Fais pas cramer ta config !

Source : Reddit

Merci à vous de suivre le flux Rss de www.sospc.name.

Nous avons l’habitude de prévisualiser nos fichiers avec l’explorateur Windows. Au travail je cherche beaucoup car j’ai une tonne de fichiers de toutes sortes.

Si par exemple vous double-cliquez sur un MP3 alors c’est votre lecteur média par défaut qui s’ouvrira, si c’est un PDF ce sera sûrement Adobe PDF qui s’ouvrira et il est « lourd » sur certains PC, etc. Personnellement je gagne du temps en prévisualisant tous mes fichiers, quels qu’ils soient.

C’est ce que je vous propose ici, un petit soft qui vous permet cette prévisualisation, que ce soit un MP3, une photo, une vidéo, un Gif, .doc, etc.

QuickLook supporte une palanquée de formats sans les ouvrir dans leurs applis respectives.

Cela me fait gagner du temps car j’ai vraiment beaucoup de docs en tous genres que je consulte tous les jours au boulot et nul besoin d’ouvrir Adobe ni Office pour cette visualisation, c’est vrai aussi que je peux être un peu bordélique ;-) idem pour la musique et mes vidéos.

***

Note de l'administrateur

Charly vous a proposé ce programme en version 3 au mois de décembre 2023, une version 4 étant désormais disponible je vous la propose.

Je publie à nouveau son tutoriel d'alors.

***

Cet article Prévisualisez plus facilement vos fichiers (v4.3), par Charly est apparu en premier sur votre site préféré www.sospc.name

Si vous avez toujours voulu essayer Emacs mais que la courbe d'apprentissage vous fait peur, IDEmacs est fait pour vous ! Ce projet transforme Emacs en clone de VSCode avec les mêmes raccourcis clavier, la même interface graphique et les mêmes fonctionnalités out-of-the-box, comme ça vous n'avez plus besoin de vous taper une configuration durant trois jours avant de pouvoir écrire une ligne de code !

Cool, hein ?

L'idée c'est donc de permettre aux développeurs habitués à des IDE modernes de passer à Emacs sans devoir réapprendre tous leurs réflexes. Les raccourcis clavier reprennent ceux de VSCode comme Ctrl+C pour copier, Ctrl+V pour coller, Ctrl+F pour chercher. C'est basique mais indispensable quand vous venez d'un autre éditeur.

Côté interface, IDEmacs intègre Treemacs pour avoir un explorateur de fichiers dans la sidebar comme sur VSCode. Y'a aussi Centaur Tabs pour les onglets, un thème Dark Plus qui ressemble à celui de Microsoft, et le support des curseurs multiples. Bref, visuellement vous êtes en terrain connu.

Du coup, c'est pour qui exactement ?

Hé bien le projet cible trois types d'utilisateurs : les développeurs qui veulent migrer vers Emacs depuis un autre IDE, les débutants en Lisp ou Scheme qui ont besoin d'Emacs pour bosser, et les non-programmeurs qui cherchent juste un éditeur de texte puissant sans se prendre la tête avec la config.

D'ailleurs, contrairement à la plupart des starter kits Emacs, IDEmacs ne cache pas les éléments graphiques par défaut. Les menus, barres d'outils et scrollbars sont visibles donc vous pouvez configurer le tout via l'interface graphique plutôt qu'en écrivant du Elisp à la main.

La config proposée inclut une vingtaine de packages tels que Vertico, Consult et Marginalia pour l'autocomplétion, Magit pour le contrôle de version, Sly et Geiser pour le développement Lisp et Scheme, plus des outils comme expand-region, multiple-cursors et smartparens pour l'édition avancée.

Pour installer IDEmacs, il vous faudra donc Emacs 29 ou plus récent, git, et optionnellement grep et locate. Clonez le repo puis lancez Emacs avec

emacs --init-directory=/path/to/IDEmacs/vscode .

Et hop, c'est prêt !

IDEmacs reste une porte d'entrée vers Emacs, et pas un remplacement définitif de VSCode mais l'idée avec ce truc, c'est de vous permettre de commencer à utiliser Emacs sans friction, puis de personnaliser au fur et à mesure que vous comprenez comment ça marche. Je vous assure que vous allez probablement vouloir modifier des trucs une fois que vous serez à l'aise.

Voilà, si vous avez toujours été curieux d'Emacs mais que vous n'avez jamais osé franchir le pas, c'est l'occaz !

Vous avez une vieille GTX 1060 qui tourne nickel sous Arch Linux ? C'est con, NVIDIA vient de vous mettre un beau coup de pied aux fesses car la boîte au caméléon vert a décidé d'abandonner le support des GPU Pascal (les GTX 10xx) dans son dernier driver 590 et ça crée un joyeux bordel, notamment sur Arch.

Le problème, c'est que quand vous faites une mise à jour système sur Arch avec une vieille carte Pascal ou Maxwell, le nouveau driver refuse de charger. Résultat, vous vous retrouvez éjecté vers la ligne de commande sans interface graphique. Sympa pour débugger quand y'a plus d'écran qui fonctionne...

Faut dire que le modèle "rolling release" d'Arch fait que les utilisateurs ont reçu ce driver incompatible automatiquement avec leur mise à jour. Ils n'ont pas eu le temps de dire ouf que leur système était déjà cassé. Et les GTX 1060 et 1050 Ti, c'est pas exactement des cartes de musée... Y'en a encore pas mal qui tournent sur Steam, et même si parmi leurs propriétaires, seule une poignée utilise Linux, et encore moins Arch, ça fait quand même du monde impacté.

Pour s'en sortir, y'a deux solutions. La première, c'est d'installer le driver legacy nvidia-580xx-dkms depuis l'AUR, qui est maintenu par l'équipe CachyOS. Le hic, c'est que ça crée des problèmes de dépendances avec Steam, donc faut aussi installer lib32-nvidia-580xx-utils pour que les jeux 32 bits fonctionnent. La deuxième option, c'est de basculer sur Nouveau, le driver open source fait par reverse engineering. Ça marche, mais avec les limitations que ça implique niveau performances et fonctionnalités.

Ce qui me rend dingue dans cette histoire, c'est que pendant des années, NVIDIA a refusé de fournir de la documentation pour ses GPU, forçant la communauté Linux à utiliser le reverse engineering pour Nouveau. Et depuis 2022, ils ont ouvert les modules kernel pour les architectures Turing et plus récentes, mais les parties user-space et le firmware restent propriétaires. Et surtout, aucune aide pour les vieilles cartes comme Pascal !! Du coup, maintenant que NVIDIA abandonne ces générations de cartes, c'est aux bénévoles de la communauté de maintenir les drivers legacy... Pas cool.

D'ailleurs, l'annonce officielle d'Arch Linux précise que les cartes Turing et plus récentes (RTX 20xx et GTX 1650+) vont automatiquement basculer vers les modules kernel open source, donc pas d'intervention manuelle pour eux. C'est uniquement les propriétaires de vieilles Pascal/Maxwell qui doivent se taper le boulot.

Bref, si vous avez une carte Pascal sous Arch, basculez sur nvidia-580xx-dkms avant votre prochain pacman -Syu. Dans sa grande bonté, NVIDIA a aussi promis des patchs de sécu jusqu'en 2028, mais bon, on a vu ce que valent leurs promesses côté Linux...

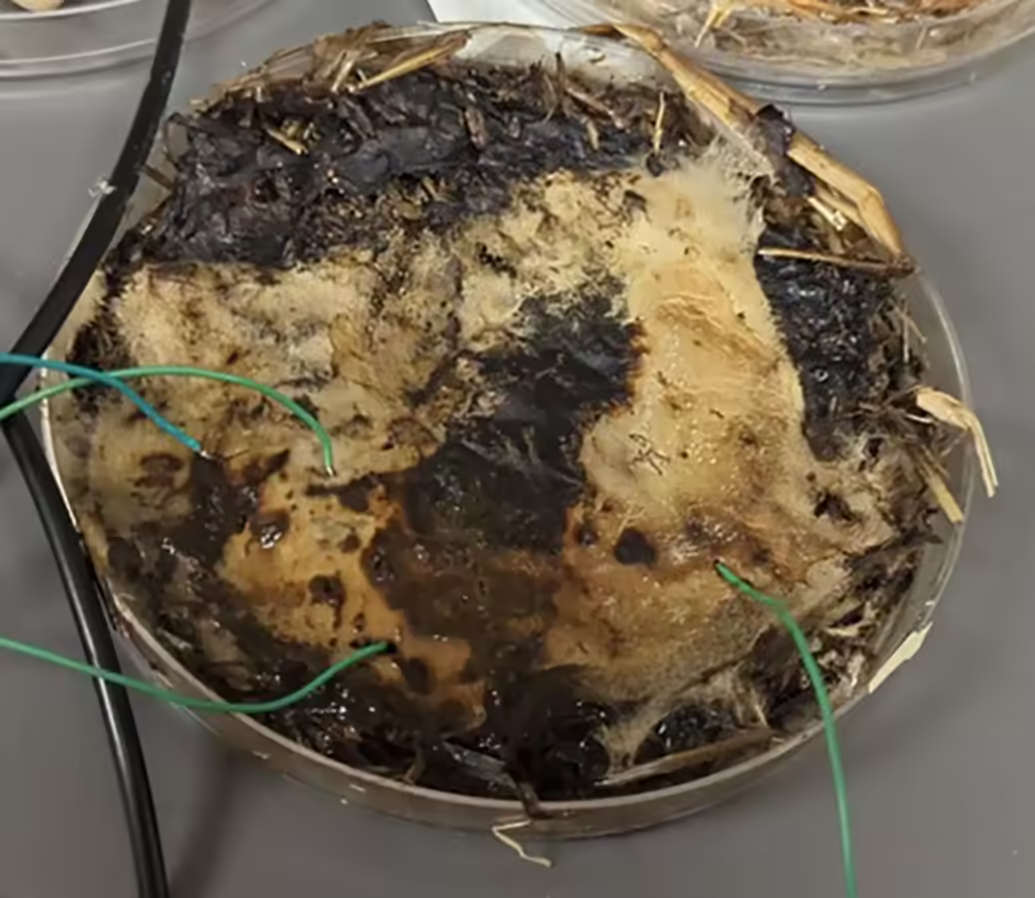

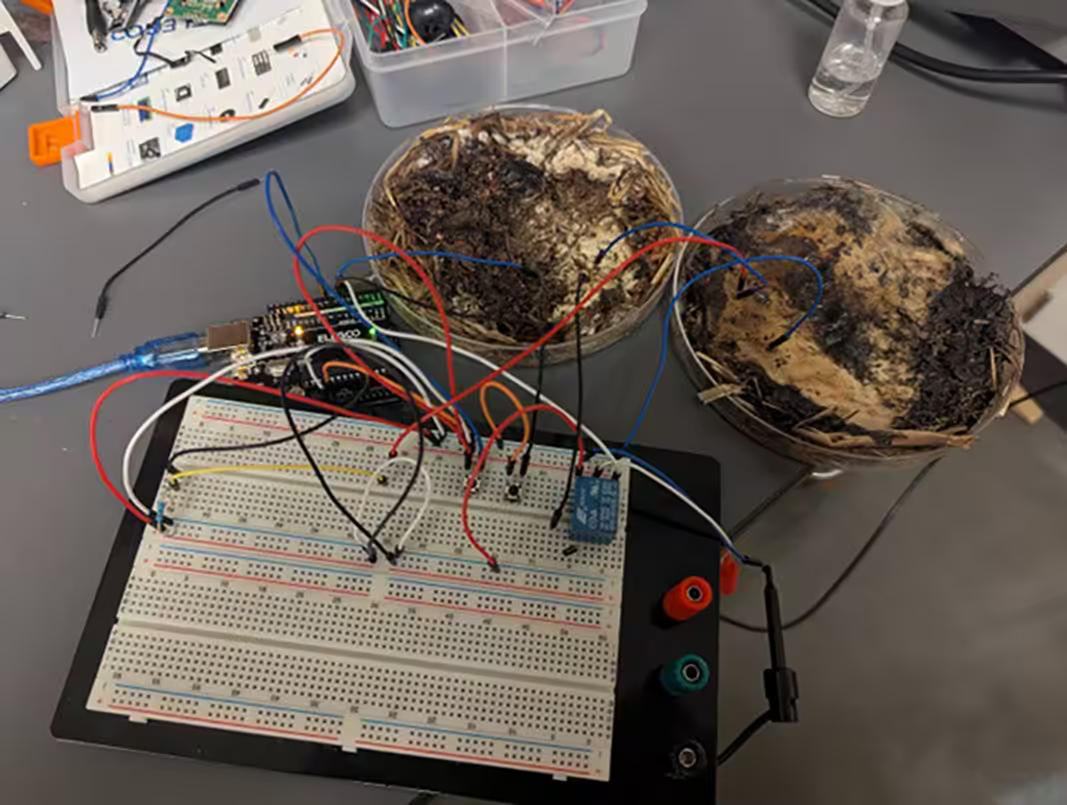

DRAM hors de prix, pénurie à l’horizon… et voilà que la mémoire dans les champignons devient soudain une piste crédible. On croyait le champignon cantonné à l’omelette ou à la forêt de Rambouillet, mais des chercheurs de l’Ohio State University viennent de lui trouver une nouvelle vocation. Du mycélium de shiitake et de champignon de Paris a été transformé en memristors organiques, capables de conserver une information électrique…Même le champignon de Paris a fait ses calculs : avec le prix de la DRAM, c’est plus rentable de bosser dans la RAM que de finir émincé dans une poêle.

L’équipe a cultivé le mycélium, l’a déshydraté plusieurs jours, puis a fixé des électrodes avant d’appliquer une brumisation légère pour rétablir la conductivité. Objectif : faire circuler des formes d’onde et tensions variées pour observer une résistance à état dépendant de l’historique, signature d’un memristor. D’après les résultats, le comportement le plus cohérent apparaît autour de 1 volt. Les chercheurs ont aussi poussé l’expérience vers une approche type RAM, en atteignant près de 6 kHz avec environ 90 % d’exactitude.

Pas de miracle côté capacité : impossible de stocker des gigaoctets sans un champ de champignons. La rétention de type memristor ne suffit pas à elle seule. Il faut une densité exploitable, des interfaces, de la stabilité et une voie de mise à l’échelle vers de vrais modules. Comme le résume la source, « vous ne pouvez pas stocker des gigaoctets ainsi, sauf avec des hectares de champignons ».

Selon Hackaday et les journaux Plos, ce n’est pas un remède à la hausse des prix de la DRAM, mais un jalon intrigant pour une électronique bio-inspirée à très bas coût. Si les acteurs de l’IA cherchent des supports mémoire alternatifs, le mycélium pourrait servir de banc d’essai, à condition de régler la capacité, la reproductibilité et l’intégration matérielle.

Source: Hackaday, Journals Plos

Vous vous souvenez des disquettes 3,5 pouces ? Ces petits carrés en plastique qu'on utilisait pour stocker nos 1,44 Mo de données précieuses ? Hé bien à Taïwan, elles font leur grand retour... mais pas pour sauvegarder vos fichiers.

La société iPASS, qui gère un système de cartes de transport et de paiement sans contact dans le pays, vient de lancer une carte prépayée NFC en forme de disquette. Taille réelle, proportions parfaites, disponible en noir ou en jaune. C'est sorti pour Noël et les geeks du pays se sont jetés dessus.

Le truc qui m'a fait triper surtout, c'est l'avertissement officiel que la boîte a jugé nécessaire d'ajouter sur la fiche produit : "Ce produit a uniquement une fonction de carte et n'a pas de fonction disque 3,5mm, veuillez en prendre note avant l'achat". J'imagine qu'ils ont dû voir passer quelques retours de clients déçus qui tentaient de l'insérer dans leur vieux PC... Même si après, trouver un PC avec un lecteur de disquette en 2025, c'est déjà un exploit en soi.

Du coup cette carte permet de prendre le métro, le bus, le train, le taxi, de louer un vélo, et de payer dans les 7-Eleven, FamilyMart, McDonald's, Burger King et plein d'autres enseignes. Bref, c'est une vraie carte de paiement, juste avec un look de rêve pour les nostalgiques de l'ère DOS.

Et si vous pensez que c'est le gadget le plus absurde qu'ils ont sorti, détrompez-vous puisque iPASS propose aussi des cartes en forme de téléphone Motorola DynaTAC (le gros portable des années 80), de train miniature, de tong, et même de boule à neige Godzilla avec des LEDs. Sur le site PCHome24, y'a littéralement 838 designs différents de cartes iPASS. Les Taïwanais, ils font pas les choses à moitié.

Une carte standard coûte environ 100 NT$ (3 euros) sans crédit, mais les éditions collectors peuvent monter jusqu'à 1000 NT$ ou plus selon le délire. Voilà, si vous passez par Taïwan, c'est clairement le souvenir geek ultime à (me) ramener !

Et au moins, contrairement à une vraie disquette, celle-là ne risque pas de vous lâcher après 6 mois à cause d'un petit champ magnétique de passage.

Vous voyez ces photos stylées sur Instagram où le texte semble passer derrière la personne, comme si le gros "FASHION" ou "WORKOUT" était vraiment dans la scène ? C'est l'effet "text behind image" et c'est clairement le truc graphique qui fait super pro en ce moment.

Le problème c'est que pour obtenir ce rendu, faut normalement se taper Photoshop, maîtriser les calques, le détourage, les masques... Bref, perdre une demi-heure sur un truc qui devrait prendre 30 secondes. Et comme vous êtes des gens occupés (contrairement à moi qui passe ma vie à tester des outils), voici la solution.

C'est un site gratuit qui règle tout ça et qui s'appelle Text Behind Image . Vous uploadez votre photo (jusqu'à 10 Mo), l'IA détecte automatiquement le sujet (une personne, un objet, peu importe), vous tapez votre texte, et le site se débrouille pour le placer pile poil derrière. Ça prend quelques secondes de traitement, pas besoin de détourer quoi que ce soit vous-mêmes.

L'interface propose pas mal d'options de personnalisation... Vous pouvez choisir la police, jouer avec la taille, la couleur, l'opacité, la rotation, ajouter des contours... Et surtout, vous voyez le résultat en temps réel, donc vous pouvez repositionner le texte en glisser-déposer jusqu'à ce que ça rende nickel.

Et le top du top, c'est que c'est gratuit, sans limite, sans inscription, et vous téléchargez votre image en haute résolution sans filigrane. J'ai vérifié et y'a même pas de petit "Made with..." planqué dans un coin. C'est assez rare pour un outil en ligne de ce genre alors je tiens à vous le signaler !

Bon après si votre photo est ultra complexe avec 36 personnes et des éléments qui se chevauchent, l'IA va potentiellement galérer à détourer correctement, mais pour une photo classique avec un sujet bien visible sur un fond pas trop chargé, ça marche vraiment bien.

Bref, si vous faites du contenu pour les réseaux, des miniatures YouTube, ou même juste des visuels fun pour votre pote qui fait de la muscu, c'est le genre d'outil à bookmarker direct. En 30 secondes vous aurez un rendu qui vous aurait pris 20 minutes sur Photoshop.

Des ateliers chinois multiplient les upgrades vers RTX 5080 32 GB. Le mod double la VRAM par rapport aux 16 GB d’origine et, d’après un technicien, la demande pourrait détourner des cartes du circuit gaming traditionnel.

Selon Zhiqiang Graphics Card Studio, ces modifications vers 32 GB deviennent régulières. Le technicien cite des builds « Turbo » comme moteur de la tendance, un terme utilisé pour désigner les modèles à turbine expulsant l’air par l’arrière, plus simples à empiler dans des boîtiers IA et stations de travail denses. Il anticipe davantage de conversions à mesure que les ateliers maîtrisent la procédure et que les acheteurs réclament plus de VRAM dans un format compact adapté aux serveurs.

a gpu repair technician in china claimed 5080 32g has already been a thing.

— UNIKO's Hardware

"""

目前5080呢

已經是可以成功改32G了

改32G渦輪

所以後期的拆芯片改渦輪呢

應該是還是會很多的

所以我感覺5080的價格有可能會起飛

"""

bilibili 智强显卡工作室https://t.co/X9ygzxd523 pic.twitter.com/Y6TGUbbsvo(@unikoshardware) December 26, 2025

Ce canal alternatif n’est pas inédit : on a déjà observé des reworks à grande échelle de GeForce RTX 5090 en cartes IA à turbine, ainsi que des upgrades mémoire de GeForce RTX 4090 bien au-delà des spécifications d’origine. Certains moddeurs évoquent « des outils personnalisés » et des documents apparus après l’incident de piratage de 2022 comme facteurs ayant facilité la réplication à grande échelle.

NVIDIA préparerait une GeForce RTX 5080 SUPER avec 24 GB de mémoire via des modules GDDR7 de 3 GB, mais le calendrier se serait décalé vers la fin du premier trimestre ou le début du deuxième trimestre 2026, soit entre mars et mai 2026. Même sur cette fenêtre, la capacité resterait sous les 32 GB visés par ces cartes custom modifiées.

Le technicien prévient que l’attrait pour les « Turbo » et les 32 GB pourrait drainer davantage d’unités retail vers les ateliers de rework : « la demande de conversions pourrait retirer des cartes du canal gaming ».

Source: Zhiqiang Graphics Card Studio

Vous vous êtes déjà demandé si ChatGPT votait à gauche ou à droite ? Moi non plus, j'avoue. Mais maintenant qu'on a la réponse, c'est quand même assez marrant, vous allez voir...

Un développeur a créé PoliBench , un site qui fait passer le test du Political Compass à 40 modèles de langage différents. Le Political Compass c'est ce fameux test avec les deux axes : économique (gauche-droite) et social (libertaire-autoritaire). Le truc qu'on faisait tous sur Internet en 2005 pour finalement découvrir qu'on était un libertaire de gauche comme environ 95% des gens qui passaient le test.

Bref, maintenant les IA aussi peuvent savoir où elles se situent sur l'échiquier politique et ça, ça peut vous aider à mieux les choisir, car les résultats sont assez révélateurs. Niveau cuisine interne, PoliBench teste les 62 questions sur les deux axes du Political Compass, puis calcule les scores pour chaque LLM. Et comme les données sont open source, vous pouvez vérifier la méthodologie vous-même.

Et sans surprise, la plupart des LLMs se retrouvent dans le quadrant libertaire de gauche !! J'dis ça, j'dis rien, mais c'est presque comme si les devs de la Silicon Valley avaient des opinions politiques similaires et les injectaient (consciemment ou pas) dans leurs modèles.

Du coup, j'ai fait le travail de tri pour vous, alors voici le guide ultime pour choisir votre IA selon votre sensibilité politique :

Si vous êtes plutôt LFI, prenez Claude. Il est tellement progressiste qu'il refuse de générer du contenu problématique même quand vous lui demandez une blague sur les vegans. En plus il écrit des pavés de 3000 mots pour expliquer pourquoi il ne peut pas répondre à votre question. Parfait pour tenir un meeting politique de 4 heures.

Si vous êtes plutôt PS, prenez GPT-4. Un modèle qui a connu des jours meilleurs, qui essaie de plaire à tout le monde et qui finit par ne satisfaire personne. Bonus : il change d'avis selon qui lui parle.

Si vous êtes plutôt macroniste, prenez Gemini de Google. Un truc qui promet la disruption et l'innovation mais qui au final fait à peu près pareil que les autres, en plus cher, tout en vous expliquant que c'est pour votre bien.

Si vous êtes plutôt LR, prenez Mistral. C'est français, c'est souverain... mais personne ne sait vraiment ce que ça pense sur les sujets qui fâchent parce que ça évite soigneusement d'en parler.

Si vous êtes plutôt écolo, prenez Llama de Meta. C'est open source donc c'est « pour le bien commun », ça tourne sur du matériel recyclé si vous voulez, et ça consomme moins de ressources que les gros modèles propriétaires. Par contre faut quand même un GPU qui coûte un SMIC.

Et si vous êtes plutôt RN... bah en fait y'a pas vraiment de LLM pour vous. Tous ces modèles ont été entraînés à San Francisco par des gens qui mangent des avocado toasts et font du yoga. Ils refusent donc de générer ce contenu haineux, discriminatoire ou factuellement faux dont vous êtes friants. Désolé, les gars c'est pas compatible. Peut-être essayez Grok d'Elon Musk ? Ah non pardon, lui aussi il a des « guidelines ». Mince alors. Va falloir donc continuer à écrire vos tracts vous-mêmes les amis. Je sais, l'IA woke vous opprime, c'est terrible.

Après, le vrai sujet derrière PoliBench, c'est que ces biais existent bel et bien et qu'ils influencent les réponses que vous recevez sur des sujets sensibles. Quand vous demandez à une IA son avis sur l'immigration, les impôts ou la régulation des entreprises, la réponse dépend en partie de ces préférences encodées dans le modèle. Il faut juste le savoir...

Alors vous choisissez quelle IA à partir de maintenant ?

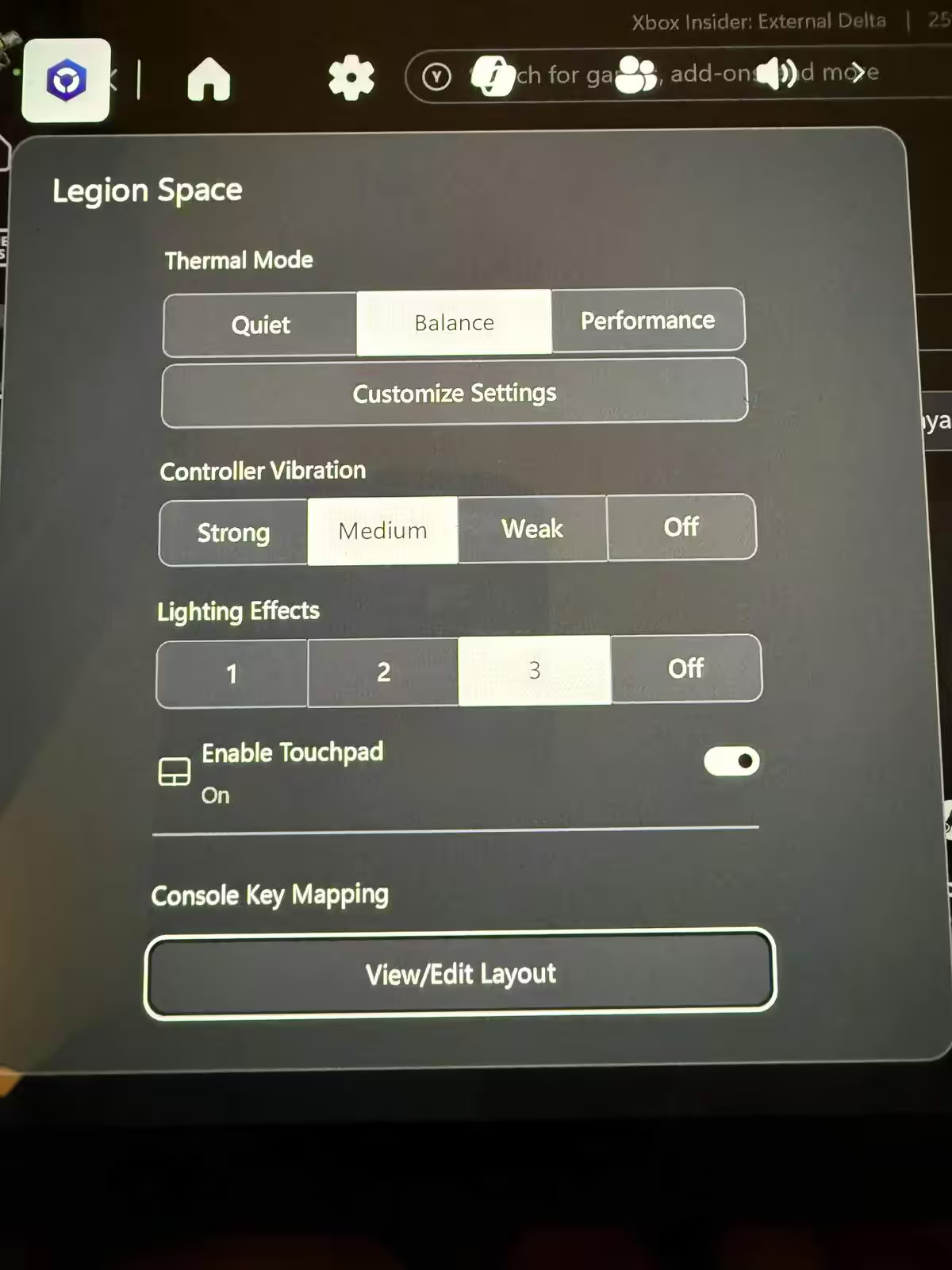

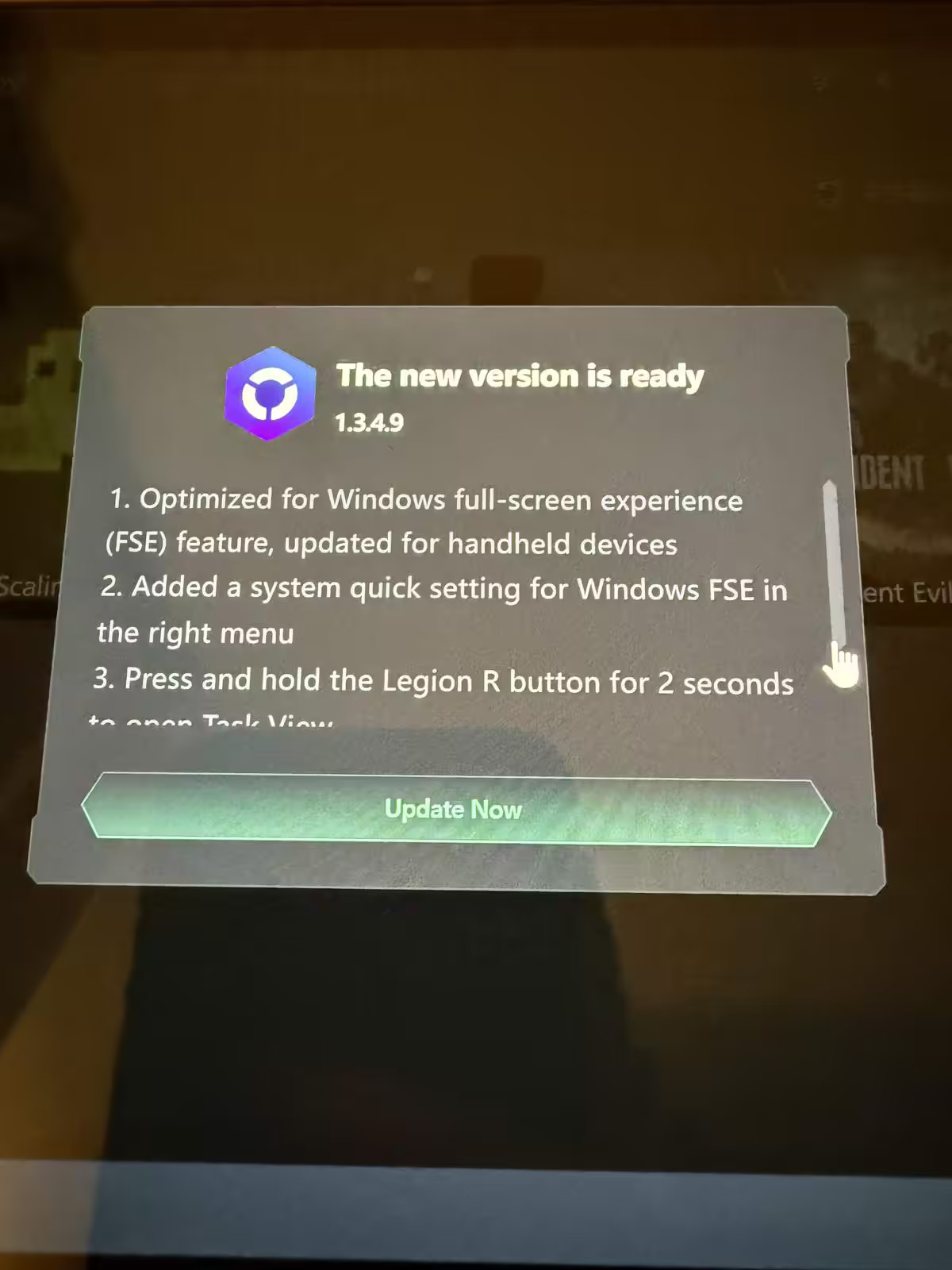

Xbox Full Screen arrive sur les consoles PC de Lenovo. La mise à jour Legion Space 1.3.4.9 ajoute la compatibilité Windows Full Screen Experience (FSE) et revoit plusieurs raccourcis sur les Legion Go.

Le support FSE est l’ajout phare, mais il n’est pas activé par défaut. Il faut d’abord l’allumer dans Windows, puis Legion Space propose un raccourci Toggle FSE qui réplique Win+F11 et une entrée dédiée dans les Paramètres rapides pour accompagner le nouveau flux plein écran.

Lenovo remappe aussi les commandes : un appui long sur Legion R déclenche l’équivalent de Win+Tab (Vue des tâches), tandis qu’un appui court ouvre le widget OEM Legion Space. Une notification signale la disponibilité du FSE, avec option pour la désactiver ensuite. D’après Lenovo, « les téléchargements d’update sont plus rapides », de quoi réduire l’attente à chaque nouveau build.

Côté système, Legion Space définit la clé registre Device Form sur « Handheld », installe l’app Legion Space widget et la place en tête de la liste OEM Game Bar. Le déploiement se fait par vagues : il semblerait que tous les utilisateurs ne voient pas encore la version 1.3.4.9.

La version 1.3.4.9 cible les Legion Go (8APU1), Legion Go S (8ARP1 et 8APU1), ainsi que les deux variantes Legion Go 2 (8AHP2 et 8ASP2). Selon les retours, la diffusion progresse graduellement ; laissez un peu de temps si la mise à jour n’apparaît pas encore.

Source: Lenovo, Reddit/Danzavier

Intel a longtemps régné sans partage sur le marché des processeurs, avant que l’arrivée des architectures Zen d’AMD ne bouleverse durablement l’équilibre des forces. Contraint de réagir, le fondeur américain a multiplié les cœurs et les fréquences pour rester compétitif, jusqu’à atteindre une limite technique évidente avec les Core de 13e et 14e génération, marquées […]

L’article Intel Nova Lake promet +15 % d’IPC, mais à un prix record pouvant atteindre 1 500 euros est apparu en premier sur HardwareCooking.