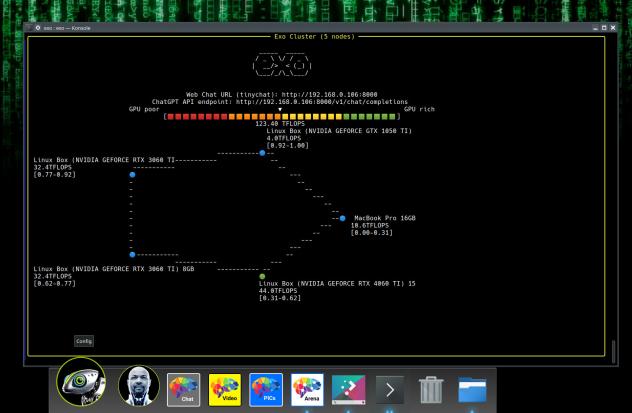

exo : exécuter un cluster IA sur vos machines locales

exo est un projet open source développé par exo labs. L'objectif est de faire fonctionner votre cluster IA chez vous sur vos terminaux disponibles. exo veut exploiter la puissance GPU de vos iPhone, Android, Mac, cartes NVIDIA, Raspberry Pi, etc. Bref, tout ce qui peut faire tourner les modèles et les couches applicatives. Il faut pouvoir installer exo sur chaque machine.

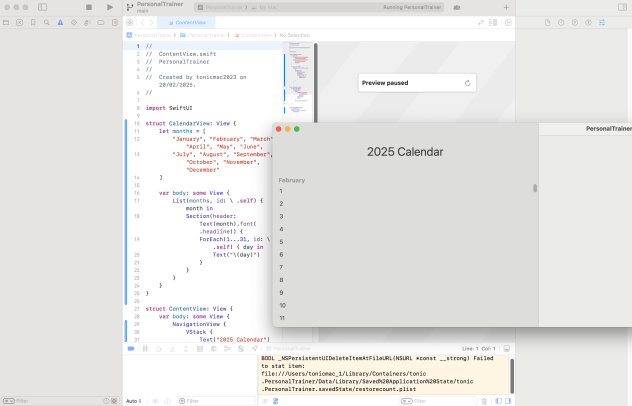

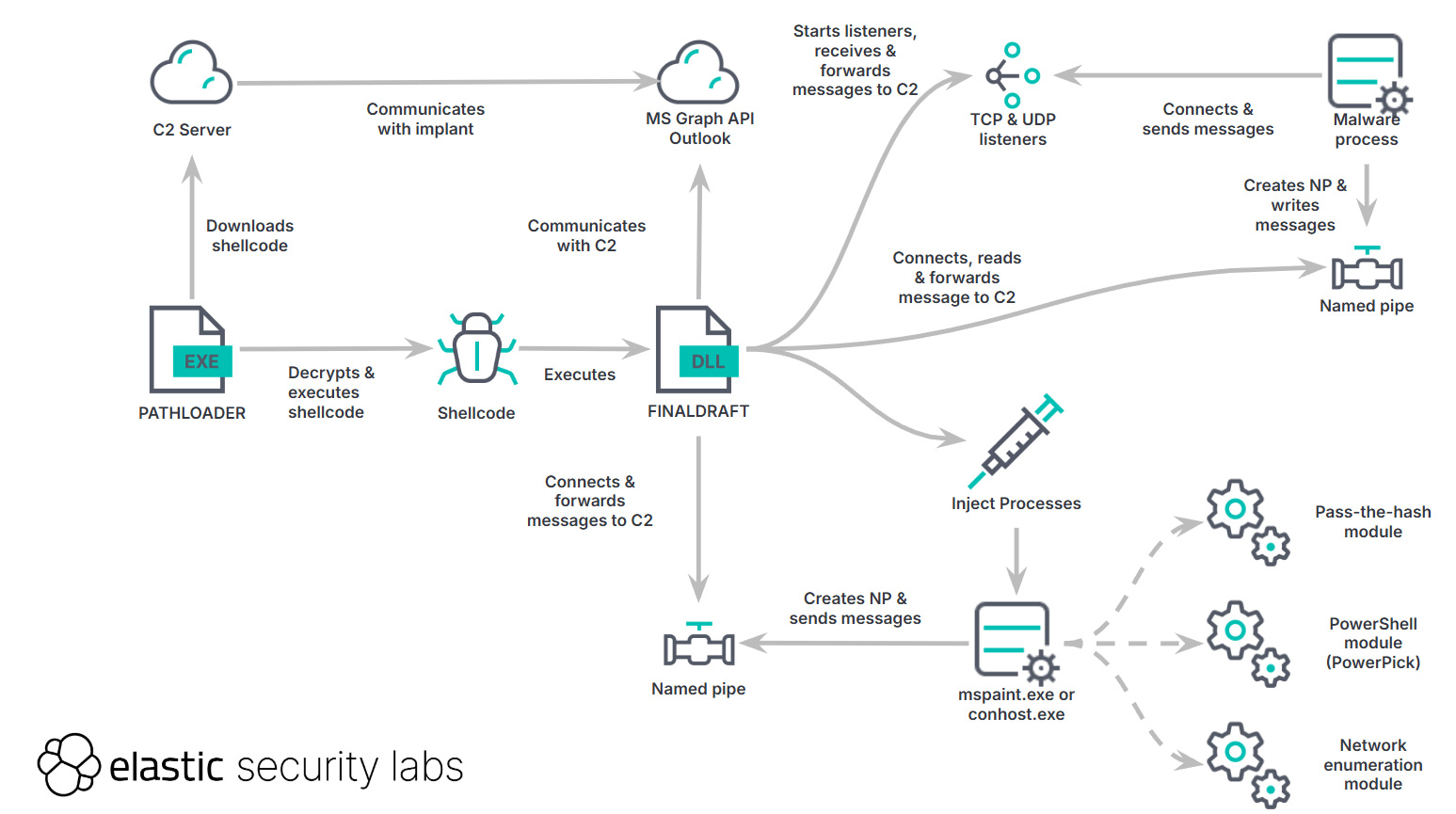

Actuellement, exo est expérimental, incomplet et instable. Il supporte LLaMA, Mistal, DeepSeek. Il permet de découper un LLM sur plusieurs machines pour pouvoir l'exécuter. exo crée un cluster entre vos différents terminaux. Il s'appuie sur une connexion p2p à travers le réseau local. L'idée est très intéressante car en effet, on dispose de terminaux à la puissance mal exploitée. Un LLM est parfois trop lourd pour une seule machine et au lieu d'utiliser des ressources cloud, on utilise ce que l'on a sous la main.

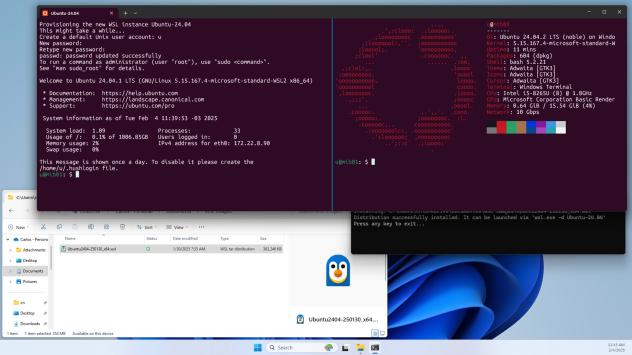

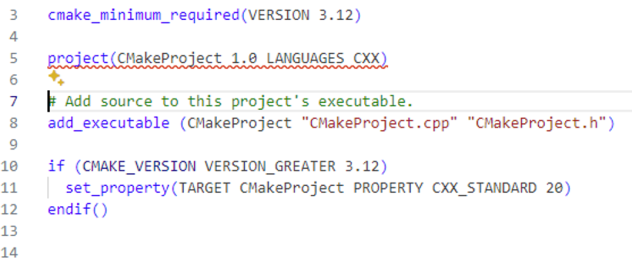

exo nécessite Python 3.12. Sur Linux, il faut les pilotes NVIDA, le toolkit CUDA et cuDNN. exo découvre automatiquement les autres instances exo. Attention à bien être sur le même réseau. Il fonctionne sur Pi et macOS.

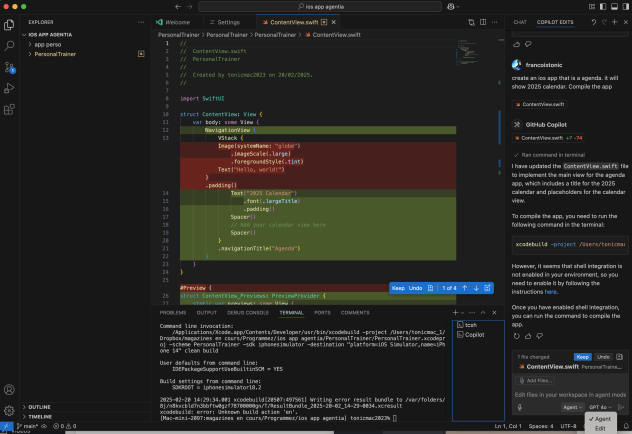

Il est recommandé d'installer exo via les sources en attendant des binaires stabilités.