Pixelmator Pro arrive (enfin) sur iPad : 3 fonctionnalités à tester en premier

![]()

![]()

Alimentation déplacée en façade, design bois en option et un écran 6,0 pouces pour piloter le tout : le Thermaltake TR300 joue la carte de l’optimisation interne sans sacrifier le refroidissement.

Thermaltake lance la série de boîtiers TR300, un mid-tower ATX décliné en TR300 TG (mesh sobre) et TR300 WS (lattes de bois), en Black ou Snow. Les spécifications internes sont identiques, seule la face avant change d’esthétique tout en conservant le même niveau d’airflow et de compatibilité.

Le Thermaltake TR300 adopte un emplacement d’alimentation monté en façade sur un rack ajustable offrant quatre positions selon la taille de la carte mère. Objectif : optimiser l’espace, améliorer les flux d’air, dégager la place pour le GPU et accepter des radiateurs et combinaisons de ventilateurs plus épais.

Compatibilité cartes mères : Mini-ITX, microATX, ATX. Les slots PCIe sont positionnés pour garantir l’alignement correct du GPU, quelle que soit la plateforme.

Le Thermaltake TR300 accepte jusqu’à 8 ventilateurs 120 mm et un radiateur 360 mm en top. Il est livré avec un 120 mm arrière sur roulement hydraulique pour contenir le bruit dès la sortie de boîte.

En option, un écran LCD 6,0″ (1480 × 720) piloté par TT RGB PLUS 3.0 affiche la télémétrie en temps réel, des images JPG/GIF, des visuels générés via AI Forge, et se contrôle aussi depuis l’app TT PlayLink sur mobile.

Le Thermaltake TR300 prévoit jusqu’à 2 × 3,5″ HDD et 3 × 2,5″ SSD, des filtres à poussière amovibles, et un I/O en façade avec 2 × USB 3.0 Type-A, 1 × USB 3.2 Gen 2 Type-C, audio HD, boutons Power et Reset.

Le TR300 WS ajoute une touche bois qui tempère l’allure sans étouffer l’airflow, tandis que le TR300 TG reste dans un registre mesh épuré. Les deux misent sur une architecture interne dégagée par le PSU frontal, favorable aux cartes graphiques longues et aux boucles AIO épaisses.

Déplacer l’alimentation en façade est une option rarement vue sur du mid-tower grand public. Ce choix libère la zone inférieure et facilite les montages haut débit d’air, une approche qui pourrait inspirer d’autres constructeurs si les contraintes de câblage restent bien maîtrisées.

Source : TechPowerUp

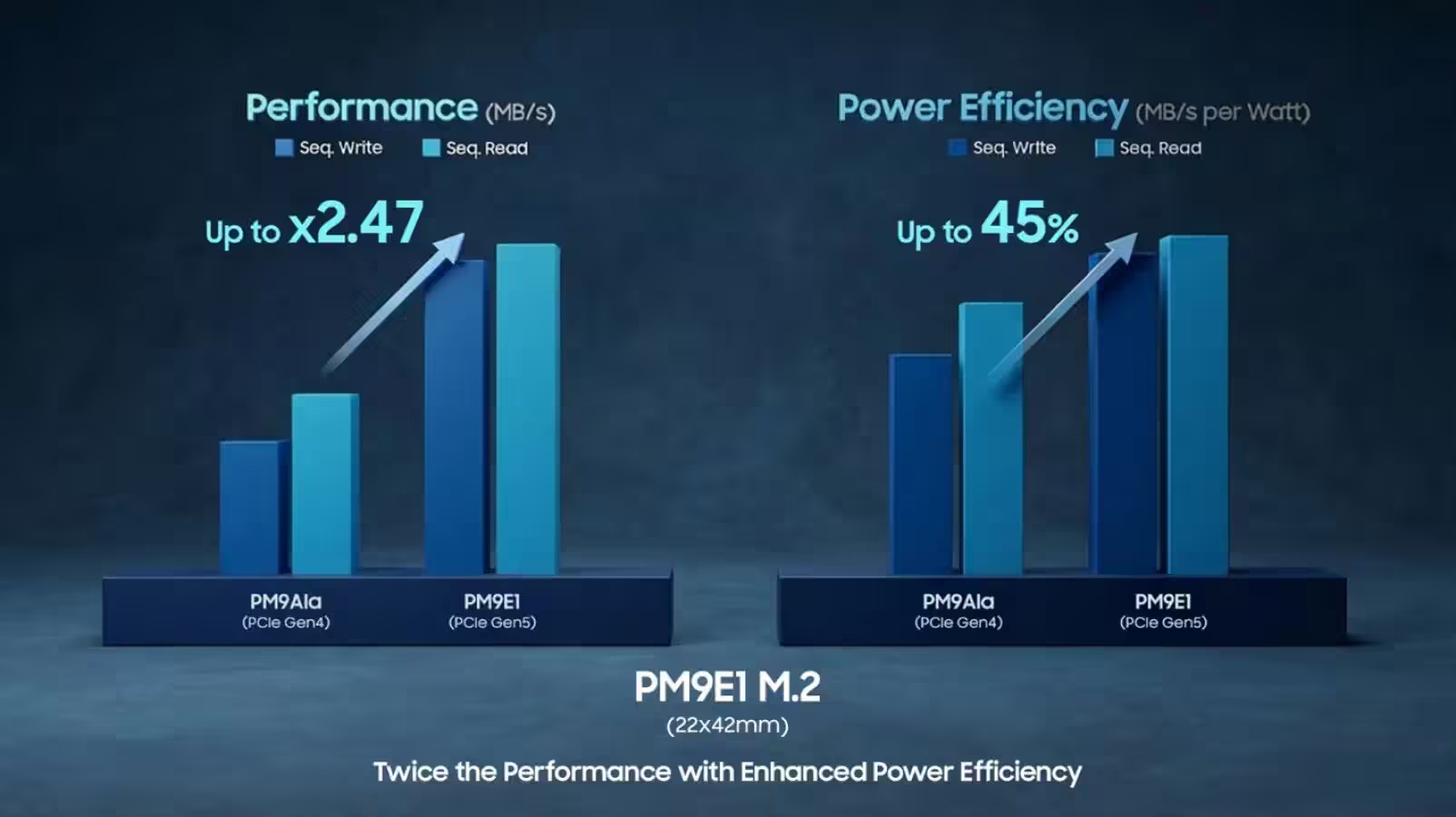

Un SSD 4 To à 14,5 Go/s dans un format M.2 22×42 n’était pas censé exister si tôt. Samsung le fait, et c’est taillé pour les postes IA de bureau.

Samsung dévoile le PM9E1, premier SSD PCIe Gen 5 de 4 To au format M.2 22×42, pensé pour les stations locales et l’IA on-device. La marque annonce des performances doublées et jusqu’à 45 % d’efficacité énergétique en plus face à la génération précédente, un point clé pour des configurations denses.

Au cœur de ce Samsung PM9E1, le contrôleur maison Presto gravé en 5 nm (Samsung Foundry), avec firmware optimisé pour l’OS du NVIDIA DGX Spark, CUDA et des scénarios IA exigeants. L’architecture intègre de la DRAM dédiée et de la V-NAND 8e génération 1 Tb sur PCB double face, garantissant une capacité élevée et un débit soutenu malgré la compacité du 22×42.

Côté chiffres : jusqu’à 14 500 MB/s en lecture séquentielle et 12 600 MB/s en écriture, jusqu’à 2 000K IOPS en lecture aléatoire et 2 640K IOPS en écriture aléatoire. L’objectif est clair : répondre à la double contrainte IA, entre transferts massifs et accès aléatoires à faible latence.

Le Samsung PM9E1 embarque le protocole de sécurité SPDM v1.2 pour l’authentification du périphérique, l’attestation firmware et l’établissement de canaux sécurisés, avec gestion par certificats. L’idée est d’éviter de diluer la puissance de calcul IA dans des vérifications logicielles coûteuses.

Déjà qualifié et produit en volume pour le NVIDIA DGX Spark, le Samsung PM9E1 conjugue performances, endurance opérationnelle et compacité pour tenir dans des boîtiers de bureau. Le format M.2 22×42 rapproche le stockage du calcul, réduit les longueurs de pistes et facilite le design thermique grâce à une consommation mieux maîtrisée.

Pour les intégrateurs et créateurs, l’équation est intéressante : un support PCIe 5.0 haute densité réellement exploitable dans des builds compacts, avec un pipeline optimisé CUDA/OS qui limite les goulots d’étranglement côté données. À court terme, ce type de SSD pourrait devenir la brique de base des stations IA « desktop » où chaque centimètre et chaque watt comptent.

Source : TechPowerUp

Depuis plus de quarante ans, l’ESGI se présente comme un acteur structurant de la formation en informatique en France. Fondée en 1983, l’École Supérieure de Génie Informatique a accompagné les grandes mutations du numérique en faisant un choix clair : placer la professionnalisation et l’alternance au cœur de son modèle pédagogique, afin de répondre au […]

Depuis plus de quarante ans, l’ESGI se présente comme un acteur structurant de la formation en informatique en France. Fondée en 1983, l’École Supérieure de Génie Informatique a accompagné les grandes mutations du numérique en faisant un choix clair : placer la professionnalisation et l’alternance au cœur de son modèle pédagogique, afin de répondre au […]  Depuis l’entrée en vigueur de l’Online Safety Act, le Royaume-Uni multiplie les initiatives pour encadrer les usages numériques des plus jeunes. Ce cadre législatif, pensé pour limiter l’accès des mineurs à des contenus jugés préjudiciables, a toutefois entraîné des effets indirects. Parmi eux, une adoption massive des VPN par les internautes, perçus comme un moyen […]

Depuis l’entrée en vigueur de l’Online Safety Act, le Royaume-Uni multiplie les initiatives pour encadrer les usages numériques des plus jeunes. Ce cadre législatif, pensé pour limiter l’accès des mineurs à des contenus jugés préjudiciables, a toutefois entraîné des effets indirects. Parmi eux, une adoption massive des VPN par les internautes, perçus comme un moyen […]  Depuis le déploiement des AI Overviews dans Google, les relations entre le moteur de recherche et les éditeurs de contenus se tendent. En effet, ces aperçus générés par intelligence artificielle, placés en tête des résultats, synthétisent des informations issues de multiples sites, sans forcément inciter les internautes à cliquer vers les sources originales. Au Royaume-Uni, […]

Depuis le déploiement des AI Overviews dans Google, les relations entre le moteur de recherche et les éditeurs de contenus se tendent. En effet, ces aperçus générés par intelligence artificielle, placés en tête des résultats, synthétisent des informations issues de multiples sites, sans forcément inciter les internautes à cliquer vers les sources originales. Au Royaume-Uni, […]  Ces dernières années, l’IA a bouleversé les équilibres économiques et juridiques du secteur culturel et médiatique. Mais face à cette situation, les institutions européennes cherchent encore la bonne formule pour concilier l’innovation technologique et le respect du droit d’auteur, dans un cadre jugé aujourd’hui insuffisant pour les créateurs… Le Parlement européen réclame un contrôle accru […]

Ces dernières années, l’IA a bouleversé les équilibres économiques et juridiques du secteur culturel et médiatique. Mais face à cette situation, les institutions européennes cherchent encore la bonne formule pour concilier l’innovation technologique et le respect du droit d’auteur, dans un cadre jugé aujourd’hui insuffisant pour les créateurs… Le Parlement européen réclame un contrôle accru […]  Google poursuit sa transformation de Google Chrome avec l’arrivée d’Auto Browse, où le navigateur ne se contente plus d’afficher des pages web, mais agit également. Portée par Gemini 3, cette nouvelle fonctionnalité ajoute une navigation dite « agentique », capable d’exécuter des tâches complètes en ligne à la place de l’utilisateur, ce qui n’est pas sans rappeler […]

Google poursuit sa transformation de Google Chrome avec l’arrivée d’Auto Browse, où le navigateur ne se contente plus d’afficher des pages web, mais agit également. Portée par Gemini 3, cette nouvelle fonctionnalité ajoute une navigation dite « agentique », capable d’exécuter des tâches complètes en ligne à la place de l’utilisateur, ce qui n’est pas sans rappeler […]  Le marché des véhicules autonomes connaît une nouvelle phase d’accélération, portée par des acteurs capables de combiner l’intelligence artificielle, les partenariats industriels et la capacité de financement. Longtemps concentrée sur le transport routier de marchandises, la start-up Waabi s’invite désormais sur un terrain très exposé médiatiquement : celui des robotaxis. Une évolution qui s’inscrit dans […]

Le marché des véhicules autonomes connaît une nouvelle phase d’accélération, portée par des acteurs capables de combiner l’intelligence artificielle, les partenariats industriels et la capacité de financement. Longtemps concentrée sur le transport routier de marchandises, la start-up Waabi s’invite désormais sur un terrain très exposé médiatiquement : celui des robotaxis. Une évolution qui s’inscrit dans […]  La question de la dépendance technologique vis-à-vis des acteurs américains revient régulièrement dans le débat public européen. Ces dernières semaines, elle a pris une nouvelle dimension, portée par un contexte géopolitique tendu et des déclarations venues des États-Unis. Pour certains acteurs numériques français, cette situation agit comme un révélateur des attentes du marché, notamment autour […]

La question de la dépendance technologique vis-à-vis des acteurs américains revient régulièrement dans le débat public européen. Ces dernières semaines, elle a pris une nouvelle dimension, portée par un contexte géopolitique tendu et des déclarations venues des États-Unis. Pour certains acteurs numériques français, cette situation agit comme un révélateur des attentes du marché, notamment autour […]  Depuis plusieurs mois, les éditeurs d’outils d’IA cherchent à s’imposer comme des interfaces centrales du travail numérique. Et après OpenAI et son magasin d’applications, Anthropic accélère à son tour. Avec une nouvelle mise à jour, Claude franchit une étape supplémentaire en interagissant directement avec des applications professionnelles largement utilisées en entreprise… Claude s’intègre aux outils […]

Depuis plusieurs mois, les éditeurs d’outils d’IA cherchent à s’imposer comme des interfaces centrales du travail numérique. Et après OpenAI et son magasin d’applications, Anthropic accélère à son tour. Avec une nouvelle mise à jour, Claude franchit une étape supplémentaire en interagissant directement avec des applications professionnelles largement utilisées en entreprise… Claude s’intègre aux outils […]  Depuis la transformation de Twitter en X, le paysage du microblogging s’est largement fragmenté. Entre Mastodon, Threads et d’autres initiatives plus ou moins centralisées, une plateforme s’est progressivement imposée comme une alternative crédible : Bluesky. Lancé au grand public en 2024 après une longue phase sur invitation, le réseau social décentralisé revendique désormais plus de […]

Depuis la transformation de Twitter en X, le paysage du microblogging s’est largement fragmenté. Entre Mastodon, Threads et d’autres initiatives plus ou moins centralisées, une plateforme s’est progressivement imposée comme une alternative crédible : Bluesky. Lancé au grand public en 2024 après une longue phase sur invitation, le réseau social décentralisé revendique désormais plus de […]  Après plusieurs années de croissance portée par l’e-commerce et la publicité, Pinterest entame un nouveau virage stratégique. Comme de nombreux acteurs, l’entreprise californienne revoit son organisation interne afin de concentrer davantage de moyens sur l’IA. Une réorientation qui se traduit par une décision lourde de conséquences pour ses équipes… Pinterest annonce une réduction de près […]

Après plusieurs années de croissance portée par l’e-commerce et la publicité, Pinterest entame un nouveau virage stratégique. Comme de nombreux acteurs, l’entreprise californienne revoit son organisation interne afin de concentrer davantage de moyens sur l’IA. Une réorientation qui se traduit par une décision lourde de conséquences pour ses équipes… Pinterest annonce une réduction de près […] Deux nouveaux sièges tentent d’apporter de l’ergonomie sérieuse au bureau sans prix stratosphérique. Conséquence directe : Sharkoon cible les postes fixes et le télétravail avec des specs complètes à 299,90 €.

Les OfficePal C50 et C50M partagent un châssis orienté ergonomie avec dossier en maille (mesh), réglages complets et appuis dédiés. La différence majeure : le C50 combine dossier mesh et assise traditionnelle, quand le C50M opte pour un duo mesh (assise et dossier).

Les deux modèles embarquent des accoudoirs 5D, un appui-tête et un soutien lombaire réglables. S’ajoutent hauteur d’assise, profondeur d’assise et inclinaison du dossier, plus une fonction bascule pour relâcher la posture lors des longues sessions.

Sur le C50, l’assise reste rembourrée de façon classique, tandis que le dossier respire grâce à la maille. Le C50M pousse le concept mesh sur l’assise et le dossier, pour une ventilation homogène. Dans les deux cas, les 5D autorisent un ajustement fin des accoudoirs selon la morphologie et la position de travail.

La base cinq branches en métal se monte facilement selon la marque et s’accompagne de roulettes de 60 mm, annoncées compatibles avec divers revêtements de sol. Objectif : stabilité, mobilité et usure réduite sur le long terme.

Les OfficePal C50 et C50M sont disponibles dès maintenant au prix conseillé de 299,90 € chacun.

À ce tarif, Sharkoon place le duo face aux sièges bureautiques milieu de gamme où les 5D et un vrai réglage lombaire restent encore rares. L’option assise mesh du C50M vise clairement les postes chauds et les longues journées, tandis que le C50 conserve le confort d’un rembourrage classique.

Source : TechPowerUp

Des projets Linux gaming concurrents choisissent désormais la maintenance partagée. Conséquence immédiate : moins de forks longs, plus d’upstream.

Bazzite officialise l’Open Gaming Collective (OGC), un groupe de travail commun pour résoudre les problèmes de base du stack gaming Linux. Objectif : pousser des correctifs en amont sur les composants partagés, réduire la maintenance en doublon et laisser chaque distro se concentrer sur ses fonctionnalités et son expérience utilisateur.

Les membres fondateurs listés : Universal Blue et Bazzite, ASUS Linux, ShadowBlip, PikaOS et Fyra Labs. Des partenaires stratégiques et contributeurs clés complètent la liste : ChimeraOS, Nobara et Playtron.

Le périmètre porte sur la « plomberie » du stack : un projet OGC Kernel et un fork en aval de Gamescope pour élargir la prise en charge matérielle. La politique affichée est claire : upstream first. Le code doit atterrir dans les projets d’origine, pas dans des forks permanents.

Bazzite acte la fin des mises à jour de HHD, remplacé progressivement par InputPlumber. Ce framework d’entrée est le même que celui employé dans SteamOS et plusieurs distributions orientées consoles portables, gage d’un comportement homogène des périphériques.

Autre évolution : des tests ont démarré autour de Faugus Launcher comme possible remplaçant de Lutris dans la branche de test. En cas de retrait de Lutris, Bazzite annonce un délai de prévenance d’au moins six mois.

La mutualisation sur l’OGC Kernel et Gamescope doit accélérer la prise en charge matérielle et stabiliser l’exécution des jeux, tout en limitant l’entretien de patchs spécifiques. Pour les projets partenaires, la réduction de dette technique libère des ressources pour l’UX, les launchers et l’intégration des services.

Au-delà des annonces, l’adoption stricte de l’upstream first sera l’indicateur clé. Si elle tient, les portages et mises à jour du stack graphique devraient gagner en cadence, avec un bénéfice direct pour les consoles Linux et PC de salon.

Source : VideoCardz

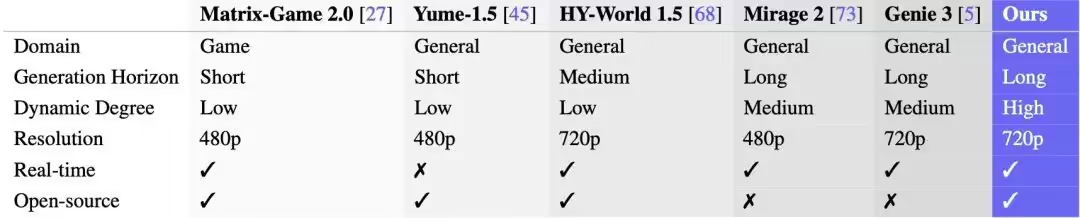

Ant Group ouvre le code de LingBot-World, un cadre de « world model » interactif pensé pour générer des environnements vidéo contrôlables, physiquement cohérents et manipulables en temps réel. Au cœur, LingBot-World-Base s’appuie sur un Scalable Data Engine entraîné sur de grands environnements de jeu pour apprendre lois physiques et causalité, puis restituer des scènes réactives sans dérives structurelles sur de longues séquences.

Le modèle vise la résistance au « long-term drift » qui plombe la génération vidéo classique: déformations, disparition de sujets, collapses de géométrie. Par un entraînement multi-étapes et une exécution parallélisée, Ant Lingbo annonce près de 10 minutes de génération continue sans dégradation visible, avec des tests de retour caméra après 60 secondes hors-champ où les objets clés conservent forme et apparence.

La génération est conditionnée par l’action: clavier et souris pilotent personnage et caméra à environ 16 FPS, avec une latence bout en bout maintenue sous la seconde. Les commandes textuelles déclenchent des événements d’environnement (météo, style visuel) tout en maintenant des relations géométriques stables, ce qui permet d’enchaîner des transitions sans casser la cohérence de la scène.

Pour alimenter l’entraînement en données d’interaction, l’équipe combine un nettoyage massif de vidéos web et une captation in‑engine via jeux et pipeline Unreal Engine, en extrayant des rendus sans UI et en enregistrant commandes et poses caméra au pas de temps. Ce mix améliore la généralisation zero-shot: à partir d’une simple photo de rue réelle ou d’une capture de jeu, le modèle génère un flux vidéo interactif sans fine-tuning spécifique au décor.

Ant Lingbo met en ligne poids et code d’inférence. Le dépôt et la documentation sont accessibles à l’adresse suivante: https://technology.robbyant.com/lingbot-world

Si les promesses d’endurance temporelle et de contrôle se confirment, LingBot-World pourrait accélérer l’émergence d’agents temps réel entraînés dans des mondes génératifs plutôt que dans des bacs à sable fixes. Pour l’industrie, l’intérêt est double: abaisser le coût des données d’interaction de qualité et rapprocher la simulation des contraintes physiques utiles au gameplay et à la robotique logicielle, avec un délai de réponse compatible usage utilisateur.

Source : ITHome

Ce matin, je cherchais un moyen simple de tester des webhooks en local sans passer par ce bon vieux Ngrok qui est devenu un peu relou avec ses limites en version gratuite. J'ai d'abord pensé à monter mon propre serveur VPN (coucou Tailscale), mais franchement flemme.

Et puis tout à fait par hasard (aaah les joies de la sérendipité) je suis tombé sur cet outil qui devrait vous plaire, surtout si vous développez des applis qui doivent recevoir des notifications HTTP (GitHub, Stripe, Slack...). Ben oui vous connaissez la galère... votre serveur de dev est sur "localhost", donc inaccessible depuis l'extérieur, du coup, impossible de recevoir ces fameux webhooks sans ouvrir votre routeur ou utiliser un tunnel.

C'est là qu'intervient Webhooks Proxy Tunnel !

Grâce à cet outil, au lieu de multiplier les intermédiaires, vous déployez votre propre tunnel... directement sur l'infrastructure de Cloudflare. Et le meilleur c'est que ça tourne généralement très bien sur leur offre gratuite (dans la limite des quotas Workers évidemment, donc attention si vous bourrinez comme un fifou).

L'outil utilise un Cloudflare Worker couplé à un Durable Object (une sorte de mini-serveur d'état). Le Worker reçoit alors les requêtes publiques sur une URL en HTTPS (genre "truc.workers.dev") et les transmet via une WebSocket à un petit client Node.js qui tourne sur votre machine. Et hop, le trafic arrive sur votre port local.

Perso, je trouve ça brillant car même si le trafic passe techniquement par Cloudflare (puisque c'est leur infra), vous gardez la main sur le code qui s'exécute et vous évitez d'envoyer vos données à un service tiers supplémentaire dont vous ignorez tout.

Pour l'installer, ne plus c'est hyper fastoche. Il vous faut juste un compte Cloudflare et Node.js. J'ai testé l'install en moins de 5 minutes, vous clonez le dépôt, vous installez les dépendances et vous lancez le déploiement (qui vous demandera de vous authentifier) :

git clone https://github.com/peter-leonov/webhooks-proxy-tunnel.git

cd webhooks-proxy-tunnel/worker

npm install

npm run deploy

Une fois déployé, le script vous donne une URL et il ne vous reste plus alors qu'à lancer le client local en lui disant où taper (par exemple votre port 3000) et le tour est joué !! Vous pouvez même gérer plusieurs tunnels en parallèle si vous bossez sur plusieurs projets, chaque tunnel ayant son ID unique.

Attention quand même, c'est conçu pour du développement hein, pas pour streamer de la 4K. Les requêtes doivent tenir en mémoire (limite de 100 Mo environ) donc sauf si vous transférez des fichiers énormes via vos webhooks, ça passera crème pour du JSON ou des petits payloads binaires.

Voilà, si vous cherchiez une alternative self-hosted et gratuite pour vos tests, c'est clairement un outil à garder sous le coude. Et si vous avez besoin de trucs plus costauds pour du réseau d'entreprise, jetez un œil à Tailscale ou Octelium .

Faire du bruit avec du code, c'est un peu le graal pour tout dev qui aime la musique. On connaît tous les gros trucs en C++ ou les frameworks spécialisés, mais voir débarquer un synthé complet codé en Go, c'est toujours une petite surprise qui se déguste sans modération.

Son nom : Footywhoops .

C'est un couteau suisse sonore que vous pilotez directement depuis votre terminal et qui permet de générer des séquences de batterie, des lignes de basse (un mode "Acid Bass" bien gras avec sub-oscillateur et enveloppes ADSR est de la partie), des arpèges et des mélodies. Le tout peut être calé sur différentes gammes musicales (majeure, mineure, dorienne, blues, etc.) pour éviter de finir avec une cacophonie insupportable. On est un peu dans l'esprit du live coding musical comme ce que propose Strudel ou Dittytoy , mais version ligne de commande.

Sous le capot, c'est du sérieux niveau DSP (Digital Signal Processing) puisqu'on y trouve une réverbération de type Schroeder pour donner de l'espace, plusieurs algorithmes de distorsion (Tanh, Atan, hard clipping) pour salir le signal, et un filtre passe-bas pour sculpter la tonalité. Et pour ceux qui se demanderaient quel est le meilleur langage pour la programmation audio, le C++ reste le roi pour la performance pure, mais Go s'en sort étonnamment bien ici grâce à sa gestion efficace de la concurrence (coucou les goroutines) et l'utilisation de PortAudio pour l'I/O audio. On a d'ailleurs vu d'autres outils sympas en Go récemment, comme SSHM qui utilise le framework Bubble Tea pour son interface terminal.

Le truc est super léger et s'installe en deux minutes si vous avez l'environnement Go prêt sur votre machine. Vous pouvez même enregistrer vos expérimentations directement en WAV (dry ou wet) sans avoir besoin de passer par une DAW (Digital Audio Workstation). D'ailleurs, si vous cherchez des ressources pour faire de la musique sous pingouin, n'hésitez pas à consulter ce catalogue audio pour Linux .

Et si vous avez envie de tester ce petit monstre, voici comment vous lancer.

Pour commencer, vous aurez besoin de Go 1.19 ou plus et des bibliothèques de développement de PortAudio sur votre système.

1. Installation des dépendances

Sur macOS :

brew install portaudio

Sur Ubuntu/Debian :

sudo apt-get install portaudio19-dev

2. Compilation du projet

Récupérez le code et compilez l'exécutable :

git clone https://github.com/system32-ai/footywhoops

cd footywhoops

go build

3. Exemples d'utilisation

Pour lancer une génération automatique de mélodie et de batterie (le mode "standalone") :

./footywhoops -mode synth

Si vous voulez utiliser Footywhoops comme un processeur d'effets (par exemple pour traiter le son de votre micro ou d'une guitare branchée sur votre interface) :

./footywhoops -mode fx -dist 0.8 -reverb 0.5

Vous pouvez évidemment jouer avec plein de paramètres en CLI pour ajuster le son (fréquence du filtre, type de distorsion, taille de la réverb, etc.). Pour voir toutes les options disponibles, un petit ./footywhoops -help et voilà, vous avez la liste complète.

Je pense que j'ai fait le tour... si vous aimez le mélange entre code et synthèse sonore, Footywhoops est un super terrain de jeu. C'est brut, c'est sale, et c'est expérimental mais ça permet de s'amuser un peu !