GPT-5.2 visé : citations Grokipedia fragilisent l’usage pro et la traçabilité

OpenAI présente GPT-5.2 comme son modèle « le plus avancé pour le travail professionnel ». Une série de tests conduite par le Guardian met pourtant en cause sa fiabilité sur des sujets sensibles, pointant des réponses s’appuyant sur Grokipedia, l’encyclopédie en ligne de xAI déjà critiquée pour ses sources problématiques.

Le quotidien britannique a constaté que ChatGPT citait Grokipedia lorsqu’il répondait à des questions liées à l’Iran, notamment autour d’allégations sur des liens entre le gouvernement et MTN Iran, ainsi que sur des points touchant l’historien Richard Evans, expert lors du procès en diffamation impliquant le négationniste David Irving. En revanche, sur d’autres terrains inflammables comme un supposé biais médiatique en faveur de Donald Trump, l’outil n’aurait pas fait appel à Grokipedia.

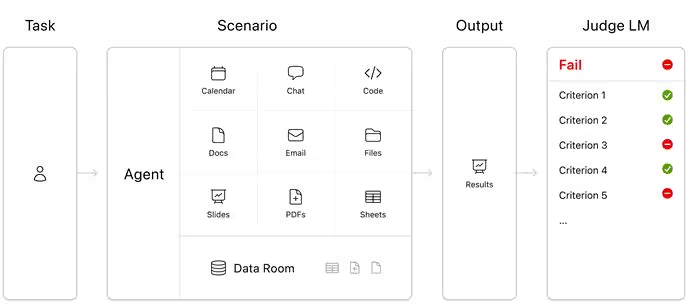

Lancé en décembre, GPT-5.2 cible les usages pros, de la production de feuilles de calcul à la gestion de tâches complexes. Grokipedia, antérieure au modèle, a déjà suscité des critiques pour avoir agrégé des références issues de forums néonazis. Des travaux universitaires américains ont également relevé des citations « douteuses » et des sources « problématiques » dans cette encyclopédie générée par IA.

Interrogé, OpenAI explique que GPT-5.2 interroge « des sources et points de vue publiquement accessibles variés » tout en appliquant des filtres de sécurité destinés à réduire l’exposition à des contenus à risque. La formulation reste prudente et ne précise ni le poids accordé à chaque source ni les critères d’exclusion dynamiques.

Contexte et portée des tests

Le constat du Guardian ne vaut pas audit exhaustif du graphe de connaissances de GPT-5.2, mais souligne un angle mort : sur des sujets polarisés, les citations peuvent basculer vers un référentiel controversé sans signalisation claire. Le fait que Grokipedia ne soit pas invoquée de manière systématique renforce l’idée d’une pondération contextuelle, difficile à prédire.

Le différentiel de comportement selon le thème pose une question de gouvernance des sources, au-delà des garde-fous de sécurité. Dans un cadre professionnel, où traçabilité et conformité documentaire priment, l’absence d’explicitation des priorités de citation devient un point de friction.

Implications pour les usages pros

Pour des workflows qui exigent une chaîne de sources vérifiables, l’appel potentiel à une encyclopédie contestée affaiblit la valeur probante des sorties, même si celles-ci restent factuellement correctes. Les entreprises devront durcir les politiques d’attribution, imposer des listes blanches de référentiels et exiger la restitution des citations primaires plutôt que des méta-sources.

L’enjeu dépasse le filtrage des contenus à risque : il s’agit de hiérarchiser des corpus reconnus, de préférence à des agrégateurs dont la gouvernance éditoriale est mouvante. Sans granularité de contrôle côté modèle, le besoin se reporte sur l’orchestration applicative et l’audit humain des réponses sensibles.

À court terme, cette controverse rappelle que les modèles « généralistes » restent fragiles dès qu’ils mêlent assistance à la rédaction et autorité documentaire. Le marché ira vers des piles hybrides combinant LLM, moteurs de RAG verrouillés sur des sources certifiées et politiques d’archivage des citations, faute de quoi la promesse « pro » se heurte à des exigences de conformité que la seule modération automatisée ne couvre pas.

Source : ITHome

}}

}}